日前,英特尔、谷歌、微软、Meta以及其他科技巨头宣布成立一个新的行业组织——“Ultra Accelerator Link (UALink) 推广组”。目前,UALink推广组正在抓紧制定一项新的行业标准,用于推进数据中心内连接的大规模AI系统的高速和低延迟通信,摆脱英伟达NVLink在AI加速器连接方面的统治。

对于这项新的行业标准,AMD数据中心解决方案总经理Forrest Norrod表示,“行业需要一个可以快速推进的开放标准,这种标准允许多家公司为整个生态系统增加价值。”

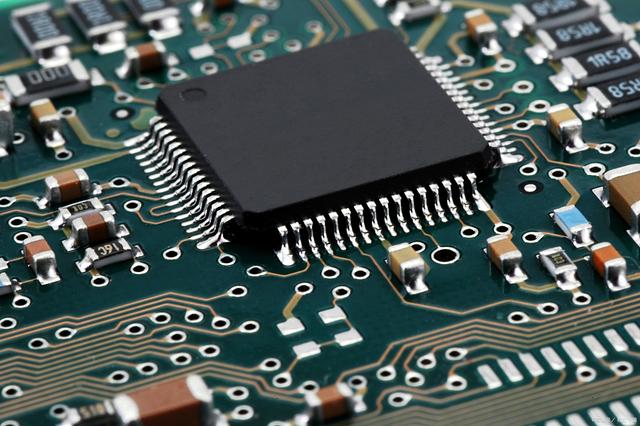

英伟达统治AI加速器市场

有分析观点认为,英伟达在AI加速器方面的统治力,已经超过了当年英特尔对于PC处理器的统治,这让英伟达享受到了AI时代巨大的产业红利。根据英伟达2025财年第一财季财报,该公司营收达到260亿美元,同比增长262%;净利润高达148.1亿美元,同比上升628%。

那么,英伟达为什么能够在AI加速器领域体现出如此强悍的统治力呢?笔者认为主要源于三点:核心芯片、软件生态和连接技术。

在核心芯片方面,时间回溯到2020年,在GTC 2020上,英伟达推出了基于Ampere架构的新一代GPU——NVIDIA A100,这颗芯片作为通用型工作负载加速器,成为国内外AI科技巨头争抢购买的芯片,此后甚至被禁止出口到中国市场。NVIDIA A100展现了AI加速器发展的“暴力美学”,以英伟达的数据来说,NVIDIA A100相较于前一代性能暴涨了20倍。在GTC 2024上,英伟达又推出了B100芯片,架构代号为Blackwell,显存达192GB。在AI加速器芯片方面,英伟达并不是单单某一颗产品强,而是拥有一个强大的产品矩阵。在架构方面,英伟达陆续推出了Volta架构、Turing架构、Ampere架构、Hopper架构和Blackwell架构,提供B100、H200、L40S、A100、A800、H100、H800、V100等众多的芯片产品组合。

同时,针对这些产品,英伟达提供强大的软件支持。就以英伟达的CUDA生态来说,无论是通用加速,还是计算加速,CUDA生态都能够提供充足的支持。英伟达自2006年推出CUDA以来,CUDA和GPU的并行计算能力使英伟达收获了庞大的用户群。CUDA 平台包括硬件架构和编程模型,为开发人员提供了更直接、高效地利用 GPU 进行并行计算的方式。在COMPUTEX 2023 大会期间,英伟达方面透露的数据显示,目前CUDA拥有超过400万开发人员,超过 3000个应用程序,历史上CUDA下载量达到惊人的4000万。更让当前阶段CUDA显得炙手可热的是,仅仅是在2022年,CUDA下载量就有惊人的2500万,目前依然在高速增长的状态。

英伟达在AI加速器方面,第三个显著的优势就是连接技术。AI算力集群是人工智能发展的重要基础设施,就以当前最火热的AI大模型来说,单卡是无法支撑的,需要一个强大的AI算力集群。如果是基于英伟达算力卡的集群,那么主要的连接技术是NVLink和InfiniBand技术,分别负责近距离并行计算和扩大集群规模。NVLink可以直接完成GPU之间内存的互相访问,无需CPU的干预。目前英伟达NVLink已经更新到了第五代,第五代NVLink大幅提高了大型多GPU系统的可扩展性。单个NVIDIA Blackwell Tensor Core GPU支持多达18个NVLink 100 GB/s连接,总带宽可达1.8 TB/s,比上一代产品提高了两倍,是PCIe 5.0带宽的14倍之多。72-GB200 GPU NVLink域(NVL72)等服务器平台利用该技术为当今异常复杂的大型模型提供更高的可扩展性。

同时,英伟达还有NVSwitch。NVSwitch芯片是一种类似交换机ASIC的物理芯片,通过NVLink接口可以将多个GPU高速互联到一起,从而提升服务器内部多个GPU之间的通讯效率和带宽。比如,NVIDIA A100 Tensor Core GPU引入了第三代 NVLink和第二代 NVSwitch,使每CPU带宽和减少带宽都增加了一倍。如果是通过第四代 NVLink和第三代NVSwitch,可以连接八个NVIDIA H100 Tensor Core GPU的系统,具有3.6 TB / s的二等分带宽和450 GB / s的缩减操作带宽,与上一代相比,这两个数字分别增加了1.5倍和3倍。

综上所述,英伟达在AI加速器方面拥有非常全面的布局,且这种系统性方案是目前最好的AI加速方式,没有之一。统计数据显示,目前英伟达在AI加速器芯片市场的占比超过了九成,被称为人工智能领域“无可争议的领导者”。当然,这也就意味着,除英伟达AI加速器芯片外,其他厂商的芯片很难捕捉到市场机会,即便是国际大厂推出的相关芯片。一个重要的原因在于,英伟达这套围绕AI加速器布局的系统,不仅强大而且封闭,对非英伟达芯片的兼容性很差,这也被称为AI芯片发展的“英伟达路径”。让厂商很绝望的是,如果选择顺从这条路径,其产品也无法对英伟达芯片造成很大的冲击,除非是面向某些特殊的用途。

因此,英特尔、谷歌等科技巨头现在希望从连接入手,在英伟达AI加速器生态圈上撕开一个口子,以获取更多的市场份额。

UALink野心勃勃但也有隐忧

除了英特尔、谷歌、微软、Meta这四家,UALink联盟成员还包括AMD、惠普企业、博通和思科等,不过作为主要的核心供应商,Arm公司尚未参加。UALink联盟的主要职责是监督UALink规范未来的发展。

UALink联盟认为,UALink和行业规范对于标准化下一代AI数据中心和实现的 AI 和机器学习、HPC 和云应用程序接口至关重要,该小组将制定一项规范,定义AI计算舱中加速器和交换机之间扩展通信的高速、低延迟互连。

目前,UALink联盟提议的第一个版本UALink 1.0连接多达1024个AI加速器,UALink 1.0基于包括AMD的Infinity Fabric在内的开放标准。AMD的Infinity Fabric采用了一种分布式架构,其中包含多个独立的通道,每个通道都可以进行双向数据传输。这种设计使得不同核心之间可以直接进行快速而低延迟的通信,从而提高了整体性能。Infinity Fabric分为SCF和SDF。SDF负责数据传输,而SCF则负责控制传输命令。

从技术演进来看,如果Infinity Fabric技术成为UALink规范的主要组成部分,那么用户可能会担心UALink 1.0最终的连接效率问题。据悉,Infinity Fabric中的SDF部分基本是HT总线衍生的产物,这个总线原本是用于CPU的串联,而UALink 1.0的使用场景是GPGPU,两者之间在并行数据量要求方面差异巨大。因此,有业者认为,UALink 1.0规范预计不会规模性进入市场,只是奠定UALink规范的基础框架,但很难对NVLink+NVSwitch这套体系造成很大的挑战。

当然,博通和思科会积极地完善UALink 1.0以及后续的标准,博通可能会在800Gbps的 Thor产品中推出一款早期的Ultra Ethernet NIC,思科则预计将研发对标NVSwitch的相关产品。另外,目前已经加入的各家巨头,也都是各自有自己的小算盘:谷歌拥有用于训练和运行 AI 模型的定制芯片、TPU和Axion;微软Maia 100新芯片已经在Bing和Office AI产品上测试,急于进入市场;Meta此前公布了自主研发芯片MTIA的最新版本,这是专门为AI训练和推理工作设计的定制芯片系列。因此,有观点认为,一旦UALink成事,那么这些拥有自研芯片的公司将成为最大的受益者。但是,由于各自研芯片公司在芯片、架构、集群层面的理解不一,这也可能拖累UALink的发展,使得UALink虽然看上去有大批的创新力量,但是创新效率却不足。

结语

据悉,UALink 1.0将在同一时间向加入该联盟的公司提供,另外带宽更高的更新规范UALink 1.1将于2024年第四季度推出。由于英伟达不在这个联盟,也不必参加这个联盟,预计UALink 1.1推出时可能会选择直接对标某一代的NVLink。不过,在UALink能够全面对抗NVLink之前,包括微软和Meta在内的公司依然是大规模哄抢英伟达的AI加速器芯片。