概要:AI大模型发展面临GPU依赖,xAI获马斯克支持建AI工厂,使用英伟达H100 GPU。微软投入巨资建超算助OpenAI训练GPT-4,谷歌则并行使用TPU和GPU。大公司追求Scaling Laws以扩展模型,而GPU和AI芯片市场竞争激烈。

**AI大模型:巨头争霸,算力巅峰之战**

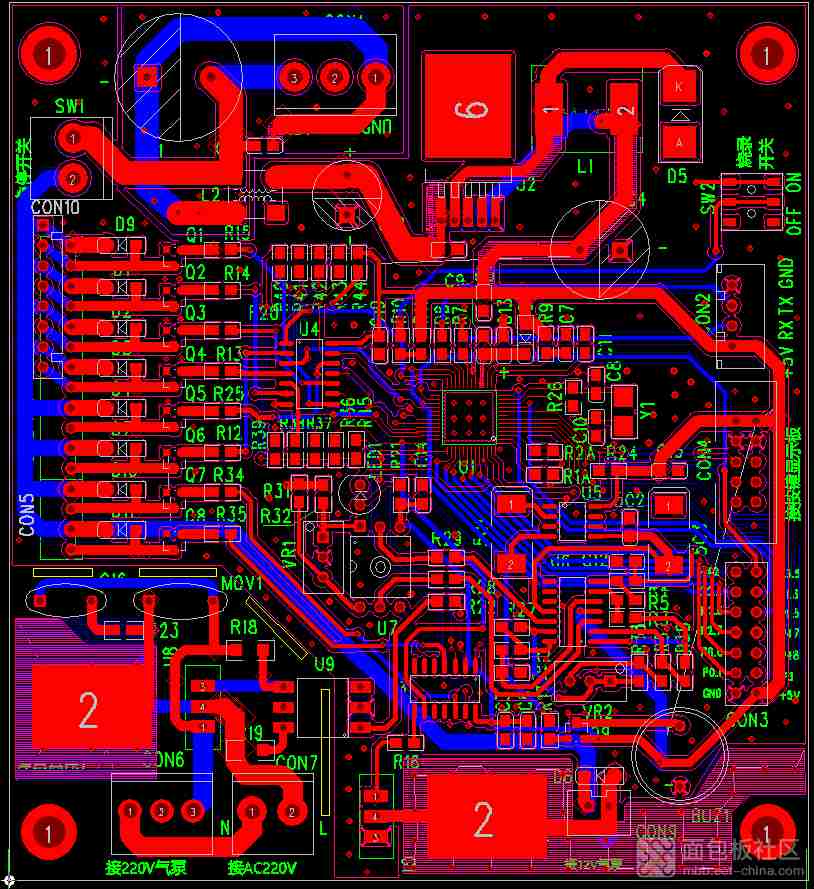

在AI大模型的浪潮中,一股强大的洪流正在席卷整个行业。尽管深度学习、数据优化和爆款应用的研究从未停歇,但“你有卡吗?”这一问题却成为了人们关注的焦点。GPU,作为这场算力竞赛的关键,似乎预示着未来大模型的发展将掌握在少数大公司手中。

**xAI携手巨头,打造AI超算新纪元**

xAI,这家成立于2023年3月的初创公司,却在算力基础设施的投入上展现出了非凡的魄力。背后有埃隆·马斯克的鼎力支持,xAI携手戴尔和超微,共同打造AI超算的新时代。近日,戴尔CEO Michael Dell宣布了他们正打造一个由英伟达GPU驱动的AI工厂,为xAI的Grok模型提供澎湃动力。然而,马斯克却透露,这只是冰山一角,另一半的超算系统则由超微打造。

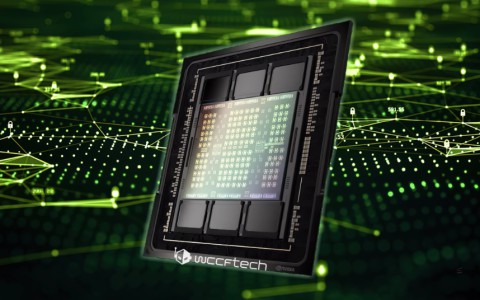

这一AI工厂,正是马斯克月初提及的10万块H100液冷训练集群的实体。尽管有两家巨头供应商同时助力,但市面上的GPU需求依然旺盛,预计数月后这一集群将正式上线,为Grok的下一代大模型迭代提供强大支撑。

**H100到B200,算力飞跃的新篇章**

H100,这款2023年发布的GPU,已然成为全球大模型算力供应的中流砥柱。从OpenAI到xAI,众多最新模型都是基于H100进行训练迭代的。然而,在技术的飞速演进下,马斯克已经开始瞄准了最新的B200。他认为,将1GW的电力供应给H100已不再是明智之选。

为此,xAI已经开始规划下一代系统。据马斯克透露,这一系统将由30万块B200 GPU组成,上线时间则定在明年夏天。B200的速度高达H100的4倍,单机柜算力更是高达1exaflop,同时在能耗成本上相比H100改善了20多倍。即便是大规模部署,也不会让厂商面临供电和碳足迹的双重困扰。

**特斯拉自研Dojo,技术路线尚不明朗**

尽管xAI的AI超算目标已经明确,但马斯克旗下的另一巨头特斯拉,其技术路线却仍显模糊。特斯拉虽然开启了新一轮的英伟达GPU采购潮,但内部也在持续发展自研的Dojo超算。然而,近年来Dojo的情报愈发稀少,就连马斯克本人也将其列入“远景计划”之列。

**微软与OpenAI,“鲸级”超算全速运转**

去年11月,微软的超算Eagle首次登上TOP500榜单,凭借14400个英伟达H100和561PFlop/s的算力,不仅让Azure系统再次闯入前十,还夺得了当下云端超算的最高排名。而这一切,仅仅是为了支持OpenAI的GPT-4训练和推理。

然而,这远非微软的终点。早在3月底,便有消息传出微软和OpenAI正在打造一个耗资高达1000亿美元的“星门”AI超算。微软CTO Kevin Scott在Microsoft Build上公开透露了他们的未来超算扩展计划:他们将以鲨鱼、虎鲸、蓝鲸这样的海洋生物来描述超算的规模。他们每个月都会部署五台与Eagle同等规模的超算,每月带来至少2.8exaflops的算力增长。同时,他们用于连接GPU的高速和InfiniBand线缆长度超过20万公里,足以绕地球五周。

**谷歌的Hypercomputer:TPU与GPU并驾齐驱**

在众多巨头纷纷考虑自研芯片以降低成本的背景下,谷歌的TPU已经成功应用于大模型的训练中。作为谷歌和博通联合设计的产品,TPU在谷歌的新模型训练与推理中占据了举足轻重的地位。谷歌作为AI算法和大模型领域的巨头,从设计之初就深知所需计算资源,因此TPU几乎将所有面积都用于低精度的张量计算单元,这种ASIC方案让谷歌大幅降低了AI Hypercomputer的成本。

然而,作为云服务厂商巨头,谷歌仍需面对通用性问题。TPU更多是为Gemini的模型做了优化,尽管支持PyTorch、Tensorflow等常见AI模型,但在追求极致性能上仍难以媲美GPU。因此,在谷歌和其他大模型开发者的眼中,TPU更像是一个性价比之选。谷歌在英伟达GPU上也投入了大量资源,通过双方的深度合作,谷歌的JAX框架也在英伟达的GPU上得到了支持。谷歌采取的是两手抓的策略,TPU和GPU一并重要。

**大厂逐鹿,Scaling Laws下的算力竞赛**

在AI大模型的世界里,模型大小、数据集大小和计算成本之间构成了三元关系,也决定了模型的性能。而Scaling Laws这一扩展