优化Triton编译器的性能可以从多个方面入手,以下是一些关键的优化策略:

一、算法层面的优化

-

合理的算法设计 :

- 开发者可以通过合理的算法设计,使得Triton实现的算子在性能上超越其他框架(如PyTorch)中的CUDA实现。

-

分块处理 :

- 在处理大规模数据时,可以采用分块处理策略,将数据分成多个小块进行处理,以减少内存访问延迟和提高数据重用率。

-

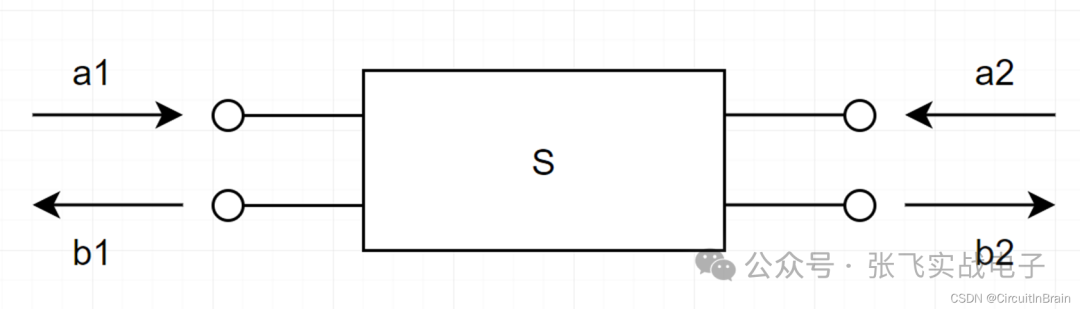

并行化 :

- 利用Triton编译器的并行化能力,通过多线程或多GPU并行处理来加速计算。

二、内存访问优化

-

优化内存布局 :

- 通过合理的内存布局,减少内存访问冲突和缓存未命中的情况,提高内存访问效率。

-

使用共享内存 :

- 在GPU编程中,使用共享内存可以减少全局内存访问延迟,提高数据访问速度。

-

数据预取 :

- 通过数据预取技术,提前将数据加载到缓存中,以减少内存访问延迟。

三、编译器选项与配置优化

-

选择合适的编译器选项 :

- 根据具体的应用场景和目标硬件平台,选择合适的编译器选项,如优化等级、编译目标等。

-

配置硬件资源 :

- 根据硬件资源的实际情况,如GPU型号、内存大小等,合理配置编译器的硬件资源参数,以充分发挥硬件性能。

四、模型与代码优化

-

模型剪枝与量化 :

- 对深度学习模型进行剪枝和量化处理,可以减少模型参数和计算量,从而提高推理速度。

-

代码优化 :

- 编写高效的代码,避免不必要的计算和数据传输,减少代码冗余和复杂度。

五、性能分析与调优

-

使用性能分析工具 :

- 利用Triton编译器提供的性能分析工具,对代码进行性能分析,找出性能瓶颈并进行优化。

-

持续调优 :

- 根据实际应用场景和硬件平台的变化,持续对代码和模型进行调优,以获得最佳性能。

综上所述,优化Triton编译器的性能需要从算法设计、内存访问、编译器选项与配置、模型与代码优化以及性能分析与调优等多个方面入手。通过综合运用这些优化策略,可以显著提高Triton编译器的性能,从而提升深度学习应用的推理速度和效率。