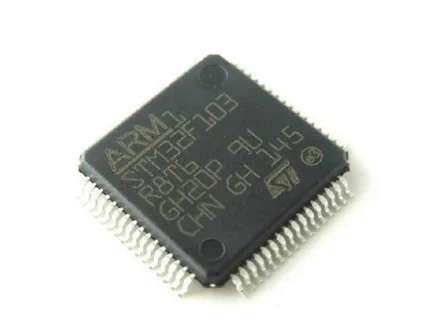

11月14日消息,据外媒报道,当地时间周一,英伟达发布了人工智能(AI)芯片HGX H200,该GPU利用Hopper架构来加速人工智能应用。

据外媒报道,H200是去年发布的H100 GPU的后续产品。H100是英伟达首款基于Hopper架构打造的GPU,此前是英伟达最强大的人工智能GPU芯片。

英伟达称,H200是首款提供HBM3e内存的GPU。得益于HBM3e, H200可提供141GB内存和每秒4.8TB的带宽,可加速生成式人工智能和大型语言模型(LLM),同时可以处理人工智能和超级计算工作负载所需的大量数据。

该公司还表示,H200的推出将带来进一步的性能飞跃,包括在Llama 2(一个具有700亿参数的LLM)上的推理速度比 H100快了近一倍。预计在未来的软件更新中,H200的性能将进一步领先和提高。

英伟达表示,全球系统制造商和云服务提供商将从2024年第二季度开始使用H200。