在AI芯片领域,英伟达一直是行业的领头羊。然而,最近一家名为Groq的初创公司却在社交媒体上引发了广泛讨论。他们宣称自己的LPU(语言处理器)在推理性能上能够超越英伟达的GPU,而且成本仅为后者的十分之一。这一消息让人们对AI芯片市场的新格局充满了期待。

那么,Groq的LPU究竟有何过人之处呢?

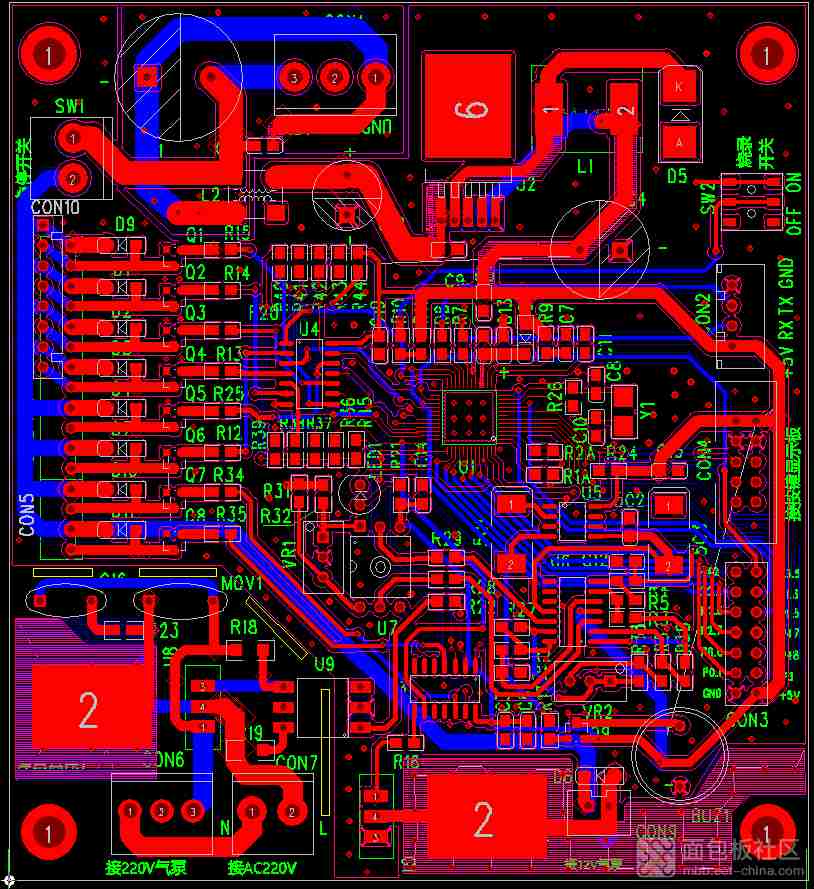

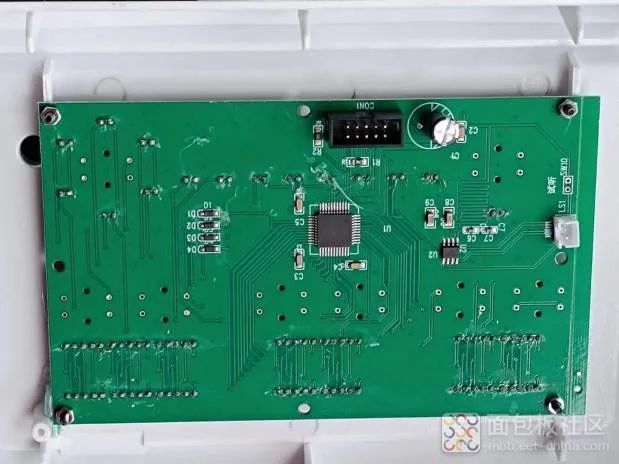

首先,让我们来了解一下LPU的技术优势。与传统的GPU和CPU相比,LPU在计算能力和内存带宽方面有着明显的优势。这意味着在处理大型语言模型时,LPU能够更快地生成文本序列,从而提高了推理性能。此外,LPU还通过消除外部内存瓶颈来进一步优化性能,这使得它在大模型推理方面更具竞争力。

除了技术优势外,Groq还采用了一种独特的TSP(张量流处理)架构来加速人工智能工作负载。这种架构类似于工厂的流水线,通过预先定义好的功能片来选择性地处理数据。这种设计使得LPU在处理复杂任务时能够保持高效和灵活。

此外,Groq在存储性能方面也有所创新。他们选择使用SRAM作为存储器,而不是传统的HBM。SRAM具有高带宽和低延迟的特点,这使得LPU在处理大模型时能够保持高速运行。同时,这也省去了使用HBM所需的封装技术,从而降低了成本。

然而,尽管Groq的LPU在技术上表现出色,但要真正挑战英伟达的市场地位并不容易。首先,在成本问题上,虽然Groq声称LPU的价格和耗电量仅为GPU的十分之一,但实际情况可能并非如此简单。一些专家认为,在考虑到大规模部署和运营成本时,LPU的成本优势可能并不明显。

其次,LPU的适用范围也是一个未知数。随着生成式人工智能的发展,大模型的复杂度和规模都在不断增加。LPU虽然能够实现对Token的快速处理,但面对更复杂的计算单元(如Patch)时,其性能如何还有待验证。此外,由于LPU专注于推理而非训练和生成阶段,因此其应用场景可能相对有限。

最后,英伟达作为AI芯片市场的领头羊,拥有强大的技术积累和开发者生态。他们正在通过不断升级GPU的性能和功能来巩固自己的市场地位。在这种情况下,Groq要想成功挑战英伟达并不容易。

总之,Groq的LPU虽然在技术上给人留下了深刻印象,但要真正颠覆市场格局还需要克服诸多挑战。不过,随着AI技术的不断发展和创新,我们期待看到更多像Groq这样的初创公司涌现出来,为市场带来新的活力和竞争。