编者按:一直以来,王闻宇都是一位对前沿科技有着敏锐嗅觉的技术人。AIGC的爆发和Apple Vision Pro的出现让他产生了新的灵感,并对未来的音视频技术有了不一样的思考。这次,LiveVideoStack对话PPIO创始人王闻宇,分享他对AIGC和元宇宙的独特见解,以及他会在LiveVideoStackCon上海站分享的内容。

LiveVideoStack:王闻宇老师您好,非常高兴您能再次来到LiveVideoStackCon,您已经是我们LVS的老朋友了。能聊聊上次北京站带给您的收获吗?

王闻宇:关于上次大会我的感受有几个:疫情结束了,这次人非常多,感受到了音视频行业的红火,也能和很多朋友见面,很开心;新应用场景多了,元宇宙,云渲染,云游戏类的Topic多了一些;更加面向未来了,更加有趣了。 LiveVideoStack:我们注意到您是一位非常善于观察,并且对新技术有敏锐嗅觉的技术人。您最近最关注的技术问题或技术趋势是什么?

王闻宇:从技术发展的角度来看,科技变化的要素通常是决定技术发展方向的关键因素。站在2023年的视角,我们可以看到两个核心的技术变化要素:AIGC和苹果MR设备的发布。 在AIGC方面,LLM大模型为机器赋予了智能,而StableDiffusion则能够高效生成图片和简单动画。这些技术的应用前景非常广阔。 另一方面,苹果的MR设备Apple Vision Pro定义了混合现实的概念,打破了VR/AR产品的定义。通过超高清摄像头,MR设备可以通过仅有12ms的延迟原封不动地展示现实画面,并叠加想要显示的任何元素。这将会开启元宇宙的全新篇章。

LiveVideoStack:您本次演讲的主题为《AIGC音视频工具分析和未来创新机会思考》,为什么这次将重点放在了AIGC工具上?

王闻宇:因为AIGC的发展太惊艳了, 实在忍不住想讲,而且我预感AIGC能成为音视频的核心技术之一。它可以通过对音视频数据的分析和处理,实现更加智能化、高效化的功能,从而提升用户体验和生产效率。另外我们作为一个提供算力基础设施的公司,AIGC领域也是PPIO边缘云算法的发展方向之一。同时,PPIO边缘云也在积极探索AIGC技术在音视频领域的应用,希望能够为用户提供更加智能化、高效化的音视频服务。

LiveVideoStack:您认为大语言模型的出现和AIGC技术的发展为音视频带来了哪些最直观的变化?

王闻宇:从直观来看,可能带来了这些变化: ①LLM大语言模型的发展,为机器赋予了智慧,这直接促进了数字人/虚拟人领域的十倍变化要素。或许在不久的将来,我们将会看到虚拟人直播的兴起,商家也不再需要辛苦地进行直播了,用户看到的都是名主播,或者二次元的形象。 ②此外,LLM大语言模型的发展也可能会诞生像游戏《光环》中的数字智能助理Cortana一样的真人形象智慧数字助理。如果结合元宇宙头显,可能还是“全息”的。 ③StableDiffusion技术的发展,将会显著降低内容创作的门槛和提高效率。StableDiffusion Amination技术也能够制作一些非常简单的动画,这将为游戏、电商和短视频等领域的创作提供更高效率,和更多可能性。

LiveVideoStack:我们注意到,您对Apple Vision Pro的发布非常重视,您认为苹果头显会成为您口中的“超级设备”吗?它又会为元宇宙、云计算和边缘计算带来哪些影响,PPIO在这方面的动作又是什么? 王闻宇:首先,我认为苹果Apple Vision Pro是个非常伟大的产品,它引领人类从移动计算时代走向空间计算时代。无缝地将数字内容与您的物理空间融为一体,通过超高清摄像头把现实画面通过12ms的延迟原封不动地展示给人眼,还能叠加想显示的任何东西,创造出一种新的交互环境。还有Apple Vision Pro可以简单地通过使用您的眼睛、手和声音来进行操作,不再需要手柄了。

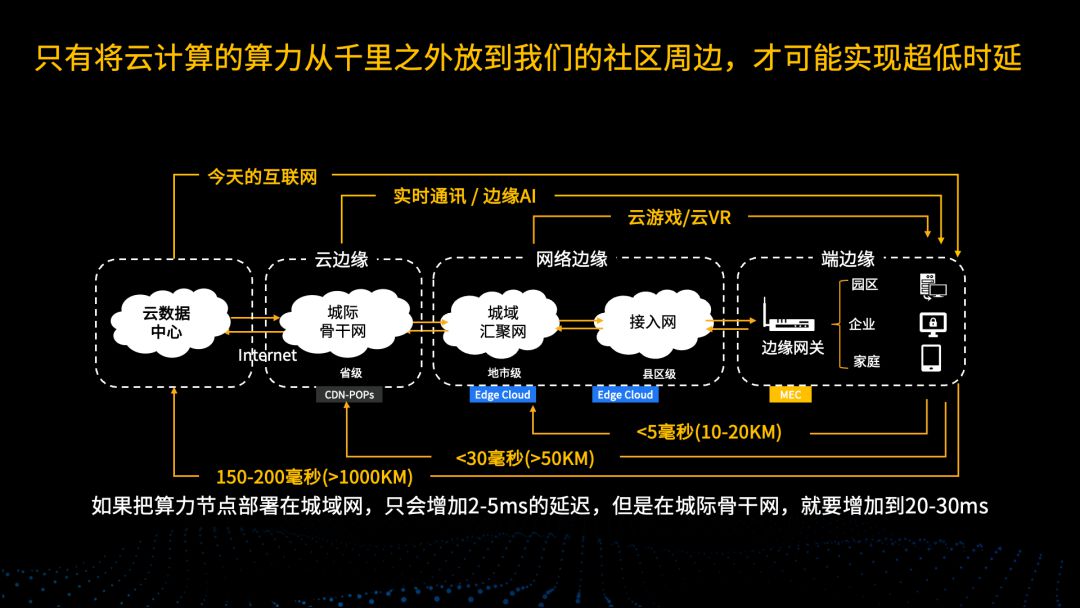

但它是不是“超级设备”呢?还要看上市后市场的反应,目前25000元的价格估计会吓退不少人,但我相信随着技术和供应链的成熟,价格会逐步下来。Apple Vision Pro的MR设备定位,使得其不仅仅用于游戏场景,它能被用于工作和生活的方方面面,更像元宇宙时代的“手机”。我相信当设备的价格在合适的时候,一定能成为“超级设备”。 我对元宇宙的未来技术思考比较多,我的推演是:元宇宙的终极发展方向是单眼8K+的分辨率,以及20ms以下的M2P延迟。这次苹果已经做到了单眼4K的分辨率,另外R1芯片的摄像头画面处理,也做到12ms,低于20ms的M2P延迟;我认为这次Apple Vision Pro距离元宇宙的终极体验,迈进了一大步。 虽然Apple Vision Pro用了MacBook的M1芯片来做计划,但要实现极致的高清渲染,我看来还是需要显算分离,具体推演可以看我的文章分析:,在显算分离的架构下,要做到20ms以下的M2P延迟,边缘云也是必须的。

我们PPIO边缘云正通过汇聚边缘算力资源,提供超低时延和低成本的计算服务。我们要和中心云形成良好的协同,边缘云并非中心云的替代品,而是起到补足的作用,从而更好地解决客户需求。

LiveVideoStack:目前,AIGC和音视频的连接是否还存在一些技术上的障碍,如有,又是哪些呢?

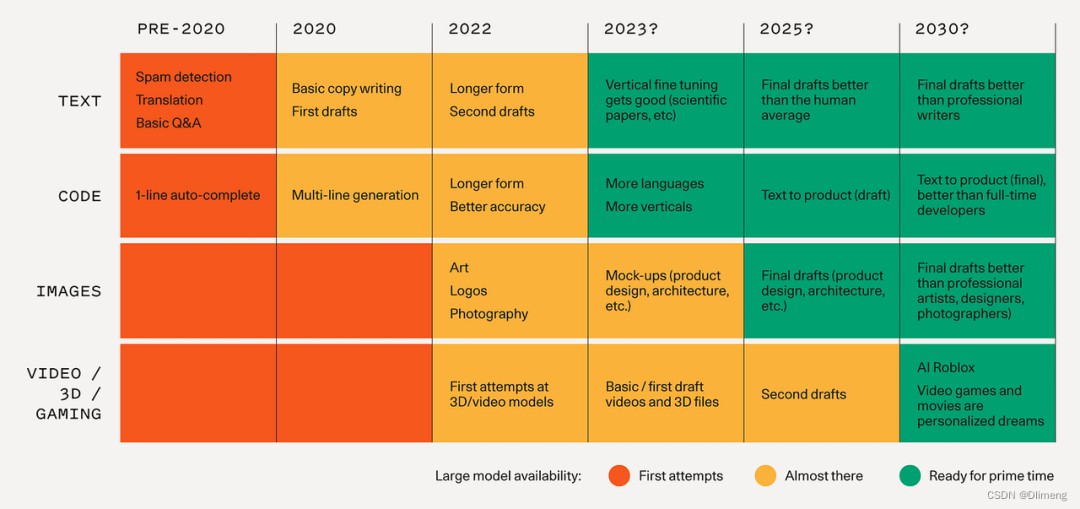

王闻宇:我认为目前AIGC在文字和图片领域的应用已经取得了很大的成功,但在音视频领域的应用还比较有限。这并不是因为AIGC技术本身存在障碍,而是因为AIGC技术的成熟度还不够,使用场景还比较受限。 但我相信,随着AIGC技术的不断发展,这些问题都可以得到解决。我们可以想象第一代视频编解码技术刚出现时的情况,它们也面临着各种挑战和困难。但随着技术的不断进步,视频编解码技术已经得到了极大的改善和完善,为我们带来了更加优秀的视听体验。同样地,我相信AIGC技术也将会在音视频领域中发挥出更加重要和广泛的作用。

图为红衫的AIGC预测表格,Video、3D的Ready for prime time还需要到2030年左右,LiveVideoStack:感谢王闻宇老师的回答。最后,您会给大家带来哪些精彩内容?您又期待在大会上听到哪些内容?

王闻宇:之前提到为什么会讲AIGC,因为它实在太新奇了,让我忍不住想分享。所以这次我将主要分享一些音视频相关的AIGC应用,并思考AIGC与音视频之间的本质联系,以及从音视频行业的角度看,AIGC将带来哪些创新的机会。希望能够为大家带来一些有价值的内容和见解。

推荐

-

VCSEL芯片和光学解决方案提供商瑞识科技完成近亿元B1轮融资

VCSEL芯片和光学解决方案提供商瑞识科技完成近亿元B1轮融资

2023-07-03

-

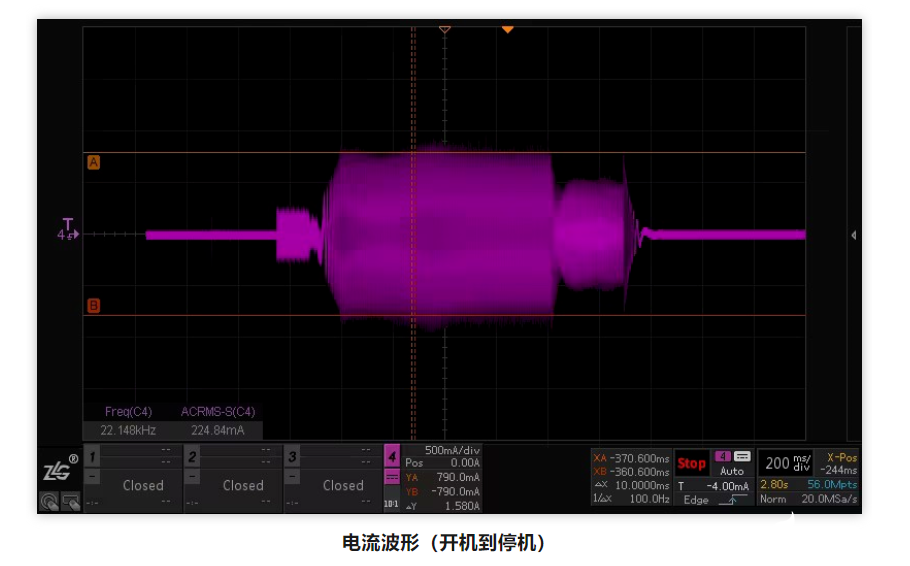

一文带你搞懂开关电源电路

一文带你搞懂开关电源电路

2024-11-02

-

基于脱硝系统改造的自动化优化分析

基于脱硝系统改造的自动化优化分析

2025-02-20

-

阿诗特能源L1000液冷新品震撼上市,卓越性能,引领未来!

阿诗特能源L1000液冷新品震撼上市,卓越性能,引领未来!

2024-06-15

-

博世与芯驰科技全面深化战略合作 围绕车用半导体核心技术

博世与芯驰科技全面深化战略合作 围绕车用半导体核心技术

2025-04-10

-

PLL锁相环:工作原理简述,高效同步控制的核心技术。

PLL锁相环:工作原理简述,高效同步控制的核心技术。

2024-04-07

-

中科曙光助力北京航天总医院打造24小时在线的AI医疗助手

中科曙光助力北京航天总医院打造24小时在线的AI医疗助手

2025-04-10

-

国产替代奋进高端,创新引领,开启替代新篇章。

国产替代奋进高端,创新引领,开启替代新篇章。

2024-04-07

-

模拟芯片与数字芯片各有独特优势,各具魅力,吸引你的目光。

模拟芯片与数字芯片各有独特优势,各具魅力,吸引你的目光。

2024-03-06

-

本征半导体,基础材料之选,了解它,掌握电子世界的关键!

本征半导体,基础材料之选,了解它,掌握电子世界的关键!

2024-04-07

最近更新

-

基于SiWG917Y的无电池Wi 6传感器

基于SiWG917Y的无电池Wi 6传感器

2025-04-19

-

NVIDIA推出AI医疗健康机器人开发平台

NVIDIA推出AI医疗健康机器人开发平台

2025-04-19

-

施耐德电气发布数据中心高密度AI集群部署解决方案

施耐德电气发布数据中心高密度AI集群部署解决方案

2025-04-19

-

航裕电源亮相2025慕尼黑上海电子展

航裕电源亮相2025慕尼黑上海电子展

2025-04-19

-

RECOM RACPRO1系列荣获2025年红点产品设计奖

RECOM RACPRO1系列荣获2025年红点产品设计奖

2025-04-19

-

广汽昊铂首家直营交付中心开业

广汽昊铂首家直营交付中心开业

2025-04-19

-

季丰成都实验室开启芯片微加工新篇章

季丰成都实验室开启芯片微加工新篇章

2025-04-19

-

航裕电源亮相2025俄罗斯国际电子元器件展

航裕电源亮相2025俄罗斯国际电子元器件展

2025-04-19

-

施耐德电气新型电力系统创新中心正式启用

施耐德电气新型电力系统创新中心正式启用

2025-04-19

-

格陆博科技2025上海车展亮点前瞻

格陆博科技2025上海车展亮点前瞻

2025-04-19