自从OpenAI 发布ChatGPT后,生成式 AI 造成市场大热,引发各家科技大厂竞相投入。现阶段提供算力的主要来源,以英伟达提供的AI加速器为大宗,但同时造成其AI加速器在市场上的供不应求,就连OpenAI也因为不想再被紧缺的供应链牵制,而打算自行开发芯片。

多家科技大厂决心自研 AI 加速器以满足需求之外,另一方面,受中美科技战限制,虽然英伟达提供中国客户减规版产品,但近期又有消息,减规版产品不受中国客户青睐,中国厂商转向华为求助,或自研芯片,不落人后继续发展大型语言模型。

这波AI浪潮发展下,英伟达无疑是AI算力领先者,A100/H100系列芯片拿下全球AI市场顶尖客户订单,研究公司Gartner和Moor Insights&Strategy表示,英伟达的全球人工智能芯片市占率最高可能达90%创新高,但英伟达寡占市场使客户须有成本高涨认知,还要面对可能抢不到货,或购买数量太少不知道何时能到货的压力。

华尔街投资银行Bernstein Research资深分析师Stacy Rasgon分析,ChatGPT每次查询的成本约为0.04美元,如果ChatGPT查询量增长至Google搜寻规模的十分之一,最初需要部署价值约481亿美元的GPU进行运算,每年还需要价值约160亿美元的芯片才能维持运作。还有相当于 160 亿美元的相关芯片来执行工作。所以,无论是为了减少成本,还是降低对英伟达的过度依赖、甚至是进一步提高议价能力,全球科技大厂都已开始其自研AI加速器的计划。

根据科技媒体 The Information 引述知情人士的说法报导指出,全球科技大厂包括微软、OpenAI、特斯拉、Google、亚马逊、Meta 等六家科技公司,都正投入研发自家 AI 加速器芯片,预计将会与英伟达的旗舰级 H100 AI 加速器芯片竞争。

全球大厂自研芯片进度

微软自研AI芯片传闻未曾停过

一年一度 Microsoft Ignite 2023 大会,终于发布数据中心 AI 芯片 Azure Maia 100 和云计算处理器 Azure Cobalt 100。微软 2019 年后就传出开发 AI 专用芯片,为大型语言模型提供动力。大会推出的 Azure Maia 100 是 AI 加速器芯片,能用于 OpenAI 模型、ChatGPT、Bing、GitHub Copilot 等 AI 工作执行。

微软介绍,Azure Maia 100 是系列第一代产品,5 纳米制程生产。Azure Cobalt 为Arm 架构的云端运算处理器,配备128 个运算核心,与目前几代Azure Arm 芯片相比,效能提升40%,支持 Microsoft Teams、Azure SQL 等服务。

两款芯片均由台积电生产,微软已在设计第二代。 有分析师表示,以ChatGPT每天运营成本约70万美元,且大部分算力源于昂贵服务器计算,Azure Maia 100与英伟达产品有同等竞争力,每芯片成本可降低三分之一。

Open AI 也正在探索制造自研 AI 加速器芯片,并已开始评估潜在的收购目标。

先前路透社引述知情人士的消息指出,至少从2022年开始,OpenAI就已讨论各种方案,以解决AI芯片短缺问题。尽管OpenAI尚未做最终决定,但希望解决AI芯片短缺的选项包括打造自家AI芯片、与英伟达等芯片制造商合作研发,OpenAI并未正式评论。

电动车大厂特斯拉也是积极投入AI 加速器芯片的科技大厂。

特斯拉以自动驾驶需求为主,至今推出两种AI芯片,分别是全自动驾驶的FSD芯片和Dojo D1芯片。FSD 芯片用于特斯拉车自动驾驶系统,Dojo D1 芯片用于特斯拉超级计算机,为通用 CPU,构建 AI 训练芯片,为 Dojo 系统提供驱动力。

Google 也早在 2013 年就秘密研发专注 AI 机器学习算法芯片,并用于云计算数据中心,取代英伟达 GPU。

这款TPU自研芯片2016年公开,为深度学习模型执行大规模矩阵运算,如自然语言处理、计算机视觉和推荐系统模型。Google 其实 2020 年资料中心便建构 AI 芯片 TPU v4,直到 2023 年 4 月才首次公开细节。

亚马逊旗下云端运算服务提供商AWS,从2013年推出首颗Nitro1芯片至今,为最先自研芯片的云端厂商,拥有网路芯片、服务器芯片、人工智能机器学习自研芯片三条产品线。

AWS 自研 AI 芯片版图包括推理芯片 Inferentia 和训练芯片 Trainium。

另一方面,AWS 专为人工智能打造的Inferentia 22023年初发布,计算性能提高三倍,加速器总内存提高25%,可透过芯片直接超高速连接支持分布式推理,最多支持1,750亿个参数,为AI芯片市场最强自研厂商。

Meta则到2022年仍使用CPU和专为加速AI算法设计的定制芯片组合执行AI工作,但因CPU的AI工作效率不如GPU,Meta取消2022年大规模定制芯片计划,转而订购数十亿美元的英伟达GPU。

就在其他各家大厂纷纷投入自研AI加速器芯片,Meta也发布了自研芯片,并2023年5月19日公布AI训练与推理芯片。芯片功耗仅25瓦,为英伟达相同产品功耗的0.05%,并采RISC-V开源架构。市场消息指出,芯片为台积电7纳米生产。

中国大厂的自研芯片之路,又是另一种光景。

美国去年10月扩大禁止向中国出售先进人工智能芯片,英伟达虽然迅速为中国市场量身订造新芯片,以符合美国出口规定。但近日有消息指出,阿里巴巴、腾讯等中国云计算大客户,并不热中买功能降低的减规版H20芯片,转成国内采购,如向华为买。策略转变显示透过部分先进半导体订单转给中国公司,将更依赖中国本土厂商芯片。

TrendForce表示,中国云端业者约八成高阶AI芯片购自英伟达,五年内可能降至50%~60%。若美国继续加强芯片管制,可能对英伟达中国地区销售造成额外压力。

推荐

-

VCSEL芯片和光学解决方案提供商瑞识科技完成近亿元B1轮融资

VCSEL芯片和光学解决方案提供商瑞识科技完成近亿元B1轮融资

2023-07-03

-

一文带你搞懂开关电源电路

一文带你搞懂开关电源电路

2024-11-02

-

基于脱硝系统改造的自动化优化分析

基于脱硝系统改造的自动化优化分析

2025-02-20

-

阿诗特能源L1000液冷新品震撼上市,卓越性能,引领未来!

阿诗特能源L1000液冷新品震撼上市,卓越性能,引领未来!

2024-06-15

-

博世与芯驰科技全面深化战略合作 围绕车用半导体核心技术

博世与芯驰科技全面深化战略合作 围绕车用半导体核心技术

2025-04-10

-

PLL锁相环:工作原理简述,高效同步控制的核心技术。

PLL锁相环:工作原理简述,高效同步控制的核心技术。

2024-04-07

-

中科曙光助力北京航天总医院打造24小时在线的AI医疗助手

中科曙光助力北京航天总医院打造24小时在线的AI医疗助手

2025-04-10

-

国产替代奋进高端,创新引领,开启替代新篇章。

国产替代奋进高端,创新引领,开启替代新篇章。

2024-04-07

-

模拟芯片与数字芯片各有独特优势,各具魅力,吸引你的目光。

模拟芯片与数字芯片各有独特优势,各具魅力,吸引你的目光。

2024-03-06

-

本征半导体,基础材料之选,了解它,掌握电子世界的关键!

本征半导体,基础材料之选,了解它,掌握电子世界的关键!

2024-04-07

最近更新

-

如何看待人形机器人接下来的机会与风险?

如何看待人形机器人接下来的机会与风险?

2025-04-21

-

图像传感器如何 “带货” 机器人赛道?

图像传感器如何 “带货” 机器人赛道?

2025-04-21

-

关于微弱传感器信号(mV 级别)的有效信号采集及干扰控制措施

关于微弱传感器信号(mV 级别)的有效信号采集及干扰控制措施

2025-04-21

-

低压动态无功补偿电容柜怎样配置?

低压动态无功补偿电容柜怎样配置?

2025-04-21

-

频率变化时电源板上的变压器会发出响声是什么原因?

频率变化时电源板上的变压器会发出响声是什么原因?

2025-04-21

-

MOS 场效应管被静电击穿的原因分析

MOS 场效应管被静电击穿的原因分析

2025-04-21

-

打造多场景飞行器 “梦之队”,翱翔新空域

打造多场景飞行器 “梦之队”,翱翔新空域

2025-04-21

-

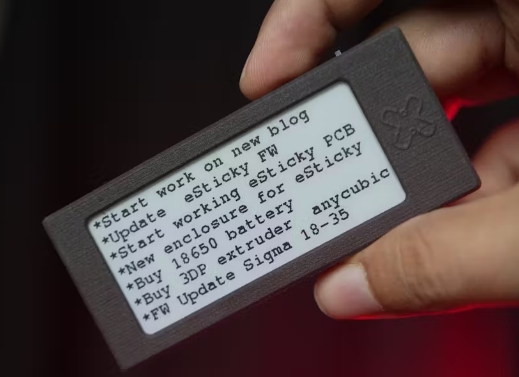

基于Seeed Studio XIAO ESP32C3,设计电子纸显示器

基于Seeed Studio XIAO ESP32C3,设计电子纸显示器

2025-04-21

-

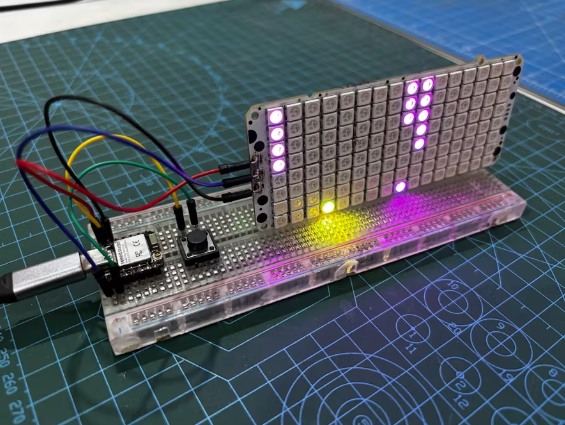

基于XIAO ESP32 C6,以16x8矩阵作为显示器设计一个小游戏

基于XIAO ESP32 C6,以16x8矩阵作为显示器设计一个小游戏

2025-04-21

-

工业信号调节器硬件设计,信号调理电路、ADCDAC与隔离模块的集成

工业信号调节器硬件设计,信号调理电路、ADCDAC与隔离模块的集成

2025-04-21