集群资源以提高性能并非新鲜事。在集群技术的早期,Beowulf 项目就证明了商品硬件也可以实现高性能。如今,每当部署某种新技术时就会使用"Beowulf集群备忘录"。例如,“想象一个由Frontier系统组成的Beowulf集群。”有趣的是,GigalO和TensorWave最近的声明更接近现实。

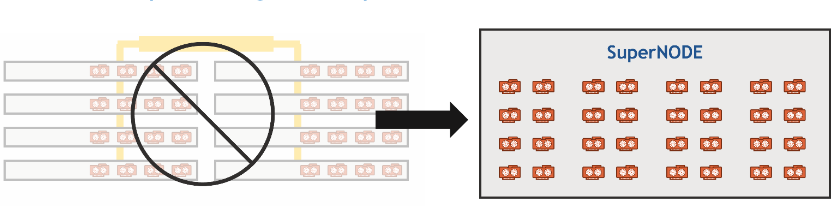

GigaIO 于今年 6 月推出了首款 32 GPU 单节点超级计算机 SuperNODE。SuperNode 在11月丹佛举行的 2023 年超级计算大会上赢得了两项令人垂涎的 HPCwire 编辑选择奖:最佳人工智能产品或技术奖和五大值得关注的新产品或技术奖。HPCwire 曾报道过 32 GPU GigaiO superNODE 和 64 GPU SuperDuperNODE 的性能。现在,GigaIO 和 TensorWave 似乎已经将“想象一个由这些 GPU 组成的Beowulf集群”铭记于心。

近日,GigaIO 宣布其旗舰产品 SuperNODE 获得了迄今为止最重要的订单,该产品最终将使用数万台 AMD Instinct MI300X 加速器,这些加速器也在AMD “Advanced AI” 活动上发布。GigaIO的新型基础设施将成为名为 “TensorNODE”的裸机专用人工智能云代码的骨干,该云将由云提供商TensorWave构建,用于访问AMD数据中心GPU,特别是用于大语言模型。

正如GigaIO全球销售首席技术官Matt Demas在接受采访时所说:"我们利用我们的SuperNODE为TensorWave创建了一个大型集群。“每个 SuperNODE 都有两台额外的服务器,并可以访问整个 TensorNODE 的所有 GPU 内存。每个 TensorNODE 上还有大量可用的暂存磁盘。

TensorNODE 部署将以 GigaIO SuperNODE 架构为基础,规模更大,利用 GigaIO 的 PCIe Gen-5 内存结构,提供比传统网络更简单的工作负载设置和部署,并减少相关的性能消耗。

TensorWave 将利用 GigaIO 的 FabreX 创建首个 PB 级 GPU 内存池,而不会受到非内存中心网络的性能影响。TensorNODE 的第一批产品预计将于 2024 年初开始运行,其架构将在单个 FabreX 存储结构域上支持多达 5,760 个 GPU。由于所有 GPU 都可以访问域内所有其他 GPU 的 VRAM,因此可以实现超大模型。工作负载可以在任何节点的单个作业中访问超过 PB 的 VRAM,从而使最大型的作业也能在创纪录的时间内完成。在整个 2024 年,将部署多个 TensorNODE。

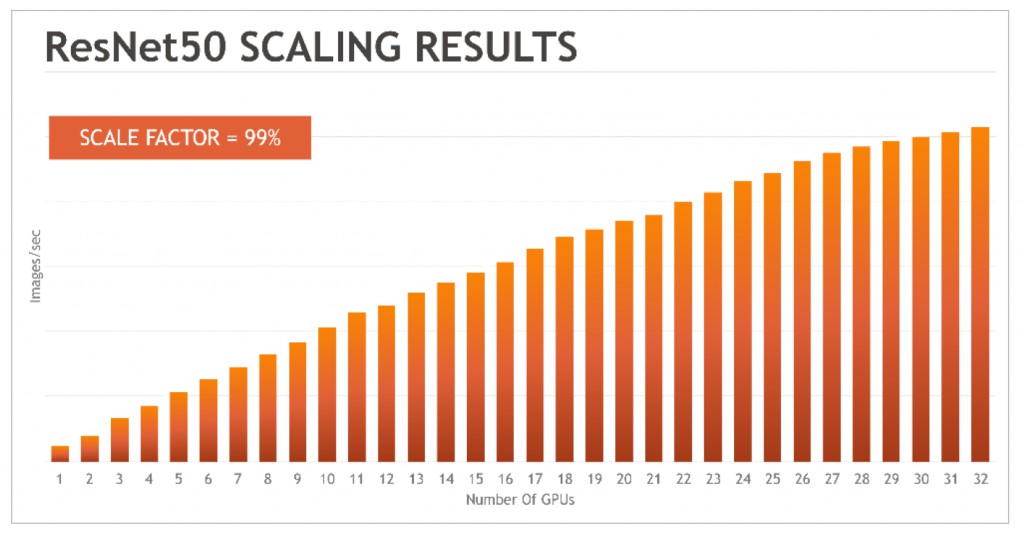

TensorNODE 是全 AMD 解决方案,采用第四代 AMD CPU 和 MI300X 加速器。MI300X 可为每个加速器提供 192GB 的 HBM3 内存,从而实现了 TensorNODE 的预期性能。这些加速器的内存容量与 GigaIO 的内存结构相结合,可在几乎不降低性能的情况下实现近乎完美的扩展,从而解决了分布式内存模型导致的 GPU 内核利用不足或闲置的难题。

TensorWave 首席执行官 Darrick Horton 表示:"TensorWave 很高兴能与 GigaIO 和 AMD 一起将这一创新解决方案推向市场。"我们之所以选择GigaIO平台,是因为它具有卓越的功能,而且GigaIO符合我们的价值观和对开放标准的承诺。我们正在利用这种新型基础设施来支持大规模人工智能工作负载,我们很荣幸能与 AMD 合作,成为首批部署 MI300X 加速器解决方案的云提供商之一。"

与标准的静态基础设施相比,GigaIO动态基础设施的可组合性为TensorWave提供了独特的灵活性和敏捷性;随着LLM和人工智能用户的需求不断发展,基础设施可以随时调整,以满足当前和未来的需求。此外,TensorWave 的云将比其他云更环保,因为它省去了 GPU 服务器主机和相关网络设备,从而节省了成本、复杂性、空间、水和电力。

"通过将革命性的 AMD Instinct MI300X 加速器与 GigaIO 的人工智能基础架构相结合,我们很高兴能够为 TensorWave 的基础架构提供大规模支持。这次部署验证了我们重新构想数据中心基础设施的开创性方法,"GigaIO 首席执行官 Alan Benjamin 说。"TensorWave 团队在云计算方面具有远见卓识,在建立和部署非常复杂的加速数据中心方面具有深厚的专业知识。

考虑到 GenAI 模型对内存的需求,GigaIO 和 AMD 提供的巨大内存大小和带宽应该会使 TensorWave TensorNode 吸引许多正在云中构建和提供人工智能解决方案的客户。

推荐

-

VCSEL芯片和光学解决方案提供商瑞识科技完成近亿元B1轮融资

VCSEL芯片和光学解决方案提供商瑞识科技完成近亿元B1轮融资

2023-07-03

-

一文带你搞懂开关电源电路

一文带你搞懂开关电源电路

2024-11-02

-

基于脱硝系统改造的自动化优化分析

基于脱硝系统改造的自动化优化分析

2025-02-20

-

阿诗特能源L1000液冷新品震撼上市,卓越性能,引领未来!

阿诗特能源L1000液冷新品震撼上市,卓越性能,引领未来!

2024-06-15

-

博世与芯驰科技全面深化战略合作 围绕车用半导体核心技术

博世与芯驰科技全面深化战略合作 围绕车用半导体核心技术

2025-04-10

-

PLL锁相环:工作原理简述,高效同步控制的核心技术。

PLL锁相环:工作原理简述,高效同步控制的核心技术。

2024-04-07

-

中科曙光助力北京航天总医院打造24小时在线的AI医疗助手

中科曙光助力北京航天总医院打造24小时在线的AI医疗助手

2025-04-10

-

国产替代奋进高端,创新引领,开启替代新篇章。

国产替代奋进高端,创新引领,开启替代新篇章。

2024-04-07

-

模拟芯片与数字芯片各有独特优势,各具魅力,吸引你的目光。

模拟芯片与数字芯片各有独特优势,各具魅力,吸引你的目光。

2024-03-06

-

本征半导体,基础材料之选,了解它,掌握电子世界的关键!

本征半导体,基础材料之选,了解它,掌握电子世界的关键!

2024-04-07

最近更新

-

H20禁令反转!国产AI芯片强势崛起,谁将成为破局王炸?

H20禁令反转!国产AI芯片强势崛起,谁将成为破局王炸?

2025-04-21

-

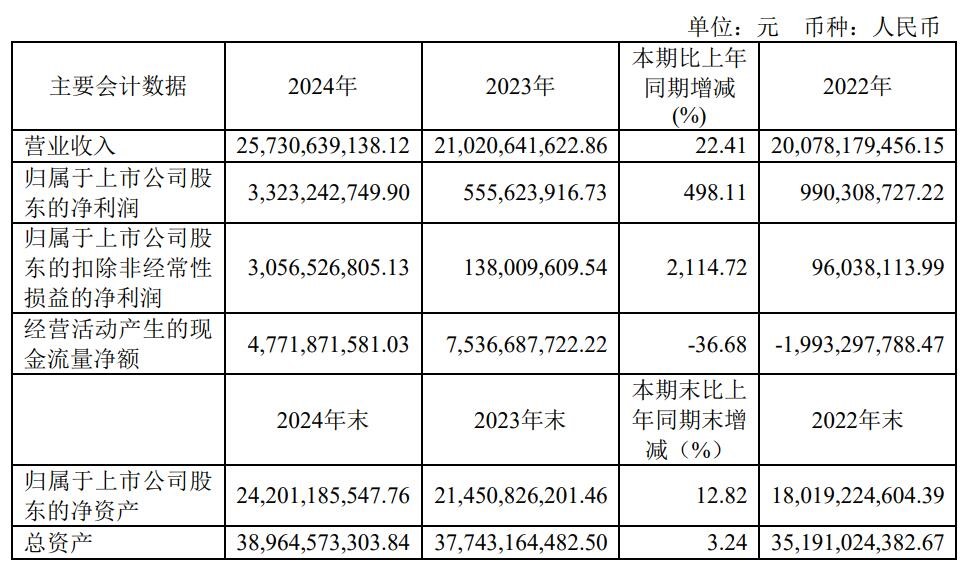

营收创新高!净利润飙涨5倍,韦尔手机和车用CIS新品成增长引擎

营收创新高!净利润飙涨5倍,韦尔手机和车用CIS新品成增长引擎

2025-04-21

-

华为新一代智能眼镜现身,加速“量产厮杀”阶段到来

华为新一代智能眼镜现身,加速“量产厮杀”阶段到来

2025-04-21

-

喜报! | 同星智能入选首届福布斯中国投资价值初创企业100系列名单

喜报! | 同星智能入选首届福布斯中国投资价值初创企业100系列名单

2025-04-21

-

携手共进,探索电子行业新机遇 | 华昕电子与深圳市企业高质量发展促进会深度交流

携手共进,探索电子行业新机遇 | 华昕电子与深圳市企业高质量发展促进会深度交流

2025-04-21

-

国产传感器新品迭出,自供电振动传感器弯道超车

国产传感器新品迭出,自供电振动传感器弯道超车

2025-04-21

-

江西萨瑞微电子参加2025慕尼黑上海电子展圆满闭幕

江西萨瑞微电子参加2025慕尼黑上海电子展圆满闭幕

2025-04-21

-

聚势赋能 同心共赢 | “新智中国行2025”数科伙伴研讨沙龙在拓维信息总部举行

聚势赋能 同心共赢 | “新智中国行2025”数科伙伴研讨沙龙在拓维信息总部举行

2025-04-21

-

德施曼2025新品发布会倒计时,以AI之名,再启技术革命

德施曼2025新品发布会倒计时,以AI之名,再启技术革命

2025-04-21

-

好消息!启明智显5G CPE全面支持全国产鼎桥MT5700和MT5710!

好消息!启明智显5G CPE全面支持全国产鼎桥MT5700和MT5710!

2025-04-21