Sam Altman@OpenAI, February 24, 2023,OpenAI的使命是确保AGI——通常来说是比人类更聪明的人工智能系统——造福全人类。

如果AGI被成功创造,此技术可提升人类能力、增加社会财富、推动全球经济增长、发现全新科学知识进而追求无限可能。

AGI有潜力为每个人提供难以置信的新能力,可以想象这样一个世界,任何人都可以在几乎任何认知任务中获得帮助,为人类的聪明才智和创造力提供巨大的能力放大器。

另一方面,AGI也会带来严重滥用、重大事故和社会混乱的风险。由于AGI的优势是如此之大,我们认为社会不可能或者不希望永远阻止它的发展,相反,社会和AGI的创造者们必须弄清楚如何把它做好。尽管我们无法准确预测未来,当前的进展也可能陷入瓶颈,但我们还是要清楚地说明我们最关心的原则>

我们希望AGI能让人类在宇宙中最大限度地繁荣。我们不期望未来变成糟糕的乌托邦,我们希望把有利因素的最大化,把不利因素的最小化,让AGI成为人性良知的放大器。

我们希望AGI的益处、使用和治理能够被广泛和公平地共享。

我们希望成功应对巨大的风险。

在面对这些风险时,我们承认,理论上看似正确的事情,在实践中往往表现得比预期的更奇怪。我们相信,我们必须不断地学习和适应,部署功能较弱的技术版本,以尽量减少追求“一次做对”的场景。

短期

为迎接AGI的到来,我们认为有几件事很重要,需要提前做好准备。

首先,随着我们不断创建更强大的系统,我们希望部署它们并获得在现实世界中操作它们的经验。我们相信这是小心管理AGI的最佳方式——逐步过渡到一个有AGI的世界总比突然发生要好。我们期待强大的人工智能使世界的进步速度更快,所以我们最好逐步适应这一点。

循序渐进的过渡让人们、政策制定者和机构有时间了解正在发生的事情,亲身体验这些系统的优劣,调整我们的经济结构,并实施监管。这使得社会和人工智能可以共同进化,并让人们一起找出他们想要的东西,从而使风险降到较低水平。

我们目前认为,成功应对AI应用挑战的最佳方式就是快速学习和小心迭代的紧密反馈循环。社会将面临重大问题,包括允许人工智能系统做什么,如何对抗偏见,如何处理大规模失业等。最佳决策将取决于技术的发展道路,像任何新领域一样,到目前为止,大多数专家的预测都是错的。这使得在真空中进行计划非常困难。

一般来说,我们认为在世界上更多地使用人工智能将带来好处,并希望推广它。我们相信,AI的平民化还将带来更多更好的研究、分散权力、带来更多福利,也会有更多的人可以贡献新的想法。

随着我们的系统越来越接近AGI,我们对模型的创建和部署变得越来越谨慎。我们的决策将需要比社会通常应用于新技术时更加谨慎,也比许多用户希望的更加谨慎。人工智能领域的一些人认为AGI及其衍生系统的风险是虚构的,如果真是这样,我们当然会很高兴,但我们还是要将这些风险视为存在。

在某一时刻,部署的利弊之间的平衡可能会发生变化,在这种情况下,我们将大幅改变围绕持续部署的计划。

其次,我们正在努力创建越来越和人类价值观对齐、可操控的模型。从第一个版本的GPT-3到InstructGPT和ChatGPT的转变就是一个这样的例子。

特别是,我们认为重要的是,就如何使用人工智能全社会能在最广阔的边界上使用达成一致,但在这些边界内,个人有很大的决定权。我们的最终希望是,世界各地的机构可以就这些广阔的边界是什么达成共识,短期内,我们计划对一些外部输入的做些实验。各地的机构都需要增加额外的能力和经验以为针对AGI的复杂决策做好准备。

我们产品的“默认配置”可能会受到很大限制,但我们计划让用户更容易改变他们使用AI的行为。我们坚持赋予人自主决策的能力,坚信思想多样性的内在力量。

随着我们的模型变得更强大,我们将开发新的对齐技术。我们的短期计划是使用人工智能来帮助人类评估更复杂模型的输出并监控复杂系统,而长期计划是使用人工智能来帮助我们提出更好的对齐技术的新想法。

重要的是,我们认为我们经常必须在人工智能安全和能力方面共同取得进展。分开讨论它们是错误的,它们在很多方面都是相关的。我们最好的安全工作来自于与我们最有能力的模型合作。也就是说,安全进程与能力进程的同时成比例提高是很重要的。

再者,我们希望就三个关键问题展开全球性对话:如何管理这些系统,如何公平分配收益,以及如何公平使用。

除了这三个方面,我们还试图构建一个架构使我们的激励与良好的结果相匹配。在我们的章程中有一项条款是帮助其他组织提高安全性,而不是在AGI开发后期彼此竞赛。我们对股东能够获得的回报规定了一个上限,这样我们就不会受到激励,不会试图在没有上限的情况为了追求高回报冒着高风险去部署一些可能导致灾难性危险的东西。我们有一个非营利组织来管理我们,让我们为人类的利益而运作,包括让我们在安全需要时取消对股东的股权义务,并赞助世界上最全面的UBI实验。

我们认为,在发布新系统之前,像我们这样的项目必须接受独立审计,这一点很重要,我们将在今年晚些时候更详细地讨论这个问题。在某种程度上,在开始训练未来系统之前进行独立审查可能是很重要的,并且对于最先进的工作来说,应该限制用于创建新模型的计算机的增长速度。我们认为关于AGI工作何时应该停止训练运行、确定发布模型是安全的,或者从生产使用中提取模型的公共标准是重要的。最后,我们认为重要的是,世界主要国家的政府应该对一定规模以上的模型训练有所掌握。

长期

我们相信人类的未来应由人类决定,与公众分享相关进展至关重要,应对所有试图建立AGI的行为进行严格审查,并对重大决策进行公众咨询。

第一个AGI仅仅是智能发展进程的一个点,它会继续进步,可能会在很长一段时间保持过去10年发展速度。如果这是真的,世界可能会变得与今天截然不同,风险可能会非常大。一个与人类相悖的超级智能可能会对世界造成严重的伤害,由超级智能领导的专制政权也会如此。

能够加速科学进展的人工智能是一个值得研究的特例,可能比其他任何事情都更有影响力。有能力加速自身进程的AGI可能会导致重大变化出人意料地快速发生。我们认为更慢的起航更易保证安全,协调所有AGI相关工作在关键节点时减速可能是非常重要的。

成功平稳过渡到一个拥有超级智能的世界也许是人类历史上最为重要、最充满希望、也是最可怕的工程。成功远不能保证,唯有希望这场豪赌将全世界人民团结起来。

我们可以想象这样一个世界,在这个世界里,人类的繁荣超乎想象。我们惟愿为世界贡献与这种繁荣相称的AGI。

脚注>

1. 基于先前的预期,我们似乎得到了很多礼物:例如,似乎创建AGI需要大量的计算,这样世界就知道谁在研究它,像超进化的RL代理相互竞争这样的原始概念,以一种我们无法真正观察到的方式进化出智能的可能性比最初看起来要小,几乎无人预测到我们会在预先训练的语言模型上取得如此大的进展,这些模型可以从人类的集体偏好和人性输出等方面学习。

AGI可能在不久的将来发生,从初始AGI到更强大的后续系统的起飞速度可能很慢或更快。我们中的许多人认为这个2乘2矩阵中最安全的象限是短时间线和缓慢的起飞速度,较短的时间线似乎更易于协调,并且由于计算力紧缺,更有可能导致起飞速度变慢,而较慢的起飞让我们有更多时间凭经验弄清楚如何解决安全问题以及如何适应。︎,2. 例如,当我们第一次启动OpenAI时,我们并没有想到扩展会像现在这样重要。当我们意识到这将是至关重要的时,我们也意识到我们原来的架构是行不通的——我们根本无法筹集到足够的资金来完成我们作为一个非营利组织的使命——所以我们提出了一个新的架构。

再举一个例子,我们现在认为我们最初对开放性的看法是错误的,并且已经从认为我们应该发布所有内容转向认为我们应该弄清楚如何安全地共享系统的访问和好处。我们仍然相信社会理解正在发生的事情的好处是巨大的,并且实现这种理解是确保所建立的东西是社会集体想要的最好方法。

推荐

-

VCSEL芯片和光学解决方案提供商瑞识科技完成近亿元B1轮融资

VCSEL芯片和光学解决方案提供商瑞识科技完成近亿元B1轮融资

2023-07-03

-

一文带你搞懂开关电源电路

一文带你搞懂开关电源电路

2024-11-02

-

基于脱硝系统改造的自动化优化分析

基于脱硝系统改造的自动化优化分析

2025-02-20

-

阿诗特能源L1000液冷新品震撼上市,卓越性能,引领未来!

阿诗特能源L1000液冷新品震撼上市,卓越性能,引领未来!

2024-06-15

-

博世与芯驰科技全面深化战略合作 围绕车用半导体核心技术

博世与芯驰科技全面深化战略合作 围绕车用半导体核心技术

2025-04-10

-

PLL锁相环:工作原理简述,高效同步控制的核心技术。

PLL锁相环:工作原理简述,高效同步控制的核心技术。

2024-04-07

-

中科曙光助力北京航天总医院打造24小时在线的AI医疗助手

中科曙光助力北京航天总医院打造24小时在线的AI医疗助手

2025-04-10

-

国产替代奋进高端,创新引领,开启替代新篇章。

国产替代奋进高端,创新引领,开启替代新篇章。

2024-04-07

-

模拟芯片与数字芯片各有独特优势,各具魅力,吸引你的目光。

模拟芯片与数字芯片各有独特优势,各具魅力,吸引你的目光。

2024-03-06

-

本征半导体,基础材料之选,了解它,掌握电子世界的关键!

本征半导体,基础材料之选,了解它,掌握电子世界的关键!

2024-04-07

最近更新

-

H20禁令反转!国产AI芯片强势崛起,谁将成为破局王炸?

H20禁令反转!国产AI芯片强势崛起,谁将成为破局王炸?

2025-04-21

-

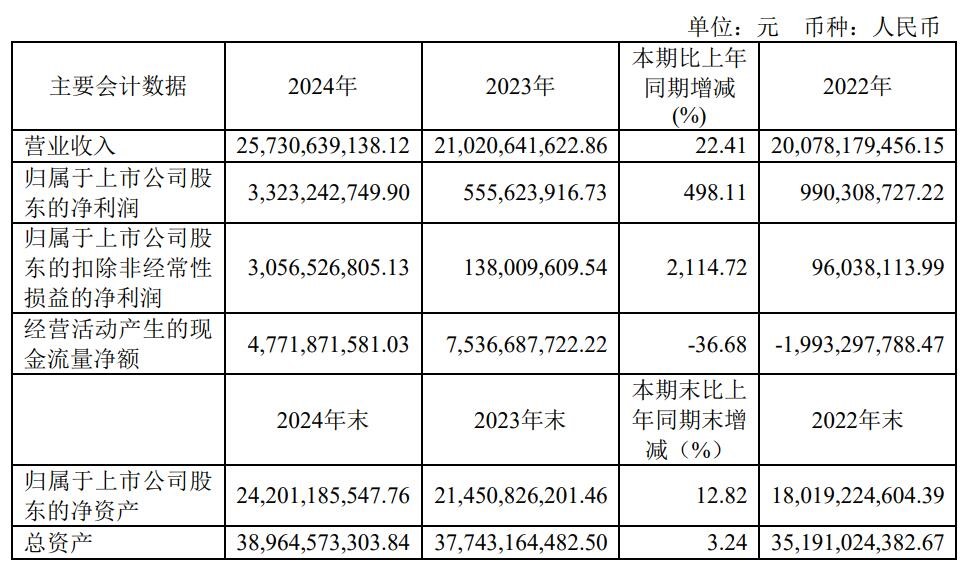

营收创新高!净利润飙涨5倍,韦尔手机和车用CIS新品成增长引擎

营收创新高!净利润飙涨5倍,韦尔手机和车用CIS新品成增长引擎

2025-04-21

-

华为新一代智能眼镜现身,加速“量产厮杀”阶段到来

华为新一代智能眼镜现身,加速“量产厮杀”阶段到来

2025-04-21

-

喜报! | 同星智能入选首届福布斯中国投资价值初创企业100系列名单

喜报! | 同星智能入选首届福布斯中国投资价值初创企业100系列名单

2025-04-21

-

携手共进,探索电子行业新机遇 | 华昕电子与深圳市企业高质量发展促进会深度交流

携手共进,探索电子行业新机遇 | 华昕电子与深圳市企业高质量发展促进会深度交流

2025-04-21

-

国产传感器新品迭出,自供电振动传感器弯道超车

国产传感器新品迭出,自供电振动传感器弯道超车

2025-04-21

-

江西萨瑞微电子参加2025慕尼黑上海电子展圆满闭幕

江西萨瑞微电子参加2025慕尼黑上海电子展圆满闭幕

2025-04-21

-

聚势赋能 同心共赢 | “新智中国行2025”数科伙伴研讨沙龙在拓维信息总部举行

聚势赋能 同心共赢 | “新智中国行2025”数科伙伴研讨沙龙在拓维信息总部举行

2025-04-21

-

德施曼2025新品发布会倒计时,以AI之名,再启技术革命

德施曼2025新品发布会倒计时,以AI之名,再启技术革命

2025-04-21

-

好消息!启明智显5G CPE全面支持全国产鼎桥MT5700和MT5710!

好消息!启明智显5G CPE全面支持全国产鼎桥MT5700和MT5710!

2025-04-21