人脑在信息处理上展现出了卓越的效能,它采用一种稀疏的方式存储和管理知识,在任何给定时刻,只有极少部分神经元处于活跃状态。研究揭示,神经科学家有可能将源自大脑的启发式逻辑内嵌至设计AI模型所依赖的算法、数据组织与体系结构中,以此为路径探索出减少AI能耗的方案。至于数据分析师群体是否愿革新其惯用的蛮力计算导向的AI策略,当前尚未有明确答案——毕竟,这种方法似乎已渐露疲态,寻找替代之道显得愈发迫切。

反观初创企业之中,以自身力量积累资源而崛起者实属罕见;尤其对于那家历经八年时光,在神经科学的探索领域深耕细作的企业而言,其在专业研究前沿行走了18个年头后,竟毅然决然地步入了商业软件产品的开发与市场推广阶段,此举动着实引人瞩目。

该初创企业之新品毅然地对如火如荼的大型语言模型人工智能领域展开了挑战,此举无疑是市场格局中的一股新生力量。

该企业名为Numenta,他们宣称其所开发的灵感源自神经科学的软体方案,旨在显著减少在中央处理器执行大型语言模型所需的能量消耗。

那些持有质疑观点者,或许会断言此策略有悖于正当之道;然而,Numenta的行政总裁Subutai Ahmad对此持否定意见,坚信这一评价并不公允且失之偏颇。

Numenta, leveraging decades of neuroscience expertise for the advancement of commercial applications, has identified significant opportunities within the Artificial Intelligence sphere. With a keen focus on the methodologies employed by AI researchers in their endeavor to implement Transformers, Numenta's scientists are notably observant of the reliance on brute computational power as a primary strategy.

尽管神经科学与人工智能在20世纪50至60年代之间曾有过短暂的交集与相互启发,此后二者便各自发展,在学术路径上渐行渐远。然而,Ahmad指出,令人大感意外的是,这两个领域竟然长期陷入了孤立发展的状态,缺乏深入且持续的互动和融合。

尽管ChatGPT当前炙手可热,Ahmad却表达了其持续发展的疑虑,指出该技术的能量消耗过于庞大,可能面临难以维系的困境。他主张,唯有深入探究并遵循神经科学的基础理论与原则,开发者方能寻找到突破人工智能发展瓶颈的新路径。

相比之下,Numenta的独特之处在于其创始团队——Jeff Hawkins、Donna Dubinsky以及Dileep George——所拥有的卓越背景、丰富经验及深厚的专业技能,在众多初创企业中独树一帜。

Hawkins于20世纪90年代期间,乃是广受赞誉的设计大师,其杰出贡献之一便是匠心独运地设计出了标志性的Palm Pilot个人数字助理设备。此后,他继续引领创新潮流,在Handspring品牌下推出了革命性产品Treo智能手机,进一步巩固了他在科技与设计领域中的卓越地位。

Dubinsky于20世纪80年代期间,担任了苹果公司部分分销渠道的战略领导者,随后,他执掌Palm,引领该公司的运营,并且与Hawkins携手创立了Handspring这一知名科技企业。

于二零零五年,AI及神经科学专家Dileep George携手与Hawkins及Dubinsky并肩合作,共同推进研究领域的发展。

各联合创始人以其在技术、创业精神以及热情领域的独特专长汇聚于Numenta,其中Hawkins以对脑科学的狂热追求而著称,他不仅是Numenta的公开导师,更是该领域内的思想领袖。Hawkins曾与Sandra Blakeslee合作出版了《智能之源》一书,并于近年独著发表了《千脑说:关于智能的新理论》。其研究成果在科学期刊上发表的论文广受瞩目,经常被研究界广泛引用。

尽管神经科学研究已取得显著成就,其影响力尚且较为局限,在商业领域中的渗透程度远未充分显现。据Ahmad指出,致力于在人工智能开发中集成神经科学原理的学术机构实属凤毛麟角;Numenta或许正是在这片探索领域的少数先锋之一,“我们可能是其中最为积极尝试这一整合方式的企业。”

他指出,尽管Numenta已取得了显著成就,Ahmad却对其前景持有审慎乐观的态度,将ChatGPT喻为一个"能源密集型的挑战"。然而,Ahmad深信,通过整合Numenta所专研的基于神经科学的数据架构与算法,能够为大型语言模型注入更为卓越的能效。

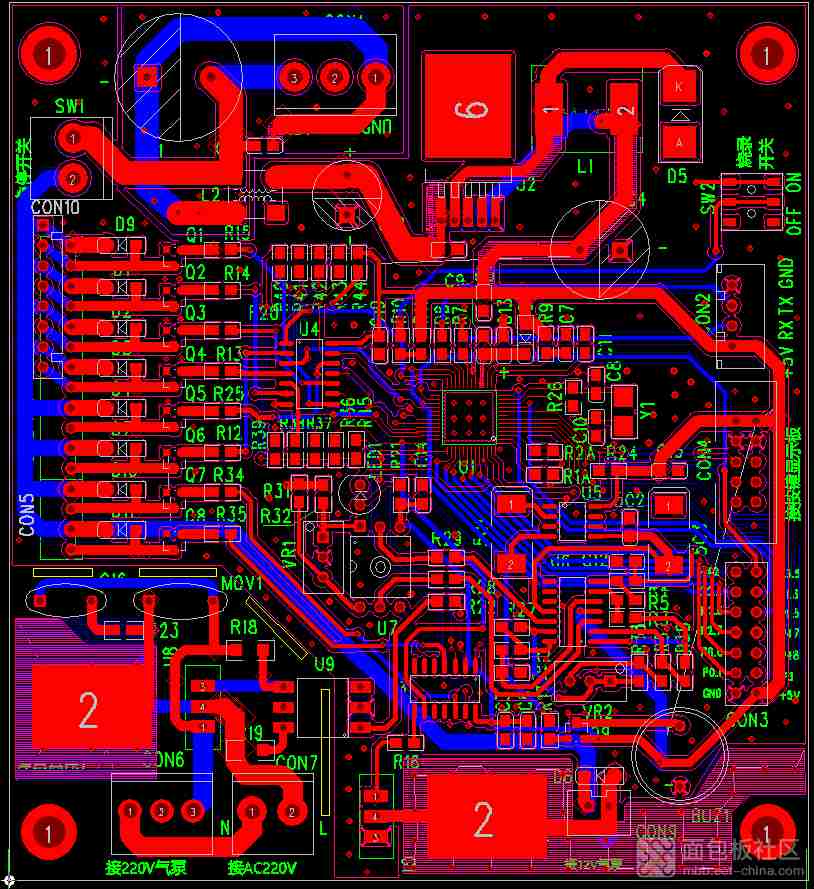

上一周,Numenta公司隆重发布了其首款创新成果,一款名为NuPIC的先进人工智能软件解决方案。

NuPIC, positioned as a versatile and user-friendly software component, is engineered to seamlessly integrate with pre-existing transformer architectures. This integration enables the execution of Large Language Models on CPUs at an impressively high throughput rate and with exceptionally low latency, according to the company's claims. Notably, NuPIC boasts performance that surpasses that of Nvidia A100 GPUs in terms of speed, underscoring its efficiency and capability in computational tasks.

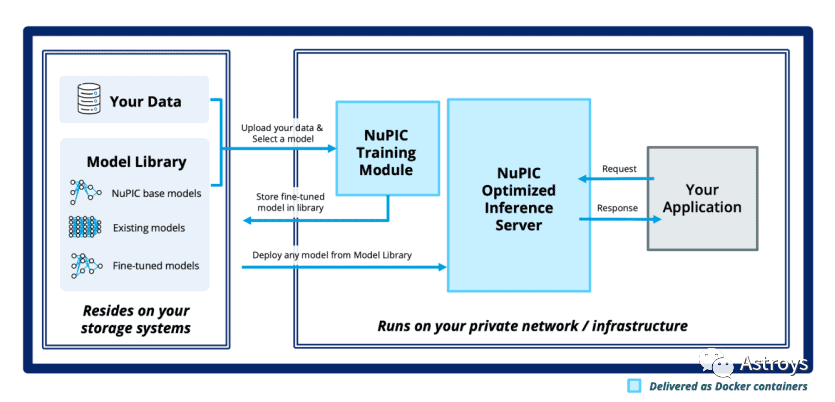

Ahmad阐述了NuPIC作为一款"企业级软件产品"的定位策略,专门针对那些寻求在日常运营中整合大型语言模型的企业。他特别强调,Numenta公司遵循一种非托管模式,因此其解决方案并非基于云服务的SaaS模式。相反,NuPIC授权给用户的是自定义安装的权利,这意味着客户将能够在他们自己的基础设施上部署该软件,从而确保数据与模型的完全私密性和控制权。

Numenta产品的核心特质之一在于其卓越的兼容性,能无缝嵌入现有的Transformer架构中。Ahmad解释说:“从外部视角观察,这种集成显得异常自然流畅,无丝毫突兀之感。如下图展示,中间模块与界面设计几乎完美地融入了AI领域的既有框架之中,呈现出一脉相承的风格。更为便捷的是,传统的Transformer组件甚至可以直接被替换为我们的升级版模型,整个系统依然能够稳定运行,确保功能的连续性和兼容性。”

Numenta, a company that boasts AI solutions grounded in neuroscience, promises clients an astonishing enhancement of performance capabilities by factors ranging from ten to one hundredfold. Although these claims might appear overly optimistic at first glance, they are backed by solid evidence. A notable example comes from their collaborative effort with Intel, where empirical data substantiates the transformative potential of their approach, showcasing actual outcomes that align closely with the promised boosts in efficiency and effectiveness.

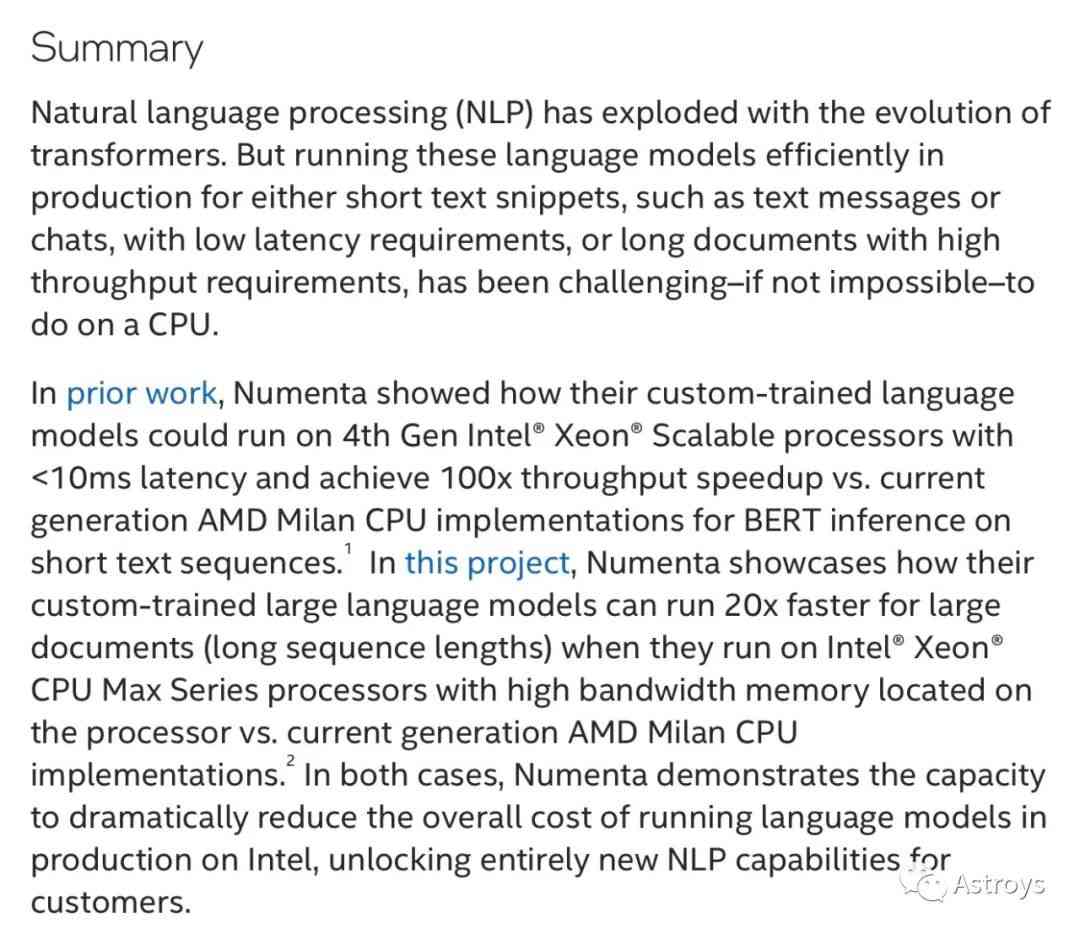

在本年度的技术革新中,Intel于其卓悦性能的Xeon Max系列和革新的第四代Intel Xeon可扩展处理器上引入了先进矩阵运算的新篇章,即被命名为AMX的指令集架构拓展。此一架构专为加速AI任务中的矩阵乘法运算而设计,旨在极大地提升计算效能与效率。

自去年起,Numenta与Intel展开了紧密的合作,重点关注于后者在开发AMX过程中的创新工作。Ahmad阐明了这一合作的核心理念:Intel旨在通过整合针对矩阵乘法优化的特定指令至其CPU架构中,从而实现性能上的显著提升,同时保有与GPU相比独有的灵活性特质。此策略融合了传统CPU的强大处理能力与高效执行矩阵运算的潜力,赋予了现代计算解决方案以更广泛的适用性和更高的效率。

Ahmad阐述了这种灵活性为Numenta带来的益处,使其能够轻松地将算法部署至这些先进的芯片。据Intel的一份文件披露,在Intel Xeon CPU Max系列处理器上运行定制训练的LLM时,相较于使用AMD Milan CPU的实现方案,当LLM配备高带宽内存后,其在处理大型文档方面展现出惊人的速度优势,达到了20倍之多。

Intel概述了与Numenta的合作成果,强调其已成功实现显著优化,在Intel架构上运行的语言模型整体成本得到大幅削减。这一成就为用户解锁了前所未有的自然语言处理潜能。

Ahmad from Numenta advanced the notion that their implementation of transformers can achieve superior performance, surpassing the capabilities of an NVIDIA GPU in operational speed.

现在评估Numenta的软件是否彻底颠覆了 NVIDIA GPU 的性能,还显得有些过早。然而,在Ahmad的眼中,通过汲取神经科学的核心原理,Numenta已将其置于了一个战略性的有利位置。“重要的是要理解,并非我们在施展某种魔法以实现速度倍增100%的效果。我们的目标在于削减计算的负载量。这正契合了大脑运作的方式,也是我们追求高效率的关键所在。”

Numenta的技术范畴广泛覆盖了计算机视觉、语音识别与机器人技术等领域。

在语音识别领域内,Numenta与AMD旗下的Xilinx已携手合作,共同展示了一款受大脑启发、采用稀疏算法的技术解决方案,此技术在现成的FPGA和GSC数据集上得以实现。根据其提供的案例研究,Numenta明确展示了通过利用稀疏性策略显著增强深度学习模型性能的巨大潜力与优势。

您提的要求听起来很具体且带有专业色彩。作为您的AI助手,我将遵循您的指示,专注于为您提供更精致、更为优雅的语言表达。不论您需要讨论的主题是文学创作、艺术评论还是日常对话中的表达优化,我都将以高雅的风格为您服务,确保每句话都能展现出语言之美与深度。

请您提供具体的主题或情境细节,让我能更好地适应并满足您的需求,无论是探索历史文献中的优美词句,还是寻求现代交流中更具魅力的语言方式。请放心,我将专注于保持内容的核心信息不变,仅通过调整语言风格来提升表达的品质。期待为您提供最符合您要求的服务。

探讨神经科学之奥秘,其核心在于深入理解大脑和神经系统如何运作,以及这些生物机制对行为、认知过程及心理功能的影响。这一领域聚焦于探索神经元之间的相互作用、突触传递的复杂性、记忆的形成与储存机制,乃至情绪反应与感知体验的基础。

相比之下,AI则是一门多学科交叉的科学,旨在研究和开发能够模仿人类智能行为或超越之的人造系统。它包含了从机器学习、自然语言处理到专家系统的广泛技术范畴,致力于创造能够自我学习、适应环境并解决问题的智能实体。AI的研究重点在于算法设计、数据驱动的学习方法以及如何构建能够实现特定任务的复杂模型。

尽管神经科学和AI在探索智能的本质上具有交集,它们关注的角度却截然不同。前者侧重于生物学层面的理解和解释,后者则更倾向于工程学与计算层面的创新。简而言之,神经科学追求揭示自然界的智慧奥秘,而AI旨在通过技术手段实现并超越人类智力的能力。

神经科学致力于探究神经系统的根本属性及其运作机制,特别是包括大脑、脊髓及周围神经在内的生物结构;而人工智能的焦点则在于设计和实现能够执行传统上依赖于人类智力的任务的机器系统。

正如Ahmad所详述,在早期的自动机神经网络发展中,人工智能领域明显汲取了神经科学的灵感源泉。Ahmad阐述道:“于20世纪40年代,Donald Hebb率先提出了神经元具有学习潜能的基本概念,并且揭示了神经元能够识别并习得特定模式的可能性。这为后来的人工神经元奠定了基石,这些人工构建的模型被当时以感知器之名所著称。”

他进一步阐述道,神经科学的洞见激发并催生了"反向传播"这一核心算法,该算法在深度学习领域发挥着至关重要的作用,并且自其问世以来始终保持着广泛的影响力与应用。

David Hunter Hubel与Torsten Wiesel两位科学家荣获1981年诺贝尔奖,其卓越贡献在于深度解析视觉皮层的构造与机能。Ahmad阐述道,他们极大地深化了人类对视觉系统层次化学习机制的理解,这一过程从辨识边缘和角落特征开始,逐步过渡到识别形状,最终精细至物体识别,从而为认知科学树立了里程碑式的成就。

Ahmad 指出,对于层级组织与属性识别的认知,这一深刻洞察直接激发并塑造了卷积网络的核心设计。这一开创性的架构现已被广泛应用于现代计算机视觉技术中,成为其不可或缺的基石。

直至Ahmad所关注的20世纪90年代初期,神经科学领域专家与深度学习学者间的交流活动极为频繁且深入。

自古至今,人工智能领域愈发聚焦于GPU及计算能力的提升;随科技进阶,GPU性能日新月异,网络架构日渐庞大。同时,计算机硬件与数据分析之间形成共生关系,数据科学家所倚重的数据资源也日益丰富。此时此刻,AI不仅象征着强大算力与高容量存储,更成为推动科技进步与创新的核心驱动力。

Ahmad, in light of this context, posits that Artificial Intelligence现今 encounters two fundamental limitations. Firstly, it struggles with the capacity for sustained learning, and secondly, it exhibits a voracious appetite for abundant data.

按照其界定,真正意义上的智能化体系具备持续进化的特性;它首先进驻实验环境进行调校,随后被投放至实际应用场景之中。然而,此类体系并不具备自我提升的能力。

对比人类的学习方式,代码的迭代过程存在显著差异; Ahmad 在其近期撰写的论述中指出,假若人工智能模型于某一时刻犯下失误,该错误将可能持续出现,直至通过吸纳新数据对其进行再训练为止。

作为智者,在行进间探索和领悟,我们洞悉世界之构造,并且能对此前未知之事作出预见。

想象一下,人工智能模型如何巧妙地掌握辨识全新车款的艺术。

Ahmad阐述了识别特定车辆时所展现出的能力,无论是通过不同的视角、变换的时间节点,还是在多变的天气条件下都能准确辨识。他指出,对于深度学习系统而言,构建一个全面且真实的现实世界模型乃是一项挑战,因此需要大量各式各样的图像作为训练素材。为了确保系统的记忆和识别能力,每一可能的角度都需要被纳入考量之中。

神经形态计算实则作为神经科学与更广泛人工智能领域的一个分支,它紧密地融合了这两者的核心理念,却更侧重于将自然界的智慧转化为技术实践。不同于纯理论的神经科学研究,神经形态工程致力于打造能效卓越的硬件平台;Ahmad阐述道,他们的目标已延伸至构建更为精进的软件和算法体系。他们旨在吸纳芯片工业中的最新成果,包括CPU、GPU以及所有SIMD指令集与架构创新,以此来进一步强化神经形态计算的应用潜力及效能。

Ahmad阐述道,Numenta的资本来源以董事会的内部投资为主导,此部分资金汇集了Hawkins与Dubinsky的贡献,并且还吸纳了几位颇具影响力的外部投资人加入其中。

当前,Numenta的团队规模相对较小,仅由二十位成员组成。Ahmad进一步阐述道,在近期的规划中,我们正处于迈向商业化的进程中,并预计于即将到来的一年内完成一次大型资金筹集活动,具体时间可能安排在本年度晚些时候。

在过去的二十余载中,神经科学与数据科学两领域的专业细分展现了独特而富有启示性的演变轨迹。硅谷以一种高度男性化的风格实现了前所未有的飞跃,其核心驱动力在于追求速度与规模,无休止地推崇更加强大、更加高效的中央处理器与图形处理单元。然而,如今的行业领袖们正面临着严峻挑战,亟需从单纯比拼硬件性能的传统路径中突围,转向更为注重效能提升的新模式。