1. 项目描述:

1.1. 问题陈述

虽然现有的技术已经显著改善了盲人的导航和障碍物检测,但它们主要集中在这些方面。我们的目标是扩展这项技术,不仅包括检测,还包括物体、人脸和图像的识别。人工智能的广泛应用旨在通过提供有关其周围环境的更详细和有意义的信息来增强视障人士的整体体验。

1.2. 建议的解决方案

我们的项目旨在利用先进的人工智能模型来增强盲人的空间意识,用于图像、物体和面部识别。与目前主要关注导航的解决方案不同,我们的方法利用人工智能来解释和传达详细的视觉信息,旨在为用户提供对周围环境更丰富、更身临其境的理解。通过解释和传达详细的视觉信息,我们的目标是为用户提供一种身临其境的体验,提高他们对世界的整体感知,解决单纯导航之外的关键需求。

2. 项目的特性

计划中的项目包括四个主要功能:图像识别、物体识别、人脸识别、文本到语音转换和GPS跟踪。

2.1.图像和对象识别:

这些是通过使用用户的视频捕捉设备分析周围环境的图像到文本转换模型实现的。该模型生成合适的标题来描述图像,在单个实现中实现图像和物体识别的双重目的。

2.2.FaceRecognition:

人脸识别功能可以识别和区分用户周围环境中的不同面孔。该功能可以识别和传递关于已知个体的信息,增强社会互动和个人意识。如果遇到任何未知的个体,则提示用户为该个体指定一个名称,并将其面部编码保存到用户目录中。

2.3.语音转换:

为了将信息传递给用户,我们使用文本到语音(TTS)模型。这将生成的文本描述和识别转换为可听的语音,利用用户的声音感知有效地传达视觉信息。

2.4. GPS跟踪:

辅助GPS可以帮助用户在街道上导航,并为用户提供方向提示。该功能支持高效准确的导航,确保用户能够安全有效地到达目的地。

3. 项目实施

该项目使用桌面视频捕获设备来实现,该设备捕获图像帧以进行图像字幕。每个模型都被单独实现,以有效地实现项目的目标。

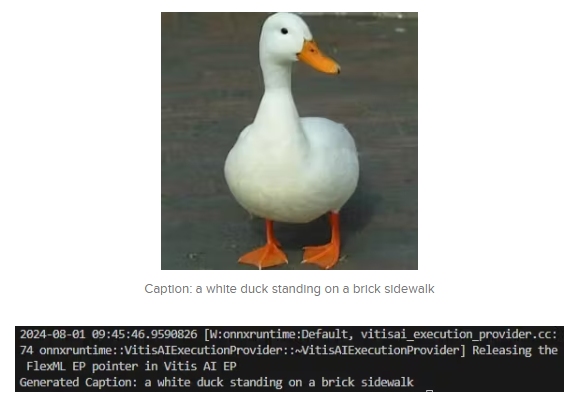

3.1.图像和物体识别模型:

采用《拥抱脸》中的nlpconnect/ vitg -gpt2-image-captioning模型对捕获的图像生成描述性的说明文字。以下是对工作流程的详细解释:

3.1.1.模型选择和功能

模型选择:选择nlpconnect/ viti -gpt2-image-captioning模型是因为它能够生成详细而准确的描述图像内容的标题。它结合了用于图像特征提取的视觉转换器(ViT)和用于生成自然语言描述的GPT-2。

3.1.2.转换为ONNX格式

ONNX格式:开放神经网络交换(ONNX)是一种人工智能模型的开源格式,这使得它们可以在不同的平台上移植和互操作。将模型转换为ONNX格式允许在支持ONNX的环境中部署,从而确保更好的兼容性和性能

转换过程:使用hug Face和ONNX提供的工具和库将模型从原始格式转换为ONNX。这一步包括将模型的体系结构和权重导出到一个标准化的ONNX文件中,然后可以使用该文件进行进一步的优化和部署。

3.1.3.预处理优化

预处理:一旦进入ONNX格式,模型就会进行预处理以优化其性能。这包括:

输入归一化:调整输入的图像数据以匹配模型的预期格式。

调整大小:确保所有输入图像都调整到适合模型的一致尺寸(例如,224x224像素)。

数据增强:应用技术来提高模型的健壮性和性能,如随机裁剪、翻转和颜色调整

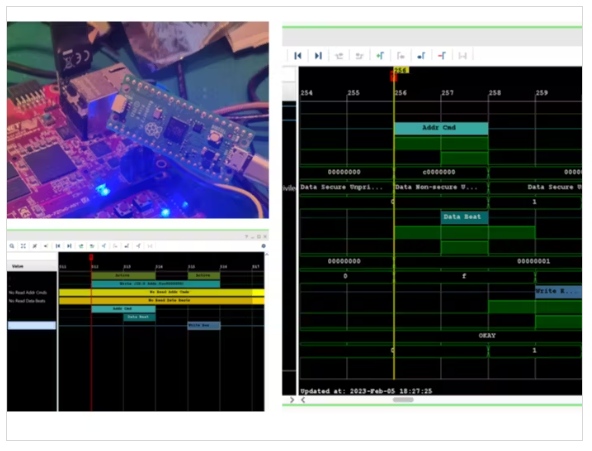

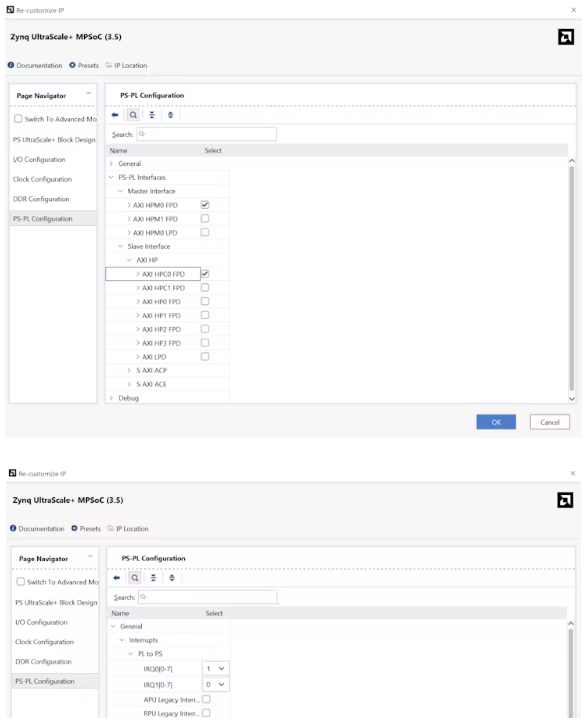

3.1.4. 使用Vitis AI量化器进行量化

量化:此过程涉及将模型的权重和激活从浮点精度(32位)转换为较低精度(例如,8位整数)。量化显著地减小了模型的尺寸,提高了推理速度,而精度却没有实质性的损失

Vitis AI Quantizer: Vitis AI Quantizer是Xilinx提供的一个工具,用于优化部署在硬件加速器上的AI模型。它支持各种量化技术,确保模型保持高效和准确。

校准数据:为了保持量化过程中的准确性,使用了合适的校准数据。该数据表示模型将处理的典型输入,确保量化模型在实际数据上表现良好。校准数据有助于微调量化参数,最大限度地减少对模型性能的影响。

通过遵循这一详细的工作流程,该项目确保了nlpconnect/ viti -gpt2图像字幕模型高效准确地运行,为视障用户提供高质量的图像和物体识别。

例子

3.2.人脸识别模型:

face_recognition Python包用于识别和区分视频帧中的人脸。系统通过名字通知用户识别出的个人,对于未知的面孔,它会提示用户分配一个名字,并存储面部编码以备将来识别。该功能增强了用户的社交互动和个人意识。

3.3.文本-语音转换模型:

使用来自hugs Face的microsoft/ speecht5_ts模型将生成的文本标题转换为可听的语音。这允许用户接收周围环境的口头描述,使信息易于访问和理解。

3.4用户交互与反馈:

该系统的设计考虑了用户交互。人脸识别模型提示用户为未知的面孔分配名字,允许个性化和不断提高识别。文本到语音的转换确保信息以一种清晰易懂的方式传递,利用用户的听觉感知。

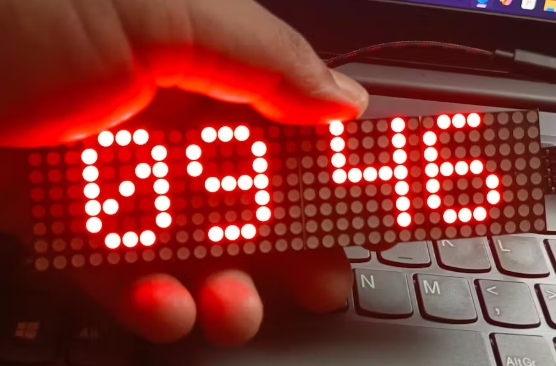

3.5.桌面视频采集设备:

桌面视频采集设备持续记录用户周围环境,提供实时图像帧进行处理。这些帧用作图像字幕模型的输入,确保用户接收到有关其环境的最新信息。

3.6. 排除GPS跟踪

由于硬件的限制,目前版本的项目没有实现GPS跟踪。这一决定是为了确保将重点放在优化图像、对象和人脸识别以及文本到语音转换的核心功能上。

通过结合这些技术,该项目提供了一个全面的解决方案,增强视障用户的空间意识,使他们能够更有效地感知环境并与之互动。

4. 结论:

通过整合先进的人工智能技术,我们的项目显著提高了视障人士的空间意识。通过结合使用图像和物体识别,人脸识别和文本到语音的转换,我们提供了一个全面的解决方案,超越了传统的导航辅助。该项目使用户能够更深入地了解周围环境,培养更大的独立性和社交互动。通过专注于改善感知和与环境的互动,我们的目标是丰富视障用户的生活,为他们提供更加身临其境和信息丰富的世界体验。

5. 未来的范围

这个项目未来的范围是巨大的,有许多改进和扩展的机会:

5.1.用户交互:

在当前的项目中,用户交互是有限的。这一限制可以通过探索用户与系统交互的更多样化的方式来解决,例如集成语音命令、触摸界面和触觉反馈。这些增强功能将提供更直观和更易于访问的用户体验,使视障用户能够更有效和更有效地使用系统

5.2.增强的空间意识

目前,空间意识主要是通过项目的图像和物体识别功能来提供的。为了进一步增强这种能力,我们计划实现一个配备振动电机的可穿戴腕带。这款手环将通过振动电机提供方向提示,以对应用户需要注意的方向,比如北方。例如,如果用户需要知道哪个方向是北,那么只有与该方向对齐的电机才会振动,从而向用户提供有关其方向的触觉反馈。

这种触觉方向感是一种简单而有效的解决方案,但它将在未来的发展中扩展到集成GPS和先进的目标检测。有了GPS,该系统将能够提供更精确的位置和方向信息,帮助用户导航和识别周围的各种地点和物体。基于图像识别和GPS定位的综合分析,这些振动将作为信息提示和警告,从而显著提高用户的空间意识和整体导航体验。

5.3. 用于视频捕捉的智能眼镜

在未来,将视频捕捉集成到智能眼镜中将是这个项目的理想选择。智能眼镜可以提供一种更加无缝和谨慎的方式来持续捕获和分析视觉信息,增强我们空间感知技术的整体有效性。这种可穿戴解决方案将为用户提供实时、免提的视频采集,使系统在日常使用中更加方便和直观。

5.4.扩展识别功能:

扩展识别功能以包含更多类别,例如地标、文本和动物,从而为用户提供更丰富的信息集。实现实时对象跟踪,提供关于用户环境中移动对象的持续更新。

5.5.与无障碍组织合作:

与支持视障人士的组织合作,以确保项目符合社区的需求和标准。参与用户测试和社区研讨会,以收集见解并验证系统的有效性。

5.5.健全的安全和隐私措施:

开发安全的方法来存储和处理个人数据,如面部编码,以确保用户隐私。实施加密和安全访问协议,以保护系统免受未经授权的访问和数据泄露。

通过追求这些未来的发展,该项目可以继续发展,为视障人士提供更大的好处,最终提高他们的独立性和生活质量。

本文编译自hackster.io