患有严重运动障碍的人——比如那些患有ALS、闭锁综合征或神经退行性疾病的人——由于自主运动和语言的限制,经常难以沟通。虽然像眼球追踪、肌肉触发开关和语音设备这样的辅助技术已经存在,但它们往往速度缓慢、不灵活,而且缺乏上下文意识。

脑机接口(bci),如P300拼写器,提供了一种非侵入性的替代方案,但它们仍然面临着低吞吐量和有限的适应性等挑战。除了基本的信号检测之外,大多数都没有考虑到用户的环境或意图。

显然,我们需要一个更智能、更集成的系统——一个能够解释多种输入信号(如脑电图、眼球运动或肌肉活动)并实时生成上下文感知、有意义的文本的系统。随着大型语言模型(llm)的最新进展,我们现在有了弥补这一差距的工具。

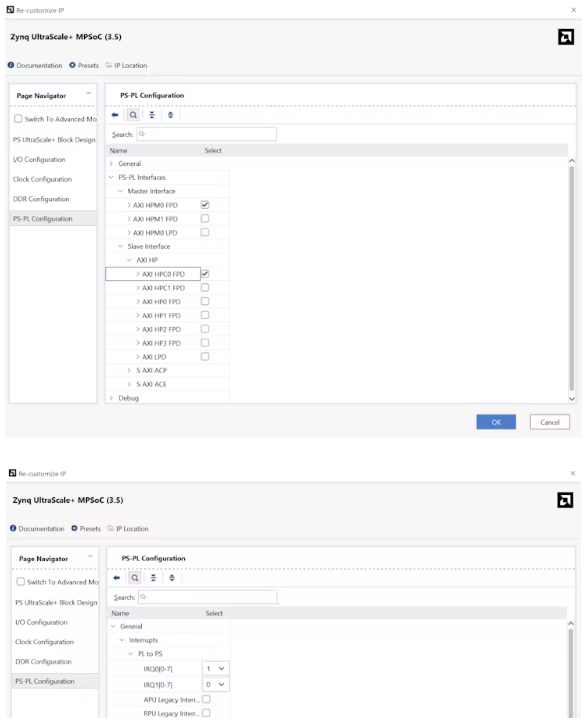

该项目探索非侵入性脑电图信号如何与上下文数据和llm相结合,为更具适应性和智能的通信接口提供动力。

用脑电图仪读取脑电波

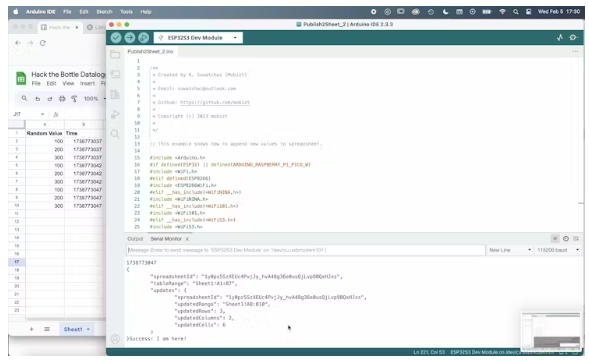

我有一个《星球大战Force Trainer II》的脑电图耳机,但任何与Neurosky ThinkGear兼容的脑电图耳机都可以工作。

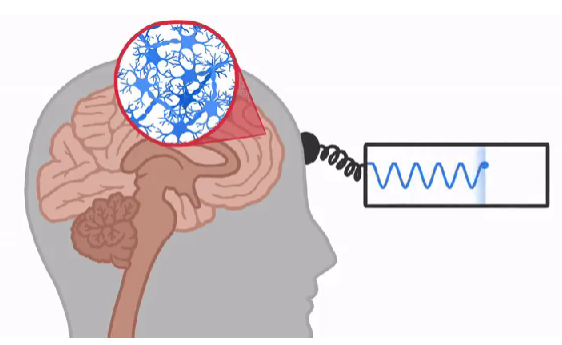

这款耳机有三个电极,一个在你的额头上,两个在你的耳朵后面。

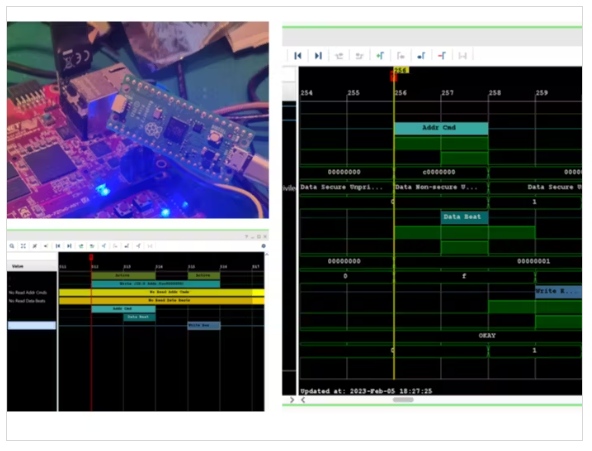

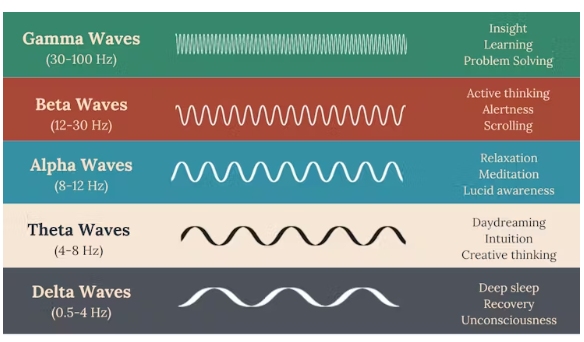

该设备输出5种主要的脑电波频率,标准化的“注意力”和“冥想”值,以及原始的脑电图电位读数。

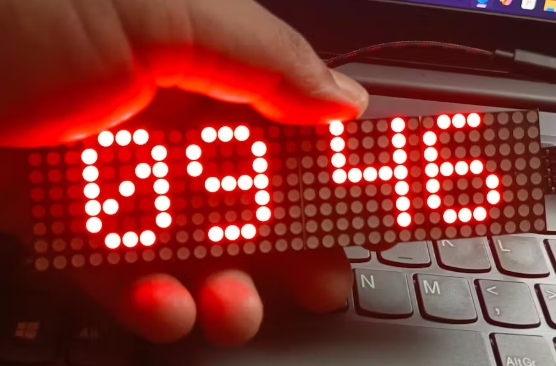

眨眼/眼睑运动引发了一个巨大的电位峰值,被电极捕捉到,正如你在这个动图中看到的那样。

通常这是一个被过滤掉的伪信号,但在我们的例子中,这实际上是我们用来作为控制信号的。

Brain-to-Text输入

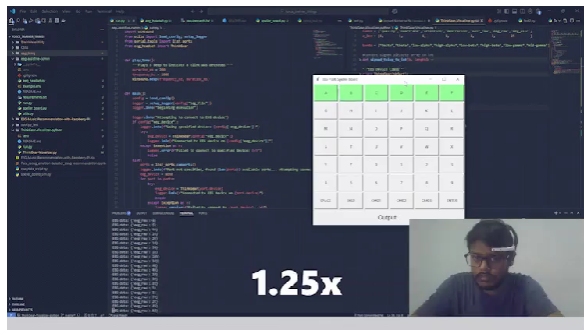

使用眨眼检测到文本输入实际上是相当简单的,使用拼写板/拼写矩阵。

拼字板是脑机和辅助通信系统中常用的接口,可以帮助用户在没有物理输入的情况下进行打字。它通常显示一个字符网格(如字母或单词),系统突出显示模式中的行和列。

当正确的行或列闪烁时,用户通过响应来选择他们想要的字符——通常带有可检测的信号,如眨眼、眼球运动或脑电波模式。然后,系统将选定的行和列结合起来,以确定预期的字符。

在这个项目中,眨眼被用作确认选择的触发器,作为用户意图的信号。

上下文捕获

尽管我们可以简单地使用用户输入的文本来生成自动补全建议,但我们很有可能会得到不相关或不正确的补全,这违背了最小化认知和体力劳动的目的。

然而,通过捕获用户看到和听到的内容,我们可以在生成建议之前使用对话和视觉设置来更好地通知LLM。

LLM可以使用周围的上下文来生成高度相关的自然语言建议,这大大减少了用户传达其意图的努力。

这很简单,使用安装在身体上的相机定期拍照,并使用麦克风捕捉对话音频。

图像和音频被发送到LLM生成描述性文本和对话转录。

作为一个例子,如果我们在下图中输入:

法学硕士可能会生成以下场景描述:

这是一个光线充足的理疗室,有各种运动和康复设备。一个双杠设置占据中心,暗示步态训练。这里有健身球和阻力机,表明了对力量和平衡锻炼的关注。该设置意味着一个面向身体恢复和治疗的医疗保健环境。

把它们放在一起

现在我们已经实现了所有的关键部分,我们可以把它们放在一起。

用户输入的文本和环境上下文一起被提供给LLM, LLM生成高度相关的建议,以自动完成用户输入。

LLM遵循严格的结构化JSON输出,包含:

建议:基于用户输入和上下文的建议短语/句子

推理:法学硕士提出建议的推理路线。法学硕士被提示遵循不同的推理路线,以确保不同的输出。

Contextual_relevance_score: 1-5之间的自我评估分数,表明建议与上下文的相关性

confence_score: 1-5之间的自我评估分数,表示LLM对建议代表用户意图的自信程度

另一个来自脑电图耳机的控制信号将显示用户选择的选项,这使得用户能够以最小的输入有效地传达他们的意图。

总的来说,这个系统使有严重运动或语言障碍的人能够更清楚、更快速、更自然地表达自己。

本文编译自hackster.io