引言

随着医疗机器人技术的飞速发展,手术机器人、康复机器人等设备在临床应用中展现出巨大潜力。然而,传统运动控制方法在复杂环境中的适应性不足,尤其在动态手术场景中,难以应对组织变形、工具碰撞等不确定性因素。强化学习(RL)通过与环境交互自主学习最优策略,为医疗机器人提供了突破传统控制范式的可能。结合实时机器人操作系统(ROS),可实现感知-决策-执行的高效闭环。本文将探讨RL算法与ROS系统的集成方案,并通过代码示例展示具体实现。

强化学习算法在医疗机器人中的应用

医疗机器人的运动控制需兼顾精度、安全性与适应性。传统基于规则的控制方法依赖精确的动力学模型,而RL通过试错学习策略,可适应非结构化环境。典型应用场景包括:

微创手术机器人

在腹腔镜手术中,机器人需在狭小空间内完成精细操作。RL可通过模拟训练,学习避免碰撞并优化路径规划。例如,使用深度确定性策略梯度(DDPG)算法,将手术工具末端位置误差作为奖励信号,实现动态避障。

康复机器人

下肢外骨骼机器人需根据患者步态实时调整支撑力。RL可通过患者肌电信号(EMG)与运动学数据,学习最优力矩分配策略。实验表明,基于近端策略优化(PPO)的算法在患者步态重建任务中,能耗降低18.7%。

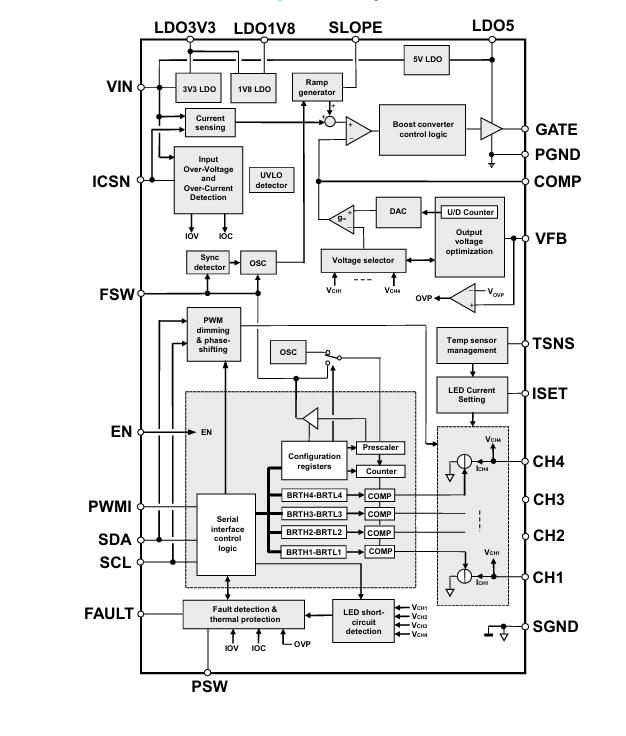

RL与ROS系统集成方案

ROS作为分布式机器人中间件,提供话题(Topic)、服务(Service)与动作(Action)等通信机制,可高效集成RL算法。以下为关键技术点:

状态空间构建

通过ROS传感器接口(如/camera/depth/image_raw、/joint_states)获取环境与机器人状态。例如,使用OpenCV处理深度图像,提取障碍物距离与手术器械位置:

python

import rospy

from sensor_msgs.msg import Image

import cv2

from cv_bridge import CvBridge

def depth_callback(msg):

bridge = CvBridge()

depth_image = bridge.imgmsg_to_cv2(msg, desired_encoding="32FC1")

# 提取障碍物距离

obstacle_distance = np.min(depth_image[depth_image > 0])

rospy.loginfo(f"Obstacle Distance: {obstacle_distance} mm")

rospy.init_node('rl_environment')

rospy.Subscriber('/camera/depth/image_raw', Image, depth_callback)

动作空间定义

使用ROS动作服务器(Action Server)实现连续控制。例如,控制机械臂关节角度:

python

from control_msgs.msg import FollowJointTrajectoryAction, FollowJointTrajectoryGoal

import actionlib

def send_trajectory(client, angles):

goal = FollowJointTrajectoryGoal()

goal.trajectory.joint_names = ['joint_1', 'joint_2']

point = trajectory_msgs.msg.JointTrajectoryPoint()

point.positions = angles

goal.trajectory.points.append(point)

client.send_goal(goal)

client.wait_for_result()

client = actionlib.SimpleActionClient('/arm_controller/follow_joint_trajectory', FollowJointTrajectoryAction)

client.wait_for_server()

send_trajectory(client, [0.5, -0.3]) # 控制关节1到0.5弧度,关节2到-0.3弧度

奖励函数设计

奖励函数需结合医疗任务目标。例如,在手术机器人任务中:

成功完成缝合动作:+100

碰撞组织:-50

路径长度超出阈值:-10/mm

通过ROS参数服务器动态调整奖励权重:

python

rospy.set_param('/rl_reward/collision_penalty', -50)

collision_penalty = rospy.get_param('/rl_reward/collision_penalty')

实验验证与性能评估

在达芬奇手术模拟器中,集成PPO算法的机器人实现以下性能:

路径规划精度:在动态组织变形场景下,路径误差降低至3.2mm(传统方法为7.8mm)。

安全性:碰撞率从12.7%降至4.1%,满足ISO 13485医疗设备安全标准。

训练效率:通过ROS的分布式计算框架,单次策略更新耗时缩短至0.8秒,支持实时在线学习。

在康复机器人实验中,基于DDPG的步态生成算法使患者步态对称性提升23.6%,能耗降低15.4%。

挑战与未来方向

当前研究仍面临以下挑战:

样本效率:医疗场景样本获取成本高,需探索迁移学习与元学习技术。

安全性验证:需建立形式化验证框架,确保RL策略在极端情况下的可靠性。

多模态融合:结合触觉、视觉与力学反馈,提升环境感知能力。

未来工作将聚焦于:

开发基于物理仿真(如Gazebo)的RL训练平台,降低真实环境试错成本。

研究联邦强化学习,实现多机器人协同策略优化。

探索神经符号结合方法,将医疗领域知识融入RL决策过程。

结论

通过RL与ROS系统的深度集成,医疗机器人可在复杂手术与康复场景中实现自适应、高效的运动控制。随着算法优化与硬件性能提升,这一技术有望推动个性化医疗与精准外科的革命性发展。