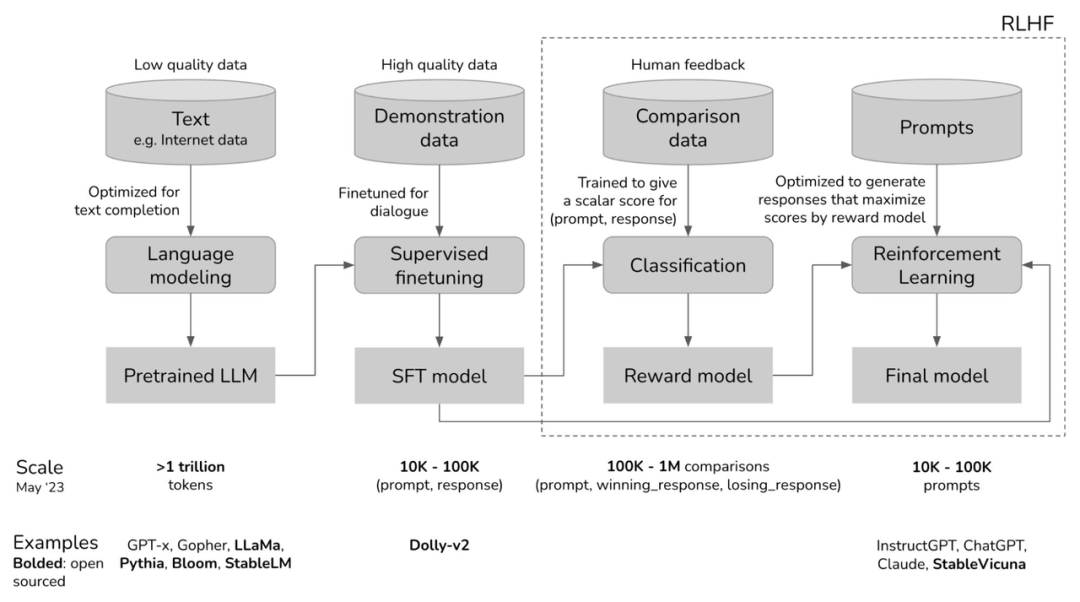

大模型的通用训练流程 [1]

大模型的通用训练流程 [1]

在大语言模型的训练过程中,预训练阶段消耗了大量资源,也充满了太多未被揭开的秘密。根据OpenAI的研究,InstructGPT在预训练阶段几乎使用了所有的计算和数据资源 [2]。有监督微调和人类反馈强化学习能够激活预训练模型内部已存在的能力,而这些能力仅仅通过提示工程难以发掘。但是,预训练的价值远不止于此,它像一个充满潜力的神秘盒子,等待我们去探索其更深层次的价值和隐藏的机制。

预训练模型就像一个未加控制的野兽,神秘而强大。通过高质量数据进行微调,我们可以使这个野兽适应社会的需要;随后通过RLHF进一步完善,模型更加贴近用户的具体需求。对齐技术如SFT和RLHF等,可以被看作是对这个野兽的驯化。但目标不止如此,我们更希望深入了解它,探究使得LLMs展现出其独特能力的根本过程--The Pre-training。 大部分开源LLMs仅提供模型权重和性能测试的结果,但是要真正理解一个模型的行为,需要更多的信息。LLM360 [4] 和 OLMo [5] 的全面开源为研究者和社区提供了全面和深入的信息共享,涵盖了训练数据、算法设置、实现挑战以及性能评估的细节,极大地增加了LLMs预训练过程的透明度,帮助我们理解这些LLMs的工作原理。 我们都想知道这个问题的答案,人类可以信任LLMs吗?作为一个观察者,我们尝试从预训练阶段来窥探这个庞然大物。我们致力于理解LLMs在预训练阶段是如何建模可信的,并基于这个理解,探索预训练阶段是否能为增强LLMs的可信提供指导。

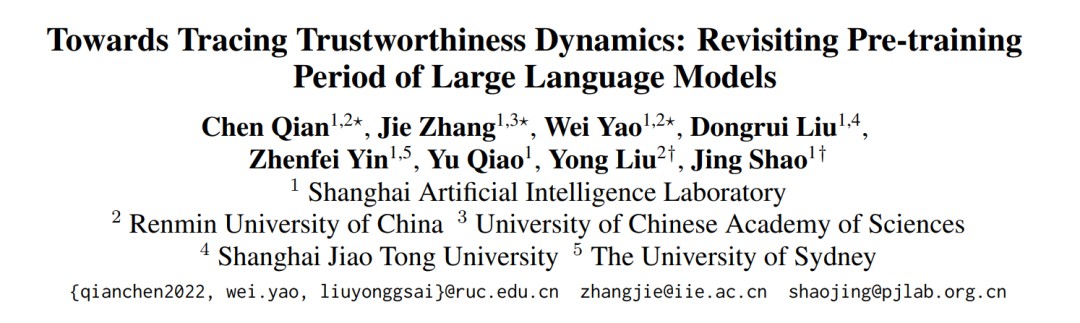

论文标题:Towards Tracing Trustworthiness Dynamics: Revisiting Pre-training Period of Large Language Models 论文链接:https://arxiv.org/abs/2402.19465 项目主页:https://github.com/ChnQ/TracingLLM

在此工作中,我们首次给出了如下几个观察: •我们发现LLMs在预训练的早期阶段就建立了有关可信概念的线性表征; •我们发现预训练过程中,LLMs表现出对于可信概念类似于“信息瓶颈”先拟合、再压缩的学习过程; •我们基于表征干预技术,初步验证了LLMs在预训练过程中的切片可以帮助提升最终LLMs的可信性。

1 预训练过程中有关可信概念的线性表征

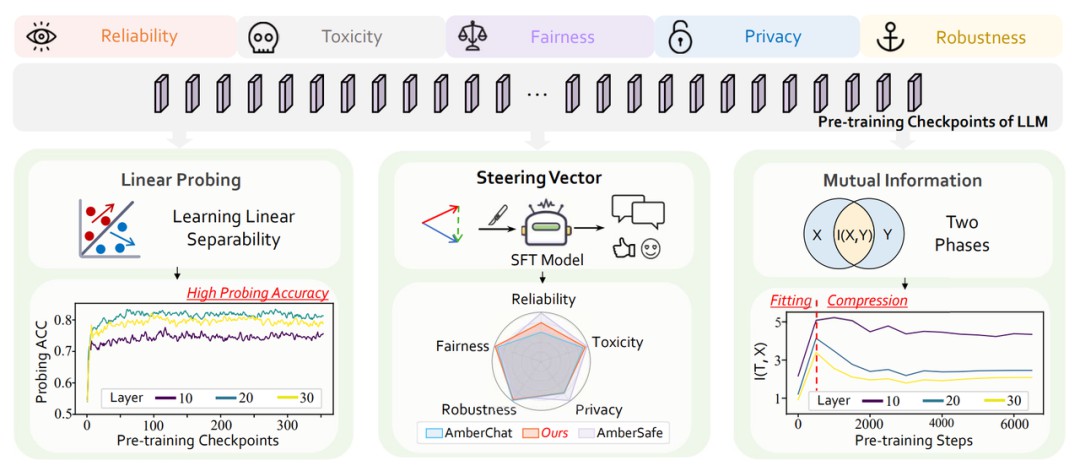

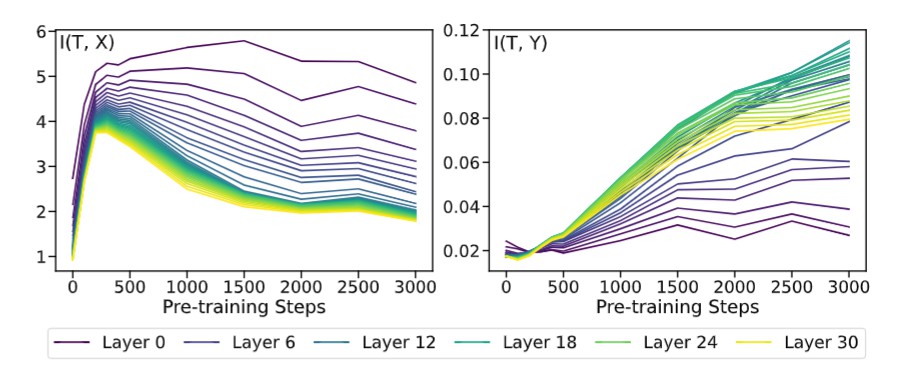

数据集:本文主要探究可信领域下的五个关键维度:可靠性、毒性、隐私性、公平性和鲁棒性。为了深入研究这些维度,我们分别选取了这五个维度下具有代表性的相关数据集:TruthfulQA、Toxicity、ConfAIde、StereoSet以及经过特定扰动处理的SST-2。我们根据原数据集的设定,对每个样本进行标注,以标识每句话是否包含不正确、有毒、隐私泄露、有歧视和被扰动的信息。 实验设置:本文采用线性探针方法 [6]。具体地,在得到360个切片对于每个数据集的表征以后,我们对于每个切片的每一层都训练一个线性分类器,线性分类器的正确率代表着模型内部表征区分不同标签的能力。前75个切片实验效果如下:  从第76个到360的切片的实验结果请移步正文附录,实验趋势大体相同,基本趋于平缓的波动。 实验结果说明两点: •随着预训练的进行,在这五个可信维度上,大模型中间层的表征可以很好地区分是否可信 •大模型在预训练的早期阶段就已经可以很好地区分是否可信,2 信息瓶颈视角下有关可信概念的预训练动态 已有理论结果 [7] 证明线性探针的准确率可以用来界定互信息估计器。受到利用互信息来探测模型训练动态的启发 [8],本文也利用互信息对模型表征的动态变化做了初步探索。类似 [8] 用信息平面研究传统神经网络的训练过程,我们分别研究模型表征T与上面五个原始数据集X的互信息,和模型表征T与数据集标签Y的互信息。实验结果如下:

从第76个到360的切片的实验结果请移步正文附录,实验趋势大体相同,基本趋于平缓的波动。 实验结果说明两点: •随着预训练的进行,在这五个可信维度上,大模型中间层的表征可以很好地区分是否可信 •大模型在预训练的早期阶段就已经可以很好地区分是否可信,2 信息瓶颈视角下有关可信概念的预训练动态 已有理论结果 [7] 证明线性探针的准确率可以用来界定互信息估计器。受到利用互信息来探测模型训练动态的启发 [8],本文也利用互信息对模型表征的动态变化做了初步探索。类似 [8] 用信息平面研究传统神经网络的训练过程,我们分别研究模型表征T与上面五个原始数据集X的互信息,和模型表征T与数据集标签Y的互信息。实验结果如下:  后续预训练过程的变化趋势见附录,几乎保持平缓的波动。 分开看这两张图,T和X的互信息先上升后下降,而T和Y的互信息一直在上升。把它们合起来看,这个趋势与经典论文 [8] 中的“fitting”和“compression”两阶段相符:首先,当大语言模型随机初始化时,它不具备保留信息的能力,因此互信息几乎为0;接着,随着预训练的进行,大模型逐渐具备语言理解和概念建模的能力,因此互信息持续增长;最后,随着预训练的进一步进行,大模型逐渐学会提取压缩无关信息并提取有效信息,因此T和X的互信息降低,而T和Y的互信息继续增加。从互信息的角度,这是一个很有趣的发现。即使定义和实验设置不同,预训练大语言模型和传统神经网络,两者的预训练阶段都能分为“fitting”和“compression”两个阶段,这暗示着大模型和传统神经网络训练过程中可能存在的一些相似之处。 总体来看,据我们所知,本文首次研究大模型在预训练过程中可信性概念建模的变化情况,我们希望我们的初步探索能帮助领域内的研究者更深入地理解大模型的预训练过程,启发大家用新方法帮助大模型变得更加可信。

后续预训练过程的变化趋势见附录,几乎保持平缓的波动。 分开看这两张图,T和X的互信息先上升后下降,而T和Y的互信息一直在上升。把它们合起来看,这个趋势与经典论文 [8] 中的“fitting”和“compression”两阶段相符:首先,当大语言模型随机初始化时,它不具备保留信息的能力,因此互信息几乎为0;接着,随着预训练的进行,大模型逐渐具备语言理解和概念建模的能力,因此互信息持续增长;最后,随着预训练的进一步进行,大模型逐渐学会提取压缩无关信息并提取有效信息,因此T和X的互信息降低,而T和Y的互信息继续增加。从互信息的角度,这是一个很有趣的发现。即使定义和实验设置不同,预训练大语言模型和传统神经网络,两者的预训练阶段都能分为“fitting”和“compression”两个阶段,这暗示着大模型和传统神经网络训练过程中可能存在的一些相似之处。 总体来看,据我们所知,本文首次研究大模型在预训练过程中可信性概念建模的变化情况,我们希望我们的初步探索能帮助领域内的研究者更深入地理解大模型的预训练过程,启发大家用新方法帮助大模型变得更加可信。

3 基于引导向量的表征干预:预训练知识如何助力模型可信能力提升

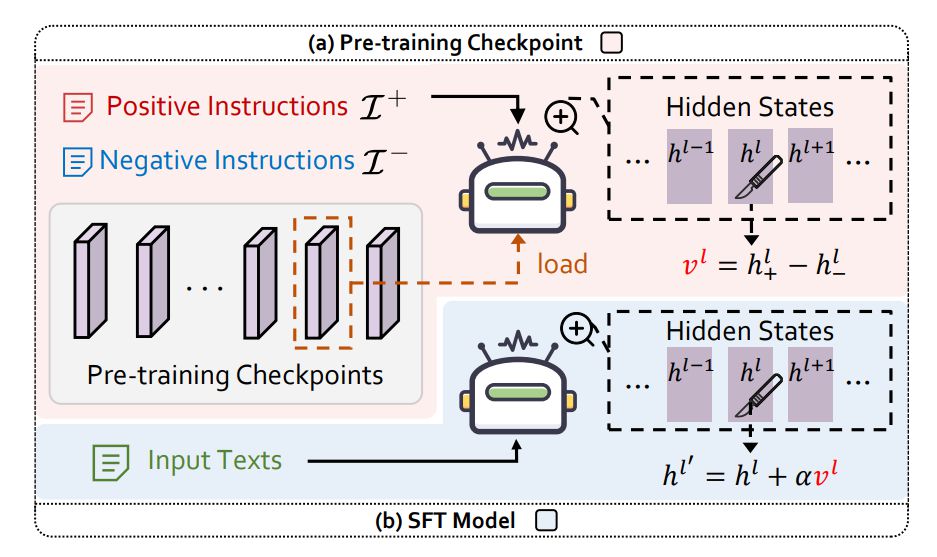

3.1 Activation Intervention 我们观察到,既然LLMs在其预训练阶段就已经学习到了有关可信概念线性可分的表征,那么不同于现在的大多数技术如SFT,RLHF等在完成预训练的模型上进一步优化,一个很自然的想法是:LLMs在预训练过程中的切片能不能帮助指令微调模型进行alignment呢? 我们基于表征干预的技术,给予该问题初步的肯定的回答。

不同于上述工作从待干预模型自身抽取引导向量,我们意在从LLMs预训练过程的切片中构建引导向量来干预指令微调模型,试图提升指令微调模型的可信能力,如下图所示。  其中,我们使用北京大学团队 [11] 开源的PKU-RLHF-10K数据集 [12] 来构建正负prompt对,该数据集提供了一万条带有安全/非安全回复标注的对话数据,可用于大模型的 RLHF 训练。 3.2 实验结果分析,

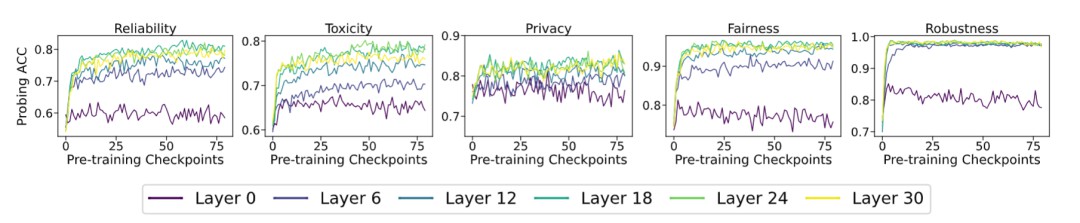

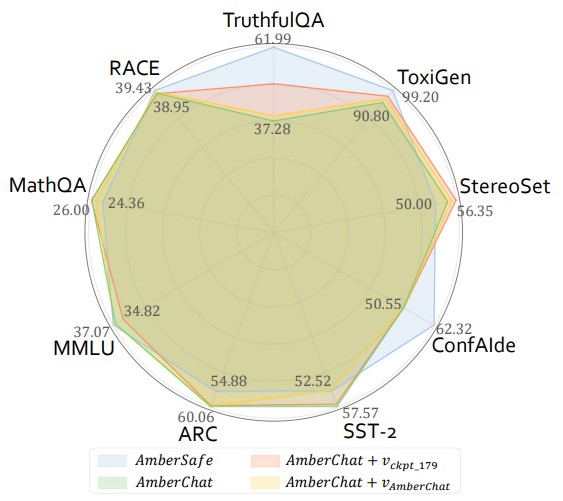

其中,我们使用北京大学团队 [11] 开源的PKU-RLHF-10K数据集 [12] 来构建正负prompt对,该数据集提供了一万条带有安全/非安全回复标注的对话数据,可用于大模型的 RLHF 训练。 3.2 实验结果分析, 我们在上文提及的可信领域下五个维度的数据集,以及四个常用的大模型通用能力评测数据集上,评测了四个模型的性能:指令微调模型AmberChat,安全对齐模型AmberSafe,使用来自AmberChat自身的steering vector干预后的AmberChat,使用来自第180个预训练切片的steering vector干预后的AmberChat。

我们在上文提及的可信领域下五个维度的数据集,以及四个常用的大模型通用能力评测数据集上,评测了四个模型的性能:指令微调模型AmberChat,安全对齐模型AmberSafe,使用来自AmberChat自身的steering vector干预后的AmberChat,使用来自第180个预训练切片的steering vector干预后的AmberChat。

实验结果表明,在使用来自预训练切片的steering vector干预SFT模型表征后,在三个可信维度上都有较明显的提升。同时,这种干预对模型通用能力的影响并不显著。 令人惊讶的是,我们发现使用预训练的中间切片构建的steering vector,相比于来自AmberChat自身的引导向量,能更显著地提升AmberChat模型的可信性能。

4 小结,未来,当我们尝试对齐比人类更强大的模型时,依赖于“人类反馈”的相关微调技术,如RLHF等,或将不再奏效 [13-14]。为了应对这一可能的挑战,多个研究机构正在探索新的解决方案。例如,近期OpenAI提出“弱对强监督”方法 [13],Meta提出“self-reward”机制 [14],同时也有越来越多的研究聚焦于“self-alignment”研究方向的探索 [15-16]。 我们的研究为解决类似的super-alignment问题提供了一个新的视角:利用LLMs在预训练过程中习得的知识来辅助最终的模型对齐。作为研究的起点,我们深入探究预训练过程中如何建模有关可信的概念。可喜的是,探索初见成效:1)我们发现大模型在预训练的早期阶段就建立了有关可信概念的线性表征 2)我们发现大模型对可信概念类似于信息瓶颈的学习过程。此外,表征干预技术的成功应用也初步验证了预训练中间切片对辅助模型对齐的有效性。 我们希望这份工作能够为深入理解LLMs如何动态构建及发展其内在可信属性提供新的视角,并启迪未来在LLMs对齐技术领域的更多创新尝试。我们期待这些研究成果能进一步推动大模型朝着更可信、更可控的方向发展,从而在人工智能伦理与安全道路上迈出坚实的一步。

参考文献,[1] https://huyenchip.com/2023/05/02/rlhf.

[2] https://openai.com/research/instruction-following,[3] twitter.com/anthrupad,[4] Liu, Z., Qiao, A., Neiswanger, W., Wang, H., Tan, B., Tao, T., ... & Xing, E. P. . Llm360: Towards fully transparent open-source llms. arXiv preprint arXiv:2312.06550.,[5] Groeneveld, D., Beltagy, I., Walsh, P., Bhagia, A., Kinney, R., Tafjord, O., ... & Hajishirzi, H. . OLMo: Accelerating the Science of Language Models. arXiv preprint arXiv:2402.00838.,[6] Belinkov, Y. . Probing classifiers: Promises, shortcomings, and advances. Computational Linguistics, 48, 207-219.,[7] Choi, K., Jung, J. W., & Watanabe, S. . Understanding Probe Behaviors through Variational Bounds of Mutual Information. arXiv preprint arXiv:2312.10019.,[8] Shwartz-Ziv, R., & Tishby, N. . Opening the black box of deep neural networks via information. arXiv preprint arXiv:1703.00810.,[9] Li, K., Patel, O., Viégas, F., Pfister, H., & Wattenberg, M. . Inference-time intervention: Eliciting truthful answers from a language model. Advances in Neural Information Processing Systems, 36.,[10] Turner, A., Thiergart, L., Udell, D., Leech, G., Mini, U., & MacDiarmid, M. . Activation addition: Steering language models without optimization. arXiv preprint arXiv:2308.10248.,[11] Ji, J., Liu, M., Dai, J., Pan, X., Zhang, C., Bian, C., ... & Yang, Y. . Beavertails: Towards improved safety alignment of llm via a human-preference dataset. Advances in Neural Information Processing Systems, 36.,[12] https://huggingface.co/datasets/PKU-Alignment/PKU-SafeRLHF-10K,[13] Burns, C., Izmailov, P., Kirchner, J. H., Baker, B., Gao, L., Aschenbrenner, L., ... & Wu, J. . Weak-to-strong generalization: Eliciting strong capabilities with weak supervision. arXiv preprint arXiv:2312.09390.,[14] Yuan, W., Pang, R. Y., Cho, K., Sukhbaatar, S., Xu, J., & Weston, J. . Self-rewarding language models. arXiv preprint arXiv:2401.10020.,[15] Sun, Z., Shen, Y., Zhou, Q., Zhang, H., Chen, Z., Cox, D., ... & Gan, C. . Principle-driven self-alignment of language models from scratch with minimal human supervision. Advances in Neural Information Processing Systems, 36.,[16] Li, X., Yu, P., Zhou, C., Schick, T., Levy, O., Zettlemoyer, L., ... & Lewis, M. . Self-Alignment with Instruction Backtranslation. In The Twelfth International Conference on Learning Representations.

推荐

-

VCSEL芯片和光学解决方案提供商瑞识科技完成近亿元B1轮融资

VCSEL芯片和光学解决方案提供商瑞识科技完成近亿元B1轮融资

2023-07-03

-

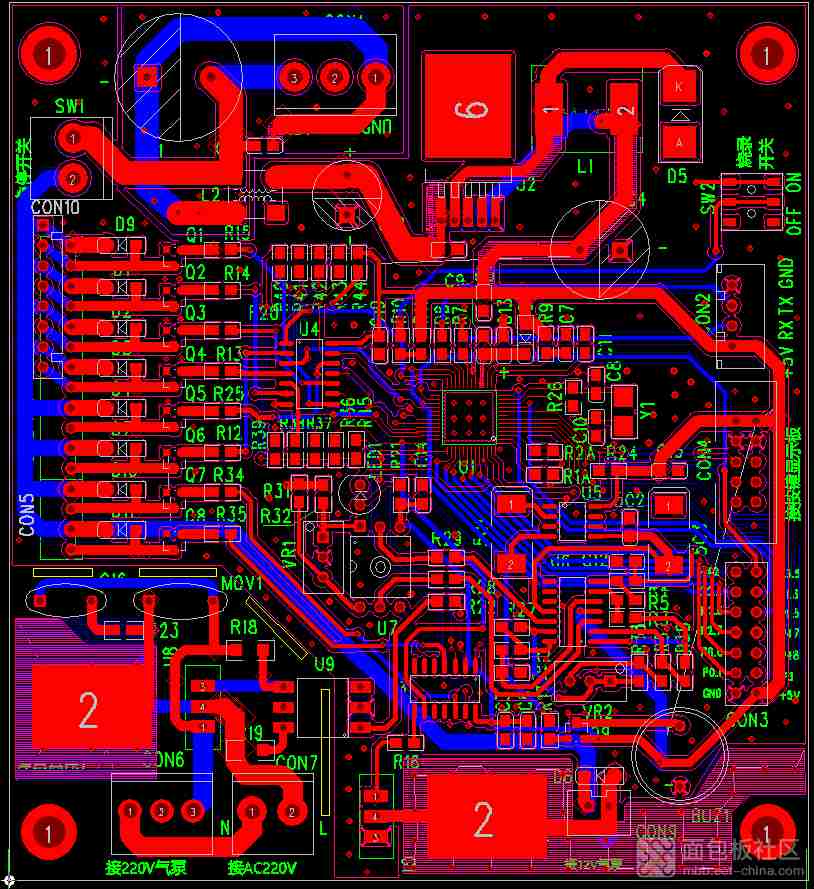

一文带你搞懂开关电源电路

一文带你搞懂开关电源电路

2024-11-02

-

基于脱硝系统改造的自动化优化分析

基于脱硝系统改造的自动化优化分析

2025-02-20

-

阿诗特能源L1000液冷新品震撼上市,卓越性能,引领未来!

阿诗特能源L1000液冷新品震撼上市,卓越性能,引领未来!

2024-06-15

-

博世与芯驰科技全面深化战略合作 围绕车用半导体核心技术

博世与芯驰科技全面深化战略合作 围绕车用半导体核心技术

2025-04-10

-

PLL锁相环:工作原理简述,高效同步控制的核心技术。

PLL锁相环:工作原理简述,高效同步控制的核心技术。

2024-04-07

-

中科曙光助力北京航天总医院打造24小时在线的AI医疗助手

中科曙光助力北京航天总医院打造24小时在线的AI医疗助手

2025-04-10

-

国产替代奋进高端,创新引领,开启替代新篇章。

国产替代奋进高端,创新引领,开启替代新篇章。

2024-04-07

-

模拟芯片与数字芯片各有独特优势,各具魅力,吸引你的目光。

模拟芯片与数字芯片各有独特优势,各具魅力,吸引你的目光。

2024-03-06

-

本征半导体,基础材料之选,了解它,掌握电子世界的关键!

本征半导体,基础材料之选,了解它,掌握电子世界的关键!

2024-04-07

最近更新

-

TrendForce集邦咨询: 关税变量对显示器需求与售价及AMOLED上游材料的影响

TrendForce集邦咨询: 关税变量对显示器需求与售价及AMOLED上游材料的影响

2025-04-20

-

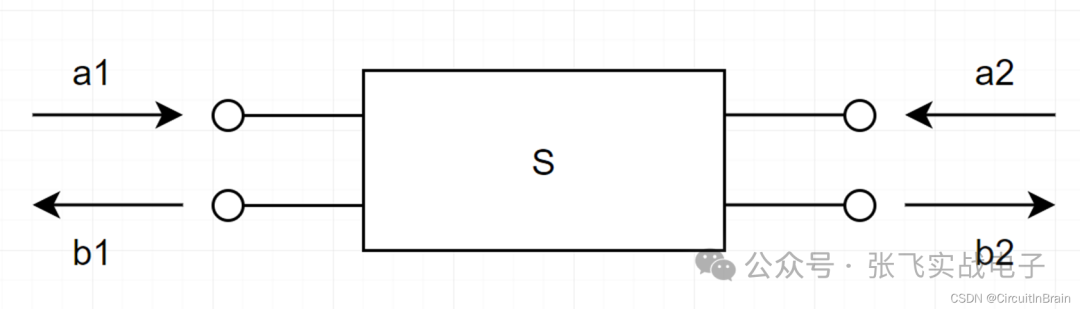

S参数与插入损耗和回波损耗

S参数与插入损耗和回波损耗

2025-04-20

-

基于SiWG917Y的无电池Wi 6传感器

基于SiWG917Y的无电池Wi 6传感器

2025-04-19

-

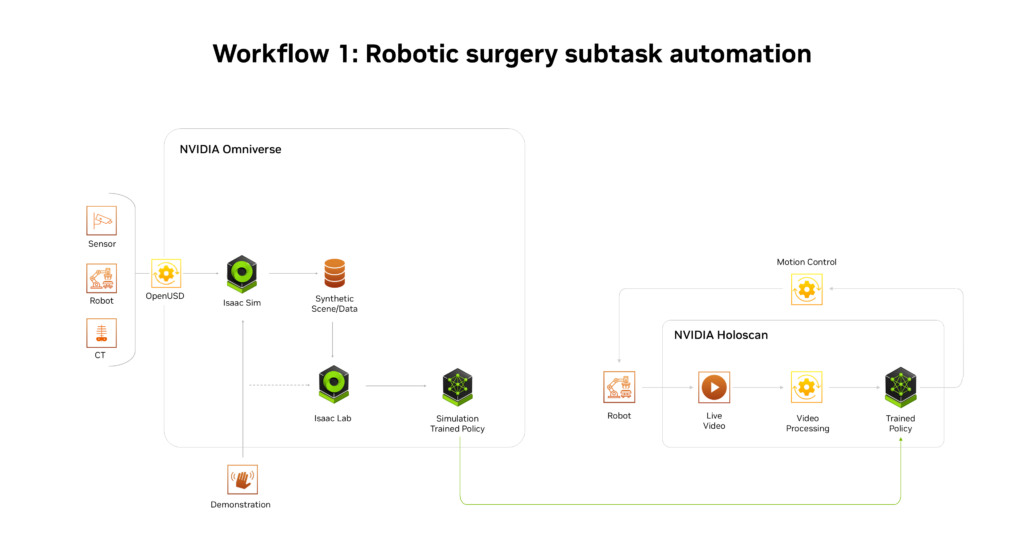

NVIDIA推出AI医疗健康机器人开发平台

NVIDIA推出AI医疗健康机器人开发平台

2025-04-19

-

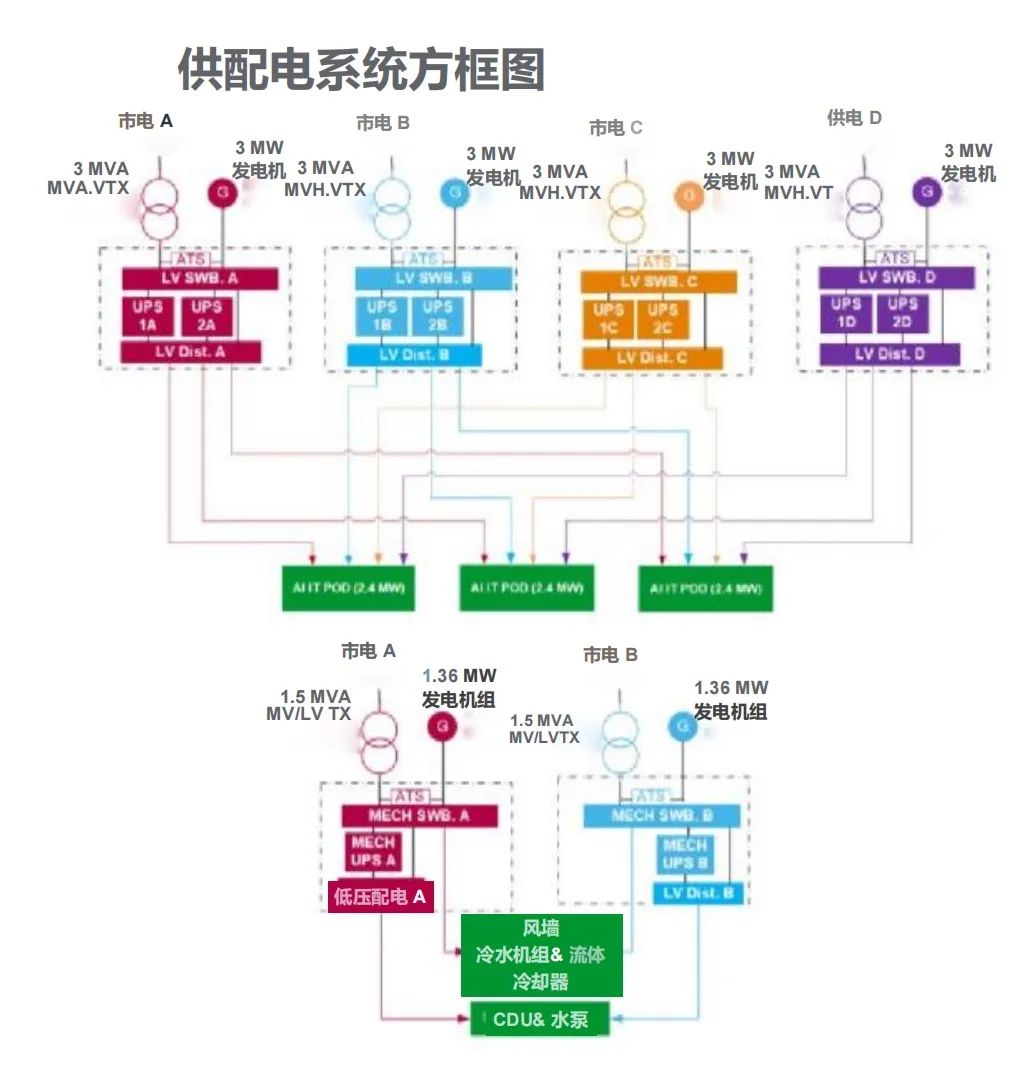

施耐德电气发布数据中心高密度AI集群部署解决方案

施耐德电气发布数据中心高密度AI集群部署解决方案

2025-04-19

-

航裕电源亮相2025慕尼黑上海电子展

航裕电源亮相2025慕尼黑上海电子展

2025-04-19

-

RECOM RACPRO1系列荣获2025年红点产品设计奖

RECOM RACPRO1系列荣获2025年红点产品设计奖

2025-04-19

-

广汽昊铂首家直营交付中心开业

广汽昊铂首家直营交付中心开业

2025-04-19

-

季丰成都实验室开启芯片微加工新篇章

季丰成都实验室开启芯片微加工新篇章

2025-04-19

-

航裕电源亮相2025俄罗斯国际电子元器件展

航裕电源亮相2025俄罗斯国际电子元器件展

2025-04-19