算力是设备通过处理数据,实现特定结果输出的计算能力,常用FLOPS作为计量单位。FLOPS是Floating-point Operations Per Second的缩写,即每秒所能够进行的浮点运算数目。

算力可以分为通用算力、智能算力和超算算力。早前通用算力占整体算力的比重达到90%以上,近些年随着人工智能技术的发展,智能算力规模迅速增长。从需求层面看,2022年,中国智能算力规模为268百亿亿次/秒,已经超过通用算力规模。

大模型对智能算力提出更高要求

通用算力、智能算力和超算算力三者的区别在于,通用算力,由基于CPU芯片的服务器提供算力,主要用于基础通用计算。日常提到的云计算、边缘计算等都属于基础算力,它为移动计算、物联网等提供计算支持。

智能算力,由基于GPU、FPGA、ASIC等AI芯片的加速计算平台提供的算力,主要用于人工智能的训练和推理计算,比如语音、图像和视频的处理。在技术架构上,人工智能的核心计算能力由训练、推理等专用计算芯片提供,注重单精度、半精度等多样化计算能力。

超算算力,由超级计算机等高性能计算集群提供算力,主要用于尖端科学领域的计算,比如行星模拟、药物分子设计、基因分析等。在技术架构上,超算的核心计算能力由高性能CPU或协处理器提供,注重双精度通用计算能力,追求精确的数值计算。

2023年以来大模型迅猛发展,更是让智算中心成为发展的重点。当然,相比于之前,大模型对智算中心也提出更高要求。首先是随着大模型规模的不断扩大,对计算资源的需求不断增加,智算中心需要提供更强大的计算能力来支持大模型的训练和推理任务。

其次是大模型需要大量的存储空间来存储参数、权重和中间结果,智算中心需要提供高效的存储系统。第三是大模型的训练和推理过程中会产生大量的数据,需要进行频繁的数据传输和通信,智算中心需要具备高速的网络连接和大规模的数据传输能力。

第四则是大模型的训练和推理过程需要大量的计算资源,导致能源消耗的增加,智算中心需要采取节能措施,如使用高效的硬件设备和优化算法,以降低能源消耗。另外还有,大模型的训练和推理过程需要进行复杂的模型管理和调度,包括模型版本控制、并行训练和推理等,智算中心需要提供相应的管理和调度工具来支持这些任务。

各地和企业建设智算中心支持大模型

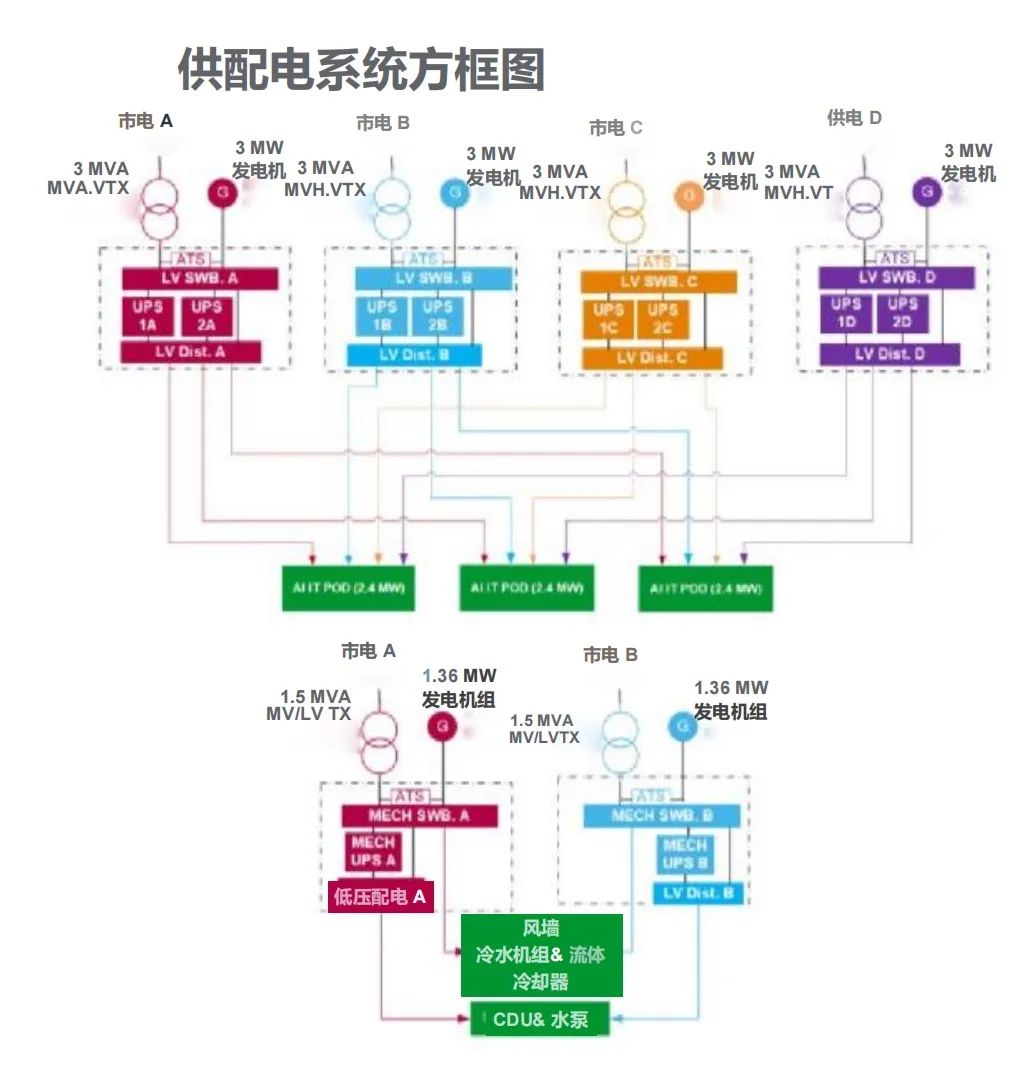

对于各地方和企业来说,建设能够支持大模型的智算中心已经成为当下的重点。近日,上海电信联合徐汇区政府共同举办“算力惠模都 万兆连速城”人工智能公共算力服务产品发布会,消息称,2024年上半年,中国电信将在上海规划建设到达15000卡,总算力超4500P。其中,单池新建国产算力达万卡,是国内首个超大规模国产算力液冷集群。

据介绍,该集群采用新一代国产AI算力,实现了全栈自主创新和技术突破,通过高速RDMA连接各物理机节点,提供低延时、高吞吐量、无损通信网络和强大的并行计算能力,是目前规模最大的全国产液冷机房,多项技术指标领跑全国。

该集群最高可支持万亿参数大模型,便于各科研院校、大模型训练公司等机构和企业实现物理资源独享,无虚拟化损耗,满足AI计算、深度学习、图形渲染等复杂训练任务对算力的要求。

早前广州海珠区和中国电信广州分公司也携手揭牌了粤港澳大湾区首个服务大模型的智算中心。该智算中心搭载华为最新一代高端算力芯片昇腾910B,昇腾910B在大模型训练场景性能和A100持平,可提供全流程工具辅助大模型迁移。

中国电信广州分公司云技术总监时瑞表示,目前各种个性化推荐算法都需要调用智算,包括人脸识别、汽车自动驾驶等各种场景。他介绍,中心目前建成算力100P,计划两年内扩展到300P。海珠区相关负责人表示,该智算中心定位服务大模型,主要服务于广州市人工智能与数字经济试验区至粤港澳大湾区大模型研发运用。

写在最后

随着人工智能技术发展,智能算力的规模已经超过通用算力。近年来,大模型迅猛发展,使得智能算力市场需求会越来越大,同时大模型也给智能算力提出更高要求。为了抓住大模型发展带来的产业机会,各地及企业都在积极建设智算中心来支持大模型训练部署。