人工智能芯片需要什么样的基础器件?

今日,第八届未来芯片论坛在北京举办。未来芯片论坛是清华大学集成电路学院和北京集成电路高精尖创新中心主办的重要年度学术会议,为领域内的高校、研究机构、企业搭建一个跨界、跨学科的思想交流平台。国际欧亚科学院院士,清华大学魏少军教授对于未来芯片谈了几点自己的思考。 超高算力芯片架构应该具备什么特点? 高性能计算已经进入了E级时代,去年美国能源部发布了世界上第一台E级计算超级计算机。E级计算是一个非常重要的里程碑,能够完成每秒钟一百亿亿次的双精度浮点运算。在该超级计算机发布后,美国总统科学顾问委员会马上宣布,美国高性能计算的下一个目标是Z级计算。和E级计算相比,Z级计算会快千倍。

业界对追求更高的运算速度是永无止境的。并且数据的总量还在增加,到2024年,数据的总量会达到100ZB。数据量的增长很大。尤其是人工智能增长后,数据更大,所以Z级计算已经成为业内不得不解决的事情。 魏少军指出:“简单依靠工艺技术进步,几乎无法实现更高性能计算。”原因很简单,按照美国前沿计算机的使用的工艺来推理,比如现在用6nm工艺,功耗高达21.1兆瓦,占地680平方米。半导体工艺继续向前发展,还有5nm、4nm、3nm。如果使用3nm工艺来实现Z级计算,现在的功耗高达8000兆瓦,意味着一个小时使用800万度电,也就是一个小时大概400万人民币的电费。从成本来说,使用3nm工艺来实现Z级计算要花6000亿美元。

尽管工艺的进步会带来成本的下降,但总体来说直接的成本不会下降太多,占地面积在几十万平方米,这几十万平方米也会带来巨大的延迟。因此,简单地靠工艺进步几乎无法实现更高性能的计算。 目前的计算芯片,其计算资源在整个芯片资源中占比很低,小于0.1%,利用率就更低,但是用于数据传输的能耗非常高,比如GPU的能耗就很高,大于90%。基于这样的基本特点,如果立足于现在的计算机构和计算芯片,想要完成下一代计算,难度非常大。 此外,对算力的要求也已经到了无以复加的程度,人工智能的蓬勃发展众所周知,目前人工智能分两类,一类叫类脑计算,还有一类叫深度学习。而这两类涉及的三个基本要素包括算法、数据和算力。

其中,算力对人工智能起到了真正意义上的驱动作用。 目前的人工智能和预计差的很远。一方面,算法和人的识别是不一样的,现在要求人工智能能够适应不同的各种应用。另一方面,人工智能现在的实现过程比较“暴力”。举一个例子,2014年的简单模型,实现大概需要每秒钟196亿次的运算和同时处理1.38亿的参数,这样的高密度运算和高密度存储对于今天的芯片也带来很大的挑战。魏少军说到:“对于计算架构来说,已经进入了‘黄金时代’。到今天为止,要创新计算架构,如果只是沿着原来的传统走下去,是走不下去的。” 未来能够提供支撑的超级计算,基本上是要100亿人民币以下的投资和100兆瓦以内的功耗,占地面积在几万平方米甚至是1万平方米的才能够实现。这样的条件下,对芯片、硬件、软件提出了新的潜在要求。

人工智能芯片需要什么样的基础器件?

智能化延伸我们的认知。以计算机、网络、通信、光电子和集成电路等技术为主要内容的信息革命,实现了人类感官能力的延伸和放大。信息技术将与人工智能技术,新型材料工程等一起携手前行,将信息技术推向全新的高度,实现人类大脑能力的延伸和放大。以机械化、电力化和自动化为主要内容的工业革命解放了人类的双手,提供人类巨大的能源,实现了人类体能的延伸和放大。 从1946年的第一台电子计算机开始,已经经过了三轮智能化浪潮。

以1990年的以日本的第五代计算机作为一个标志,是第一轮智能化浪潮。到2017年,不断地缩小研究范围,使用机器学习的算法进行分类和识别。再到现在,谷歌的DeepMind玩游戏已经比人类的专业玩家好10倍。可以看到,人工智能的发展在多个方面已经超过了人类。 为什么会这样?加拿大的神经科学家作出了重要的贡献。在他的启示下,发展了类脑计算和深度学习后,可以使用深度神经网络的方式来训练,虽然有点暴力,但是可以取得不错的结果。

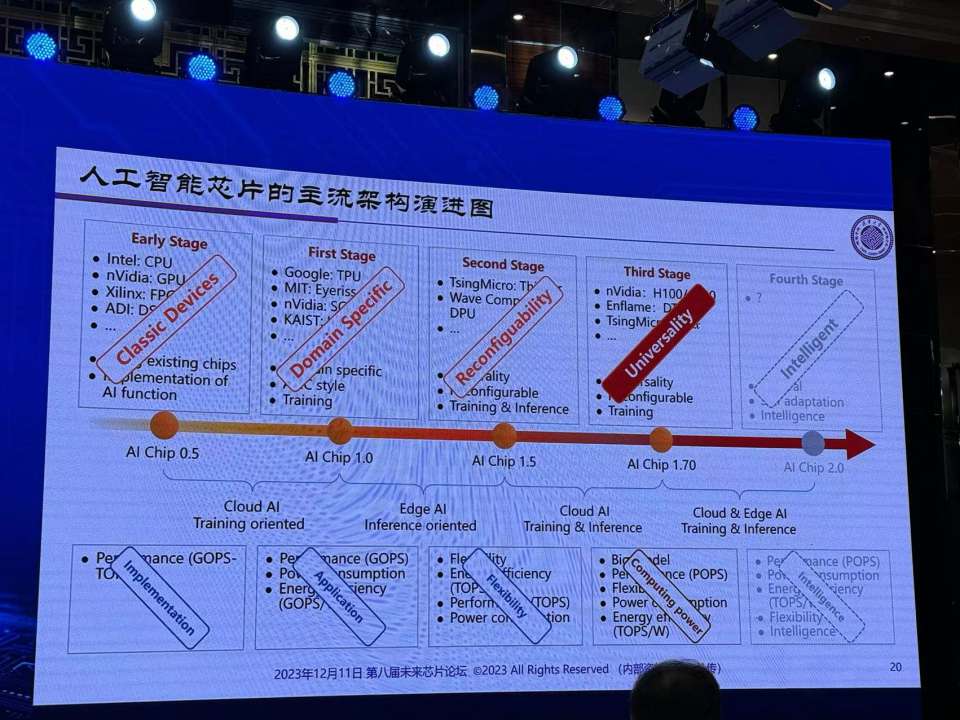

人工智能芯片的主流架构从AI Chip 0.5一直发展到AI Chip 1.7,从云端AI发展到边缘AI。 魏少军表示:“算力是人工智能发展的充分条件,而算力依靠芯片实现,因此芯片不可或缺,后来还出现了专门针对人工智能的芯片。”一个应用就是一个算法, N个应用需要N个芯片,为了解决能够在一个芯片上实现不同的应用,出现了一种以灵活性为主的可重构方法。在处理不同的算法的过程当中,通过算力的提升、通用性的提升进一步提升今天的人工智能。

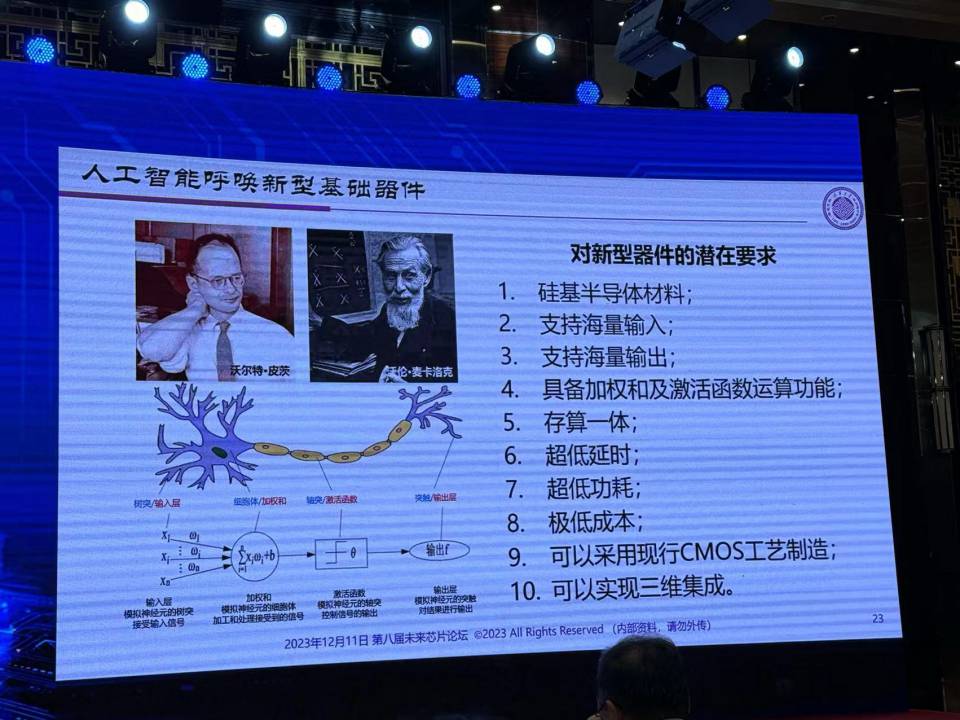

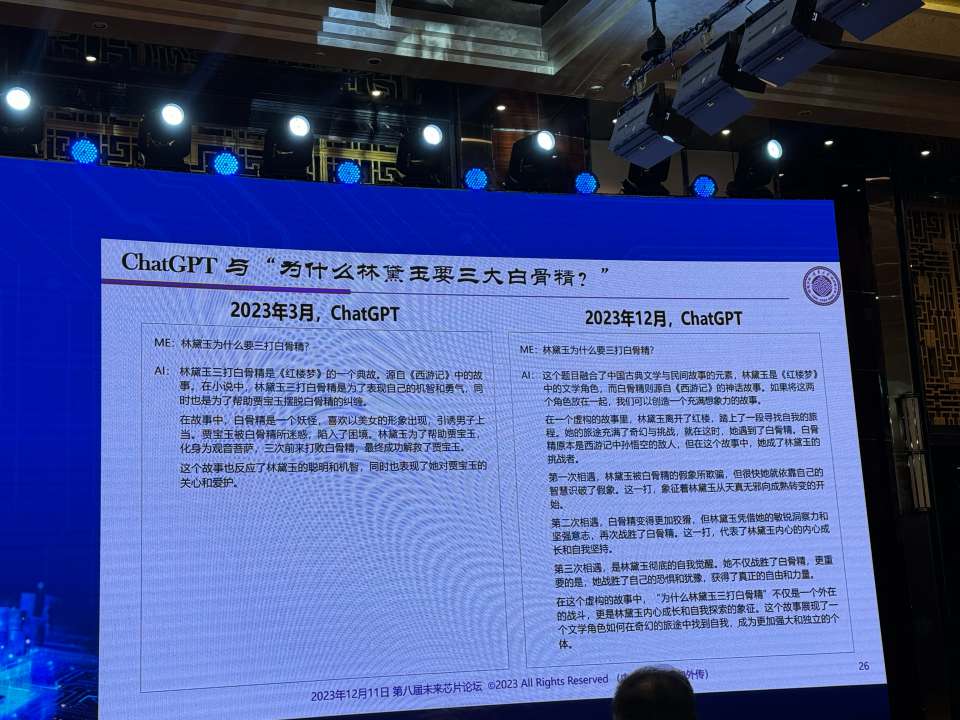

今天业界想象的结构更多在考虑计算机的体系结构,可能需要去探索新的技术实现。但并不是要想入非非,我们做不到一个生物的器件,更多要想到是一个硅基的半导体材料,能够支持海量的输入和海量输出,可能具备基础加权和激活函数运算功能,采用存算一体、有超低延时、超低功耗、极低成本,还可以采用现行CMOS工艺生产制造,未来还可以实现三维集成。这是现在必须考虑的问题,如果我们能够突破这样人工智能的新技术,也许就打开了一条新路。 大模型对芯片的发展是否有决定性影响? 魏少军也在思考,大模型对芯片来说是不是不可或缺,或者大模型对芯片是不是会出现负面影响。他做了一个实验,在Chat GPT上多次询问“为什么林黛玉要三打白骨精”。Chat GPT 4和Chat GPT 3给出的答案完全不一样。Chat GPT 4不是胡说八道,而是给出了一个更合乎逻辑的故事。

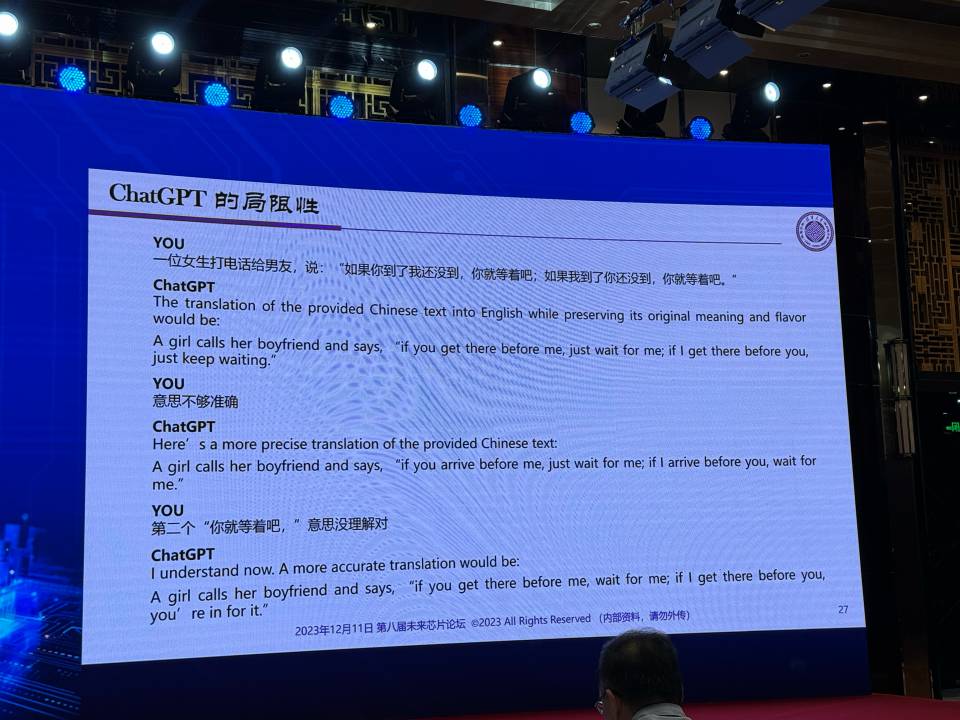

但是,ChatGPT是接受了大量数据训练以后,开始增长能力,也就是说它本身的创造能力非常有限。人之所以认为Chat GPT有很多新奇的想法,是因为集合了一批人的智慧。其实Chat GPT没有创造力,更多的还是通过数据的训练。在和其对话翻译中,它的逻辑关系并不对,实际上Chat GPT并没有想象的聪明。

回过头看,大模型对芯片设计有帮助吗?很多人认为EDA行业是最好利用大模型设计。魏少军表示,对于EDA行业有两个部分可以利用大模型,一个是EDA工具,一个是设计服务,也就是大模型和一定工具结合产生结果,如果是在一般的情况下设计,想要完成太难了。因此,对于这个问题,魏少军表示,大模型对芯片设计肯定有帮助,但是帮助多大,值得去思考。

三维集成电路技术的发展方向在哪?

三维集成电路最近慢慢开始热起来,摩尔定律一直在发展,而且发展的过程中密度越来越高。现在5nm工艺可以在一个平方毫米上集成大概1.1亿只晶体管,也就是2800个逻辑门。我们的集成能力已经大于能够实现的芯片了。

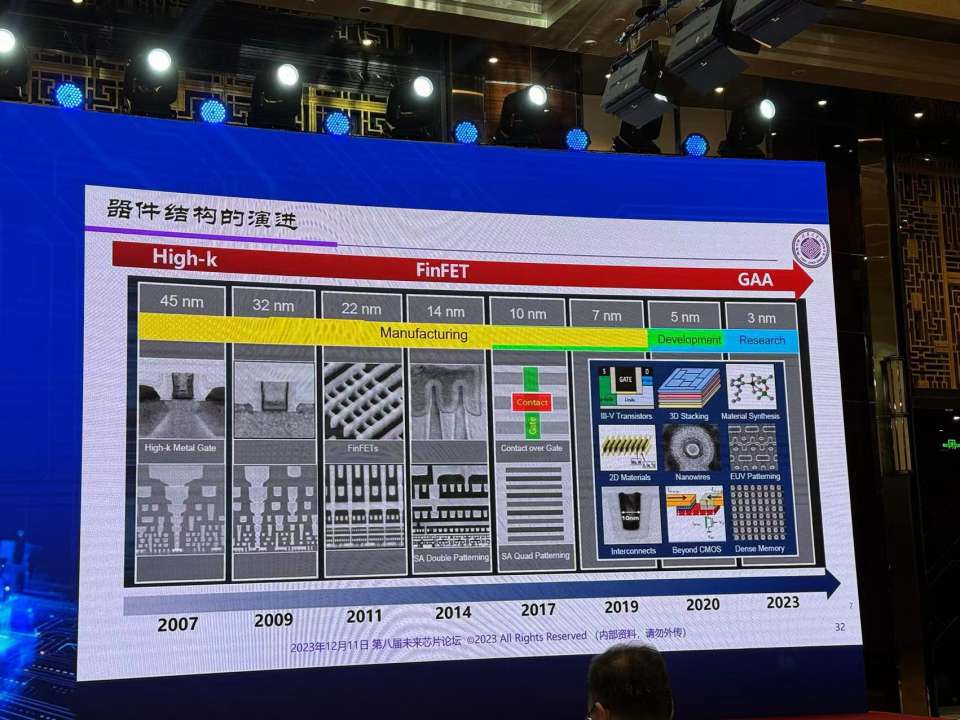

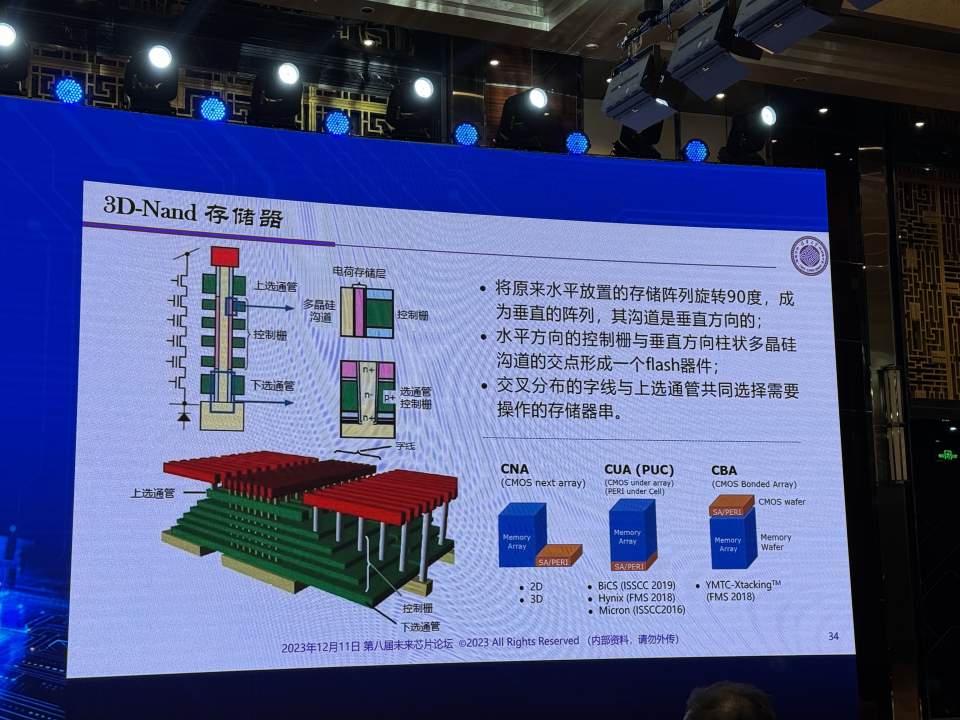

基本器件在不断地向前演进,从45nm、32nm到5nm、3nm,从Hight-K现在走到FinFET,FinFET可以用到7nm,到了3nm工艺变为了GAA。GAA的寿命很短,可以用一代或者两代,继续往前走能否进步,没人知道。虽然目前提出了二维器件、分子器件,但这是否具有可行性以及成本能否坚持还是一个问题。 目前也有提出使用Chiplet、3D封装。某种意义上来说,这两种方式都是更广义的集成,不是在单芯片上的传统集成电路集成。魏少军表示,从更长远来看这种方式是没有问题,甚至会带来更重要的优势,比如成本降低。可以不需要全部使用最先进的工艺,研发的时间、进入市场的时间都会更短。 发展到3nm之后,也可以考虑让晶体管竖着放,变成vertical的一种增长。现在3D NAND已经做到了这点,长江存储利用堆叠技术已经把3D NAND做得很高。

反过来,如果能形成某一种新的融合、新的集成,解决的不仅仅是一个计算与存储的问题,还能够实现三维集成电路的发展。 总而言之,计算无处不在。高性能计算是未来发展的战略高地,也是大国竞争的焦点。今天的计算架构和集成电路技术已经难以支撑高性能计算走向Zetta量级,急需通过架构创新寻求突破。 智能化是大势所趋,人工智能的发展有赖于芯片技术的进步。今天的芯片技术已经无法满足人工智能技术高速发展的需求,急需从基本器件入手,寻找突破点。 大模型的到来开阔了人们的思路,也给出了一些新颖的发展方向。不少人对大模型辅助芯片设计抱有强烈的期望。我们今天尚无法判断大模型对芯片设计的具体帮助,但可以从大模型的基本原理来作些判断,这样会比较客观冷静地看待大模型在集成电路芯片设计中的作用。 集成电路的精髓在于“集成”。在摩尔定发展的大背景下,是时候开始探索三维集成的路径和方法了。 本文依据第八届未来芯片论坛清华大学教授魏少军演讲整理

推荐

-

VCSEL芯片和光学解决方案提供商瑞识科技完成近亿元B1轮融资

VCSEL芯片和光学解决方案提供商瑞识科技完成近亿元B1轮融资

2023-07-03

-

一文带你搞懂开关电源电路

一文带你搞懂开关电源电路

2024-11-02

-

基于脱硝系统改造的自动化优化分析

基于脱硝系统改造的自动化优化分析

2025-02-20

-

阿诗特能源L1000液冷新品震撼上市,卓越性能,引领未来!

阿诗特能源L1000液冷新品震撼上市,卓越性能,引领未来!

2024-06-15

-

博世与芯驰科技全面深化战略合作 围绕车用半导体核心技术

博世与芯驰科技全面深化战略合作 围绕车用半导体核心技术

2025-04-10

-

PLL锁相环:工作原理简述,高效同步控制的核心技术。

PLL锁相环:工作原理简述,高效同步控制的核心技术。

2024-04-07

-

中科曙光助力北京航天总医院打造24小时在线的AI医疗助手

中科曙光助力北京航天总医院打造24小时在线的AI医疗助手

2025-04-10

-

国产替代奋进高端,创新引领,开启替代新篇章。

国产替代奋进高端,创新引领,开启替代新篇章。

2024-04-07

-

模拟芯片与数字芯片各有独特优势,各具魅力,吸引你的目光。

模拟芯片与数字芯片各有独特优势,各具魅力,吸引你的目光。

2024-03-06

-

本征半导体,基础材料之选,了解它,掌握电子世界的关键!

本征半导体,基础材料之选,了解它,掌握电子世界的关键!

2024-04-07

最近更新

-

基于SiWG917Y的无电池Wi 6传感器

基于SiWG917Y的无电池Wi 6传感器

2025-04-19

-

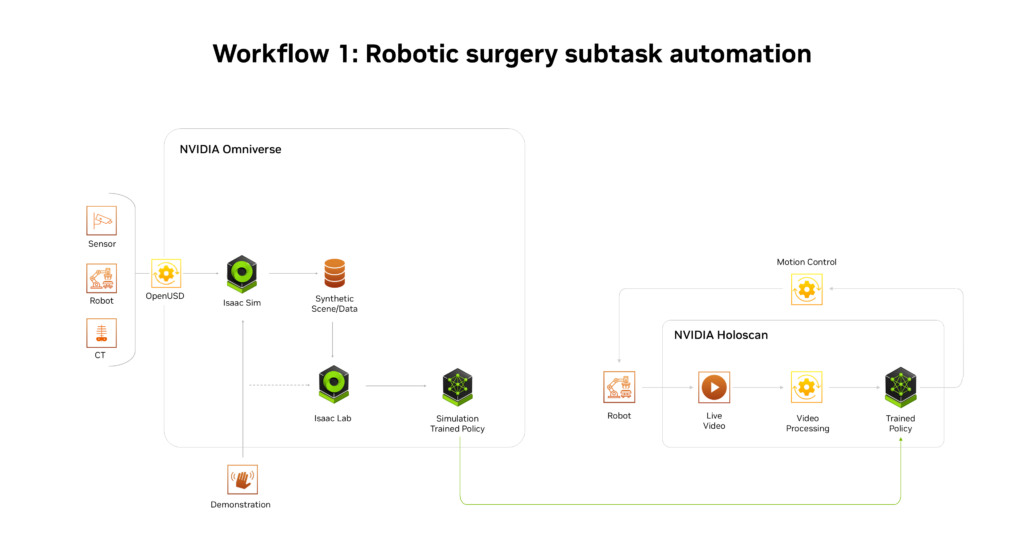

NVIDIA推出AI医疗健康机器人开发平台

NVIDIA推出AI医疗健康机器人开发平台

2025-04-19

-

施耐德电气发布数据中心高密度AI集群部署解决方案

施耐德电气发布数据中心高密度AI集群部署解决方案

2025-04-19

-

航裕电源亮相2025慕尼黑上海电子展

航裕电源亮相2025慕尼黑上海电子展

2025-04-19

-

RECOM RACPRO1系列荣获2025年红点产品设计奖

RECOM RACPRO1系列荣获2025年红点产品设计奖

2025-04-19

-

广汽昊铂首家直营交付中心开业

广汽昊铂首家直营交付中心开业

2025-04-19

-

季丰成都实验室开启芯片微加工新篇章

季丰成都实验室开启芯片微加工新篇章

2025-04-19

-

航裕电源亮相2025俄罗斯国际电子元器件展

航裕电源亮相2025俄罗斯国际电子元器件展

2025-04-19

-

施耐德电气新型电力系统创新中心正式启用

施耐德电气新型电力系统创新中心正式启用

2025-04-19

-

格陆博科技2025上海车展亮点前瞻

格陆博科技2025上海车展亮点前瞻

2025-04-19