是时候给大模型造个身体了。

近期,奥比中光研发团队结合机械臂与大模型,利用语音、语言、视觉-语言大模型,辅以Orbbec Gemini 2系列深度相机的数据输入,打造出一个能够理解、执行语音任务的机械臂。

该项目以斯坦福大学李飞飞教授团队打造的机器人智能体为基础,通过解决泛化、观测、控制等一系列工程化难题,将基于多模态大模型的机械臂从仿真环境落地到现实世界,拓展智能机械臂应用潜能。

融合多种大模型能力,让机械臂理解、执行语音指令,去年以来,各类大模型的涌现引发了机器人产业新一轮发展浪潮。尽管“大模型+机器人”还处于早期技术探索阶段,但随着二者深入融合,机器人有望具备更智能的“大脑”,配合更强大的“眼睛”与“身体”,实现向具身智能的进化。

奥比中光最新打造的大模型机械臂,可以通过语音Prompts作为输入,利用多种大模型的理解能力和视觉感知能力,生成空间语义信息,让机械臂理解、执行动作。

首先,机械臂可借助语音大模型,识别任务下发者的语音指令;同时,通过两台Orbbec Gemini 2双目结构光相机,获取高质量环境RGB和Depth数据;再利用SAM、CLIP等视觉-语言大模型,理解场景信息,并进行实时碰撞检测,最终执行任务。

基于这一原理,奥比中光可以让机械臂完成一系列指令,比如>

请记住当前的状态,把红色的方块放到黄色的框中,把绿色的方块放到白色的框里面,把蓝色的方块逆时针旋转30°,将蓝色方块朝着绿色方块的方向移动10cm,把蓝色方块放到绿色的方块上面,请恢复最开始的状态,请把所有的方块放到黄色的框中,目前,该项目在1.0阶段打通了多模态大模型在机械臂上的应用部署baseline。奥比中光正在进一步优化多模态指令理解、多传感器融合感知、机械臂轨迹规划控制、末端抓取控制等方面,未来将推出大模型机器人控制系统,让机器人更加智能、灵活,适应更加复杂的操作场景。

克服泛化、观测、控制难题,从仿真变为现实,目前,国内外众多针对机器人智能体的研究多在仿真环境中完成。而从虚拟仿真到真实世界,还需要克服一系列工程化落地难题。比如,在仿真环境中,相机基于理想的成像模型,可以不受成像畸变、环境光照等影响,这就对智能体在真实场景中的泛化能力提出了挑战。

奥比中光的研发团队基于预训练的多模态机械臂模型,克服了泛化、观测、控制等一系列落地难题>

为实现快速准确的语音输入与理解,引入语音预训练大模型,使得机械臂灵敏响应语音指令。

为确保机械臂在真实世界中具备足够的泛化能力,采用视觉-语言大模型,使机械臂理解适应复杂场景,在多样化的环境中稳健执行任务。

为处理预训练模型的理想相机成像问题,设计全新标定方案,优化相机自动曝光策略,解决受环境光、成像畸变、透视形变等因素带来的挑战,使机械臂拥有更强的鲁棒性。

为提高机械臂在复杂环境中的安全性,引入深度相机碰撞检测和抓取修正,优化机械臂控制,提高机械臂抓取场景的性能、精度和适应性。

基于关键技术的引入与创新,奥比中光成功地克服了多模态机械臂在多个交叉领域的难题,打通工程化应用落地的“最后一公里”。

在机器人视觉领域,奥比中光拥有超过8年的行业落地经验,服务超过100家机器人产业企业。通过多年合作,奥比中光在机器人3D传感器、激光雷达、模型算法等方面积累了丰富的经验,助力机器人客户快速实现创新应用开发与量产制造。

布局多模态视觉大模型,升维机器人应用潜力,融合多种大模型能力的机械臂,可以应用在哪些场景?,随着机器人的“眼睛”、“大脑”、“身体”不断发展进化,智能机器人及机械臂有望在工业制造、柔性物流、商用服务等场景中率先落地。

例如,在自动化工厂场景,基于多模态大模型的机器臂可以结合无人小车,进行智能分拣、搬运;在家用服务机器人场景,人们可以通过简单的自然语言指令,让机器人帮忙倒水、取快递。

当前,面向机器人产业,奥比中光可提供单目结构光、双目结构光、iToF、激光雷达、dToF等全技术路线3D视觉传感器,并提供多传感器融合支持。同时,针对AI大模型、具身智能机器人等科技发展趋势,奥比中光正在致力于搭建机器人及AI视觉中台,通过多模态视觉大模型及智能算法的研发,结合机器人视觉传感器,将形成自主移动定位导航和避障的完整产品方案,为全产业下游客户提供全方位能力平台及系列化产品方案,迎接智能机器人时代。

推荐

-

国民技术发布国内首款Arm® Cortex®M7+M4双核异构MCU 面向具身智能机器人

国民技术发布国内首款Arm® Cortex®M7+M4双核异构MCU 面向具身智能机器人

2025-04-19

-

黄仁勋中国行的背后,AI芯片暗战与英伟达生存博弈

黄仁勋中国行的背后,AI芯片暗战与英伟达生存博弈

2025-04-19

-

北京机器人传感器公司金钢科技数千万元Pre

北京机器人传感器公司金钢科技数千万元Pre

2025-04-19

-

光子 AI 处理器的核心原理及突破性进展

光子 AI 处理器的核心原理及突破性进展

2025-04-19

-

解决续航、网速痛点,Wi 7 PA杀入AI眼镜

解决续航、网速痛点,Wi 7 PA杀入AI眼镜

2025-04-19

-

15万车型也能有车规SiC!2025年慕展6家厂商新品亮点大揭秘

15万车型也能有车规SiC!2025年慕展6家厂商新品亮点大揭秘

2025-04-19

-

VCSEL芯片和光学解决方案提供商瑞识科技完成近亿元B1轮融资

VCSEL芯片和光学解决方案提供商瑞识科技完成近亿元B1轮融资

2023-07-03

-

一文带你搞懂开关电源电路

一文带你搞懂开关电源电路

2024-11-02

-

算法进化论:从参数剪枝到意识解码的 AI 革命

算法进化论:从参数剪枝到意识解码的 AI 革命

2025-04-19

-

基于脱硝系统改造的自动化优化分析

基于脱硝系统改造的自动化优化分析

2025-02-20

最近更新

-

研华AgentBuilder智能体平台推动智能制造发展

研华AgentBuilder智能体平台推动智能制造发展

2025-04-23

-

新能源汽车热管理系统,从电容、传感器到功率器件的全面创新

新能源汽车热管理系统,从电容、传感器到功率器件的全面创新

2025-04-23

-

奥托立夫助力长城魏牌全新高山重塑家庭出行安全范式

奥托立夫助力长城魏牌全新高山重塑家庭出行安全范式

2025-04-23

-

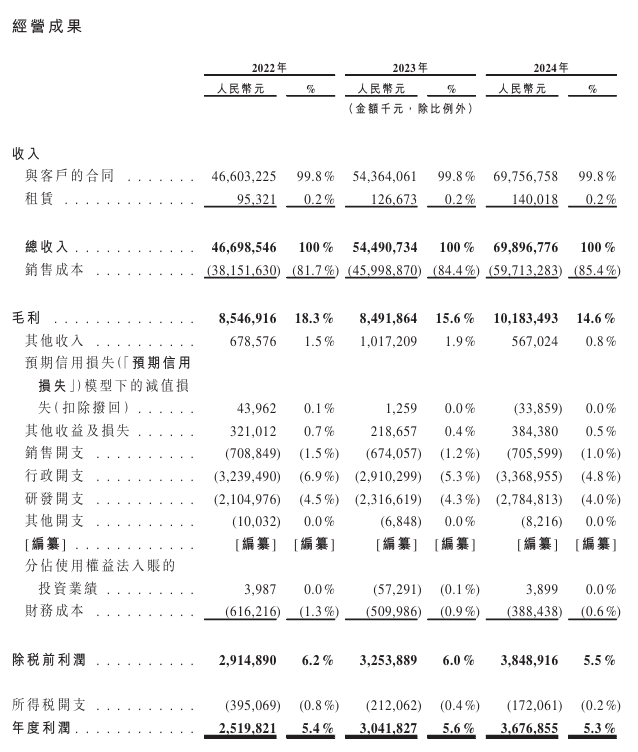

蓝思科技港股IPO破局:人形机器人+AI设备拓新赛道减"苹果依赖"

蓝思科技港股IPO破局:人形机器人+AI设备拓新赛道减"苹果依赖"

2025-04-23

-

上汽通用汽车别克品牌与Momenta达成战略合作

上汽通用汽车别克品牌与Momenta达成战略合作

2025-04-23

-

IBM发布2025年X

IBM发布2025年X

2025-04-23

-

比亚迪五款新能源车型登陆塞舌尔市场

比亚迪五款新能源车型登陆塞舌尔市场

2025-04-23

-

仰望汽车累计销量突破10000台

仰望汽车累计销量突破10000台

2025-04-23

-

中车时代电气出席2025年全路ATP车载设备技术交流会

中车时代电气出席2025年全路ATP车载设备技术交流会

2025-04-23

-

比亚迪海狮07EV荣获EURO NCAP和A

比亚迪海狮07EV荣获EURO NCAP和A

2025-04-23