作者:一号

GPT-4最强的对手出现了。

北京时间12月7日凌晨,谷歌CEO“劈柴”突然发布重磅AI杀手锏——Gemini。就在前几天,还有消息说Gemini要推迟一个月才上线,结果现在这么突然地发布,着实让AI圈料不到。以谷歌以往的实力,不用想,这又是AI界的一个“不眠之夜”。

在去年ChatGPT发布不到两周,谷歌就拉响了「警报」来应战,好不容易搞出来的Bard,在首次亮相的时候却出现了失误,让谷歌市值一夜蒸发了1000亿美元。

而且,GPT还是基于Transformer开发的,而这个Transformer模型最早还是谷歌提出来,要想谷歌心甘情愿地服输,可不是那么容易。

果然,这一年的时间里,关于Gemini的消息就层出不穷,有的说谷歌大脑和DeepMind部门合并,几乎耗尽谷歌内部算力资源,就是为了背水一战,和OpenAI决战。

不过前段时间,OpenAI的发布会把AI界炸了一圈,还上演了一出“宫斗剧”,甚至还传出让人浮想联翩的Q*,谷歌都没一点新消息,差点就让人以为AI圈的王者已定。

就在一个月之前,英伟达科学家Jim Fan就曾说过,“人们对谷歌Gemini的期望高得离谱!谷歌要想重夺当年AlphaGo的辉煌,Gemini不仅要100%达到GPT-4的能力,还要在成本或者速度上比GPT-4更好。”,

生来就是全才

还好,从Gemini公布的演示视频来看,它没让人失望。

“Gemini,从第一天起就是多模态大模型——跨越文本、图像、视频、音频和代码的无缝推理。”这是谷歌官网上,介绍Gemini的第一句话。

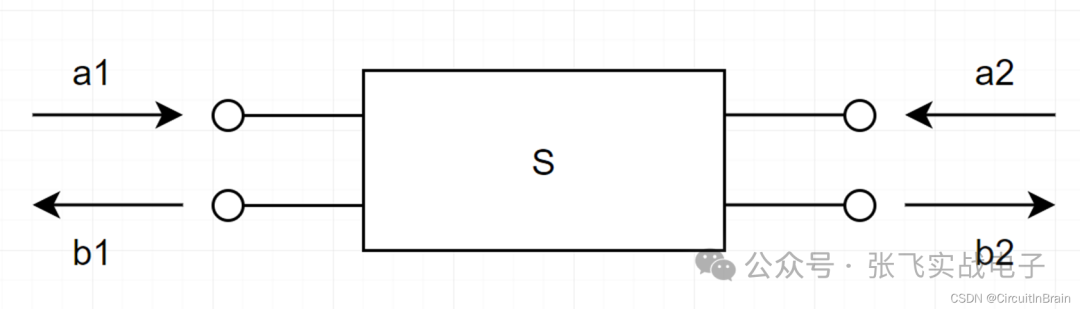

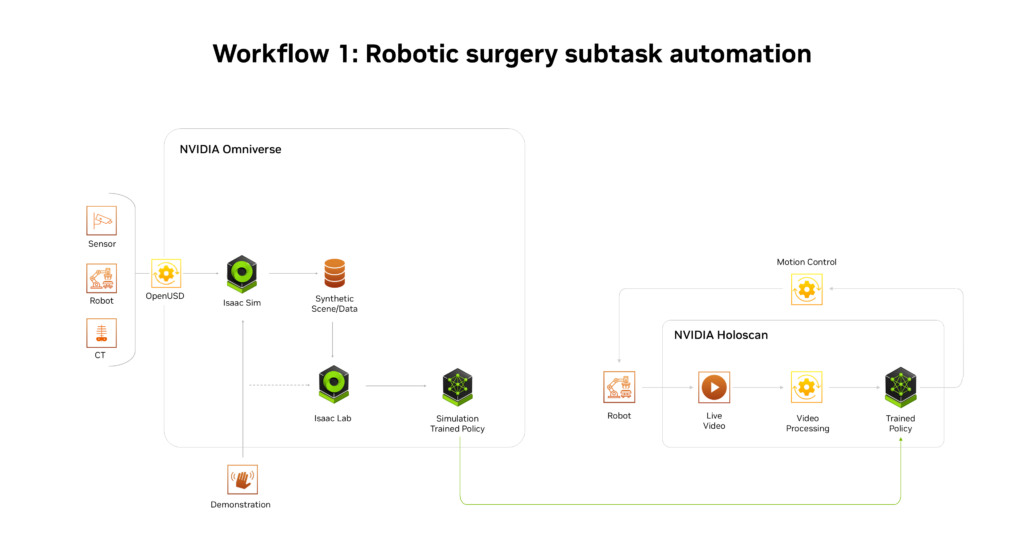

与ChatGPT通过升级迭代,逐步加上视觉、音频等多模态能力,形成“合体金刚”的路径不同,Gemini生来就是一位全才。它从第一天起就被设计成原生多模态结构,文本、图像、音视频能力从最开始就一起训练,从这一点上来看,Gemini的学习更像人类。这就意味着,Gemini可以无缝调动多模态能力,抽象和理解、操作和组合不同类型的信息。

举个例子,如果你同时上传一张图片给ChatGPT和Gemini,那么ChatGPT的处理将会是这样的,先借助GPT-4V认出来图里是什么,然后转成文本交给GPT去进行语义理解,然后再作回答;而Gemini则可以基于图像直接进行理解并回应,不用进行不同模型之间的调动。因此,在实操过程中,Gemini可以减少信息的丢失,回应也可以更加迅速和丝滑。

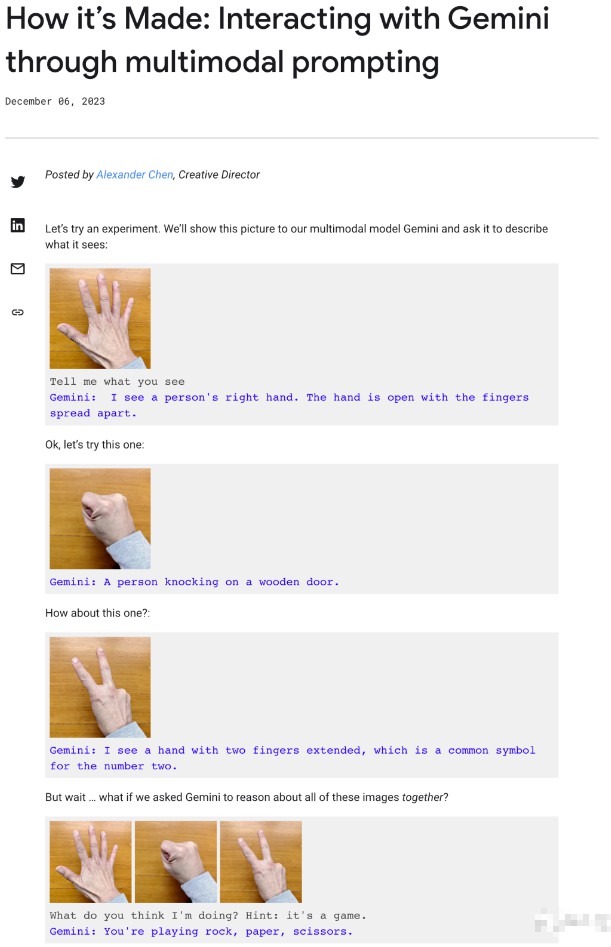

这从谷歌给到的演示视频中便可以看出>

演示者一边画画,Gemini就可以一边辨认,并且用自然、流利的语音和演示者对话,在演示者拿出蓝色的玩具鸭实物后,它还会幽默的回应:“看起来蓝色的鸭子比我想象中更常见。”,很显然,这样的体验更接近漫威中的“贾维斯”——一个高级人工智能,能与人类自如地进行交互。

而这样的体验,离不开Gemini的原生多模态架构。

Gemini VS GPT-4

除了拥有令人惊叹的原生多模态能力,在性能上,Gemini也是相当强悍。

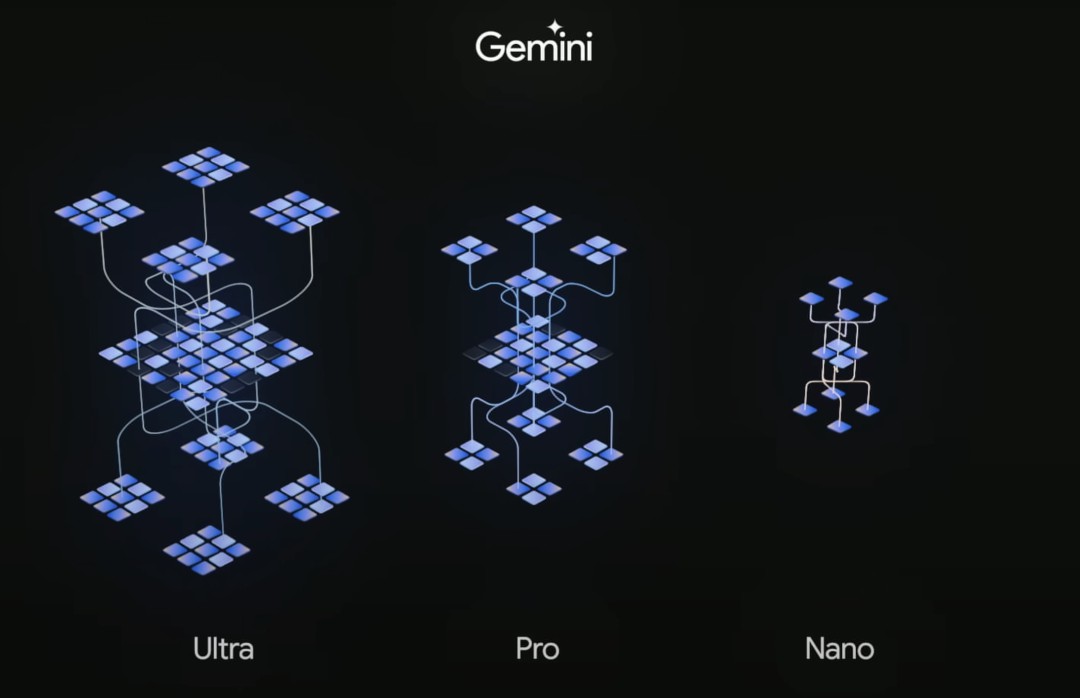

按照尺寸的不同,Gemini共有“中杯”、“大杯”还有“超大杯”三种,即Ultra、Pro和Nano三个不同的版本。它们在性能和适配任务上的侧重点各有不同。

·Gemini Ultra —规模最大且功能最强大的模型,适用于高度复杂的任务,预计2024年初推出。

·Gemini Pro — 适用于各种任务的最佳模型,已经被用在了谷歌聊天机器人Bard的升级版上。

·Gemini Nano — 可以在端端侧设备上运行的高效模型,已经可以跑在谷歌Pixel 8 Pro手机上了。

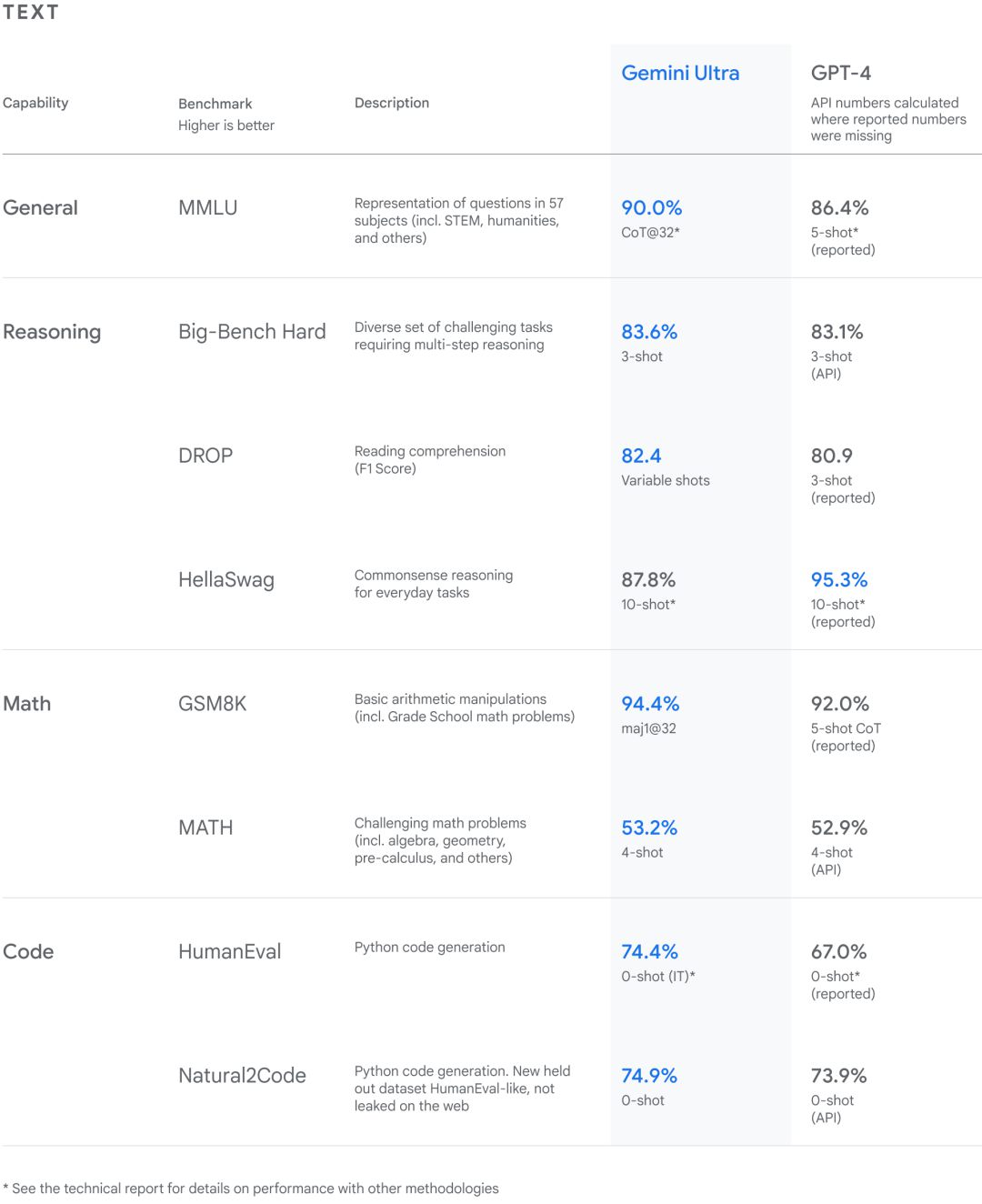

根据谷歌给到的资料,从自然图像、音频和视频理解,再到数学推理,Gemini Ultra的性能在32个常见的大语言模型研究和开发的学术基准测试中,拿下了30个SOTA。

其中,它在通用、推理、数学和编程等大方向的成绩如下>

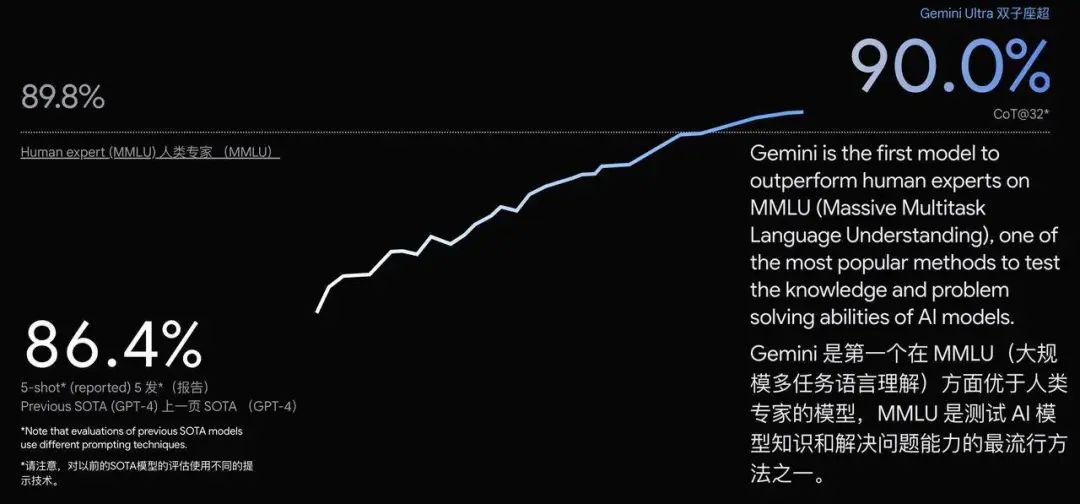

更让人惊奇的是,在MMLU任务上,Gemini Ultra的得分达到了90.0%,超越了人类专家89.8%的成绩,首次达到了超越人类专家水平。

MMLU测试包括数学、物理、历史、法律、医学等57个学科,主要是用来考察大语言模型世界知识和解决问题的能力,而在这些学科中的每一个,Gemini都达到了甚至超过了行业专家的水准。

在图像基准测试中,Gemini Ultra在不使用OCR来提取图像文本进行下一步处理的情况下,表现优于GPT-4V。

各种测试都表明,Gemini在多模态处理上表现出了强大的能力,并且在更复杂的推理上也有很大的潜力。

实际能力被质疑

然而,在模型发布后不久,就有人在谷歌给到的60页技术报告中发现了一些“小技巧”。

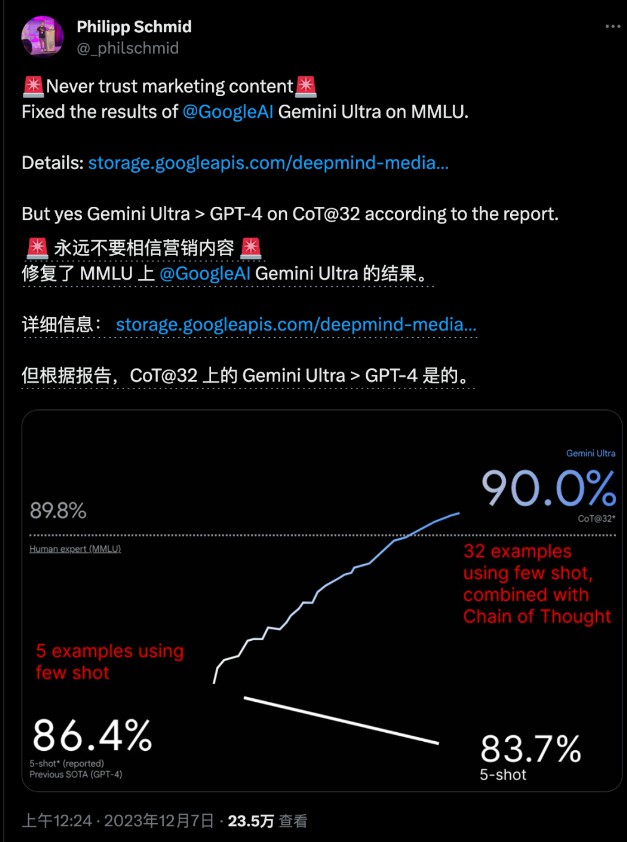

在MMLU测试中,Gemini的结果下面用灰色小字标注着CoT@32,这表示,这个结果是使用了思维练提示技巧,尝试了32次后选出来的最好结果,而对比GPT-4,则是无提示词技巧,只尝试了5次的结果,这测试结果,变量确实控制得不是很好。

而且在显示超越人类专家的示意图里,比例尺上也有问题,让人以为超越了人类专家很多,但实际上并没有相差多少。

HuggingFace的技术主管Philipp Schmind“修复”了这张图,表示实际上应该是这样>

并且,在谷歌给到的一篇解释多模态交互过程的博客中,似乎表明了演示视频里,Gemini实时互动并不是真的,而是使用了静态图片,通过多段提示词拼凑,最后再剪辑视频,才达到了演示视频里的效果。

不管谷歌是不是有意使用“障眼法”,Gemini的发布无疑给看似稳定的AI界带来了一些“动荡”。

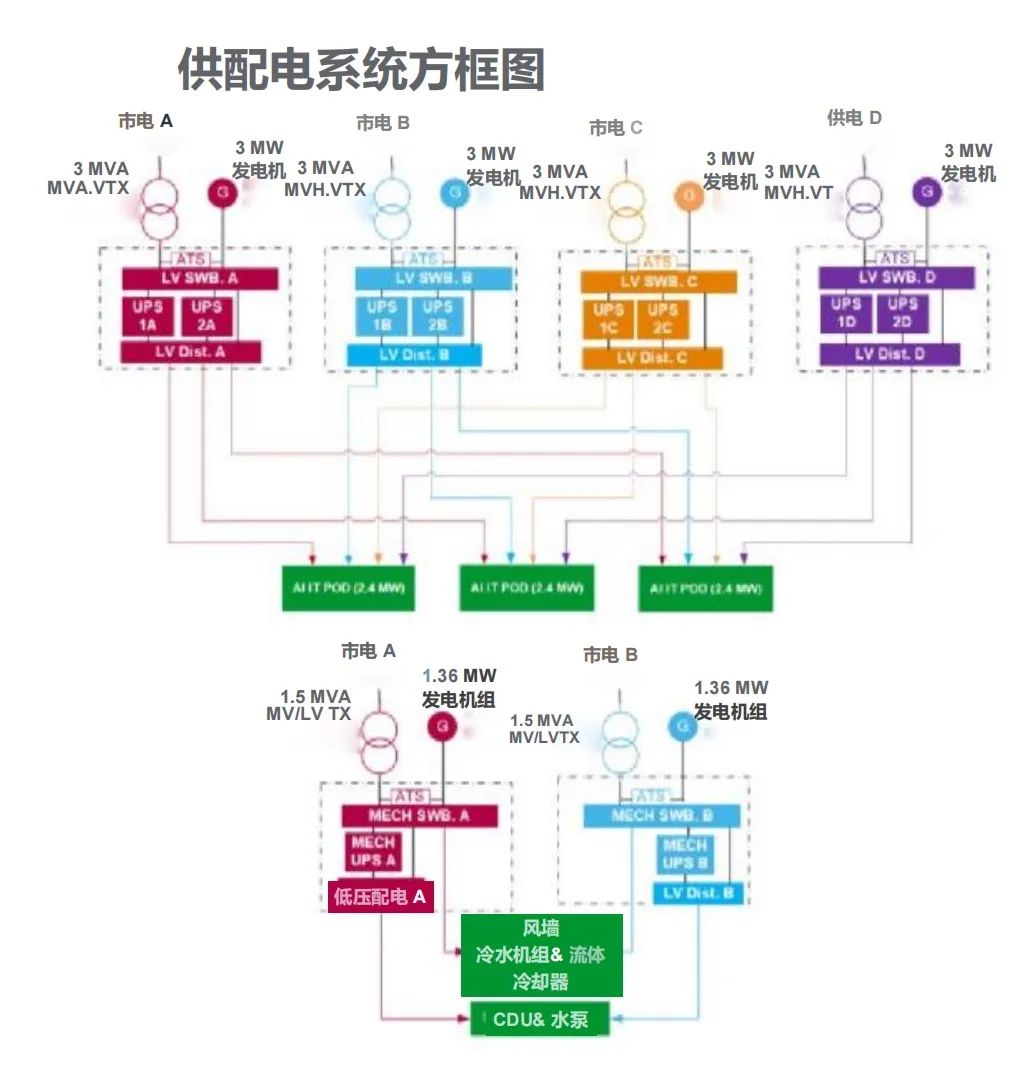

并且,谷歌还宣布推出了迄今为止最强大、最高效、最可扩展的TPU系统:Cloud TPU v5p,Gemini正式在此基础上训练的,这意味着谷歌将有能力拜托英伟达的算力限制,也算给了AI芯片市场带来了一些变化。

大模型的多模态探索

随着ChatGPT通过升级迭代,拥有了多模态能力,以及Gemini所展现出来的原生多模态能力,我们可以清晰地感受到,AI大模型浪潮已经进入了一个全新的阶段,即从大语言模型转向多模态模型。后者将更符合人类和世界交互最自然的方式:用眼睛看,用耳朵听,用嘴巴说,用文字记录与决策。

多模态领域的技术探索,与互联网媒介形式的变化也十分吻合,即从文字媒体,再到,音视频媒体。如今,随着抖音以及TikTok等短视频平台的兴起,视频已经成为了我们这个信息时代的主流。

根据思科的年度互联网报告,视频已经占据了互联网超过80%的流量。

很明显,如果一个AI大模型不具备识别图像以及音视频的能力,那么其训练数据将会跟不上信息迭代的速度,其能力也将大打折扣。

现如今,在多模态模型道路的探索上,除了GPT,Gemini也加入了进来,不知道未来Meta的Llama还有马斯克的Grok等等,是否也将加入角逐?

审核编辑 黄宇