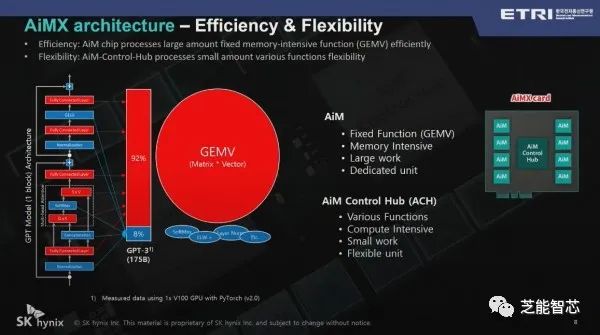

SK海力士预测在人工智能领域,存储器解决方案的比重将进一步增加,可以通过类似AiMX的解决方案部分替代图形处理单元。在首尔江南区科技会议中心举行的“ETRI Conference 2023”上,SK海力士副社长表示,对于像BERT这样的模型,内存密集型功能仅占约5%,而在GPT2中,内存功能约占45%。在175B GPT3中,内存密集型功能已经达到92%。

内存密集型函数是GEMV,即矩阵和向量相乘的运算,是大型语言模型的核心。“现在LLM的GEMV内存密集比例已达到92%”,并解释说,“92%是通过Accelerator in Memory处理的,其余8%是通过AiM Control处理的Hub。SK海力士计划将AiM控制器改为AiMX专用SoC,而不是FPGA。

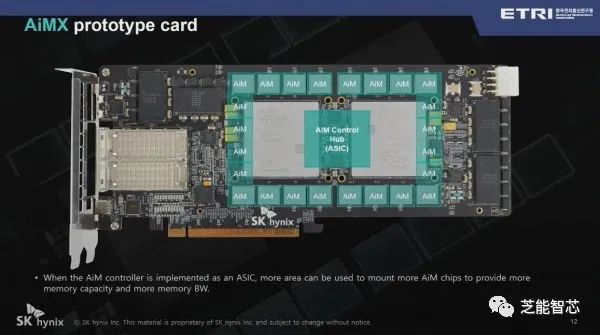

AiMX是SK海力士去年发布的基于内存的加速器,专为内存密集型函数计算进行优化,配备有16个1GB GDDR6-AiM和2个可编程半导体。“设计AiM控制中枢的成本太高,首先使用FPGA创建了一个加速器。当创建自己的片上系统时,将添加更多的GDDR6-AiM,以制造64GB或更大的产品。”,

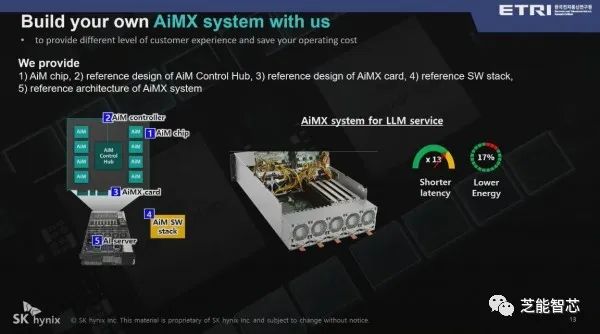

在LLM中,AiMX的延迟比GPU快13倍,功耗降低17%,与GPU相比,LLM具有更优越的性能。“主要供应AiM芯片并提供参考设计来帮助超大规模客户,”并表示SK海力士将支持创建加速器系统。由于公司最大的客户之一是GPU公司,因此在推广AiMX时需要谨慎,以确保其利益与客户的利益部分重叠。

推荐

-

TrendForce集邦咨询: 预估2025年笔电品牌出货成长率将下修至1.4%

TrendForce集邦咨询: 预估2025年笔电品牌出货成长率将下修至1.4%

2025-05-01

-

黄仁勋中国行的背后,AI芯片暗战与英伟达生存博弈

黄仁勋中国行的背后,AI芯片暗战与英伟达生存博弈

2025-04-19

-

国民技术发布国内首款Arm® Cortex®M7+M4双核异构MCU 面向具身智能机器人

国民技术发布国内首款Arm® Cortex®M7+M4双核异构MCU 面向具身智能机器人

2025-04-19

-

北京机器人传感器公司金钢科技数千万元Pre

北京机器人传感器公司金钢科技数千万元Pre

2025-04-19

-

让英特尔再次伟大,新CEO推动18A提前量产,14A已在路上

让英特尔再次伟大,新CEO推动18A提前量产,14A已在路上

2025-05-01

-

光子 AI 处理器的核心原理及突破性进展

光子 AI 处理器的核心原理及突破性进展

2025-04-19

-

晶振在网通应用增光添彩:中国移动实现数字乡村大升级

晶振在网通应用增光添彩:中国移动实现数字乡村大升级

2025-05-01

-

一文解析电磁场与电磁波的区别

一文解析电磁场与电磁波的区别

2025-05-01

-

解决续航、网速痛点,Wi 7 PA杀入AI眼镜

解决续航、网速痛点,Wi 7 PA杀入AI眼镜

2025-04-19

-

15万车型也能有车规SiC!2025年慕展6家厂商新品亮点大揭秘

15万车型也能有车规SiC!2025年慕展6家厂商新品亮点大揭秘

2025-04-19

最近更新

-

芯驰科技与Arteris深化合作

芯驰科技与Arteris深化合作

2025-05-06

-

戴尔PowerEdge R770服务器的性能测试

戴尔PowerEdge R770服务器的性能测试

2025-05-06

-

光庭信息与芯驰科技签署战略合作协议

光庭信息与芯驰科技签署战略合作协议

2025-05-06

-

京东方发布2025年第一季度报告

京东方发布2025年第一季度报告

2025-05-06

-

中科曙光DeepAI深算智能引擎全面支持Qwen3

中科曙光DeepAI深算智能引擎全面支持Qwen3

2025-05-06

-

中微爱芯亮相第21届家电电源与智能控制技术研讨会

中微爱芯亮相第21届家电电源与智能控制技术研讨会

2025-05-06

-

中科曙光亮相第八届数字中国建设峰会

中科曙光亮相第八届数字中国建设峰会

2025-05-06

-

RDK全系赋能!点猫科技与地瓜机器人共建具身智能大中小贯通培养闭环要闻

RDK全系赋能!点猫科技与地瓜机器人共建具身智能大中小贯通培养闭环要闻

2025-05-06

-

魔视智能携手德州仪器亮相2025慕尼黑上海电子展

魔视智能携手德州仪器亮相2025慕尼黑上海电子展

2025-05-06

-

曙光存储亮相2025 IT市场年会

曙光存储亮相2025 IT市场年会

2025-05-06