微软自研AI 芯片传闻未曾停过,在一年一度Microsoft Ignite 2023 大会上,终于发布了用于数据中心的AI 芯片Azure Maia 100 和云端运算处理器Azure Cobalt 100。

Azure Maia 是一款AI 加速器芯片,用于OpenAI 模型、ChatGPT、Bing、GitHub Copilot 等AI 工作负载,Azure Maia 100 则是该系列第一代产品,采取5 纳米制程生产。

Azure Cobalt 为Arm 架构的云端运算处理器,配备128 个运算核心,与目前几代Azure Arm 芯片相比,效能提升40%,为Microsoft Teams、Azure SQL 等服务提供支援,这2 款芯片均由台积电生产,微软已在设计第二代版本。

领导团队开发新芯片的微软AHSI副总裁Rani Borkar 指出,微软已在Bing 和Office 产品测试新款AI 芯片,微软主要AI 合作伙伴、ChatGPT 开发商OpenAI 也以GPT 3.5 Turbo 进行测试。Azure Maia 和Azure Cobalt 预计明年初正式用于微软数据中心,成为Azure 云端运算服务的一部分。

Rani Borkar 接受外媒采访表示,对具规模的微软而言,优化和整合硬件的每个要素可提供最佳运算效能,同时避免供应链瓶颈,Azure Maia 和Azure Cobalt 可为客户提供基础设施新的选择。

自研芯片可获得硬件性能和价格优势,同时避免公司过度依赖任何一家供应商。目前AI 产业高度依赖NVIDIA GPU 因此凸显问题,亚马逊和Google 已有自研芯片的具体成果,亚马逊2015 年收购以色列芯片新创Annapurna Labs,为客户提供云端和AI 芯片的服务,Google 从2018 年起允许客户采用自研芯片TPU,微软急起直追终于跟上脚步。

除此之外,微软称,作为定制芯片的补充,微软正在拓展与芯片供应商的合作伙伴关系,为客户提供基础设施选项。

微软表示,将在微软智能云Azure中添加AMD MI300X加速虚拟机。ND MI300虚拟机将采用AMD最新的GPU——AMD Instinct MI300X,旨在加速AI工作负载的处理,以实现高范围的AI模型训练和生成式推理。

为英伟达H100 Tensor Core GPU打造的全新NC H100 v5虚拟机系列开放预览,将提高大中型AI训练和生成式推理的性能、可靠性和效率。微软称还发布了ND H200 v5虚拟机系列计划,这是一款AI优化虚拟机,配备了即将推出的英伟达H200 Tensor Core GPU。

微软过去曾开发客制化芯片,包括与AMD 合作设计Xbox 处理器,以及为HoloLens 和Xbox Kinect 运动控制器开发专用芯片。随着Azure Maia 和Azure Cobalt 正式发表,微软自研芯片版图更加完整。

推荐

-

VCSEL芯片和光学解决方案提供商瑞识科技完成近亿元B1轮融资

VCSEL芯片和光学解决方案提供商瑞识科技完成近亿元B1轮融资

2023-07-03

-

一文带你搞懂开关电源电路

一文带你搞懂开关电源电路

2024-11-02

-

基于脱硝系统改造的自动化优化分析

基于脱硝系统改造的自动化优化分析

2025-02-20

-

阿诗特能源L1000液冷新品震撼上市,卓越性能,引领未来!

阿诗特能源L1000液冷新品震撼上市,卓越性能,引领未来!

2024-06-15

-

博世与芯驰科技全面深化战略合作 围绕车用半导体核心技术

博世与芯驰科技全面深化战略合作 围绕车用半导体核心技术

2025-04-10

-

PLL锁相环:工作原理简述,高效同步控制的核心技术。

PLL锁相环:工作原理简述,高效同步控制的核心技术。

2024-04-07

-

中科曙光助力北京航天总医院打造24小时在线的AI医疗助手

中科曙光助力北京航天总医院打造24小时在线的AI医疗助手

2025-04-10

-

国产替代奋进高端,创新引领,开启替代新篇章。

国产替代奋进高端,创新引领,开启替代新篇章。

2024-04-07

-

模拟芯片与数字芯片各有独特优势,各具魅力,吸引你的目光。

模拟芯片与数字芯片各有独特优势,各具魅力,吸引你的目光。

2024-03-06

-

本征半导体,基础材料之选,了解它,掌握电子世界的关键!

本征半导体,基础材料之选,了解它,掌握电子世界的关键!

2024-04-07

最近更新

-

基于SiWG917Y的无电池Wi 6传感器

基于SiWG917Y的无电池Wi 6传感器

2025-04-19

-

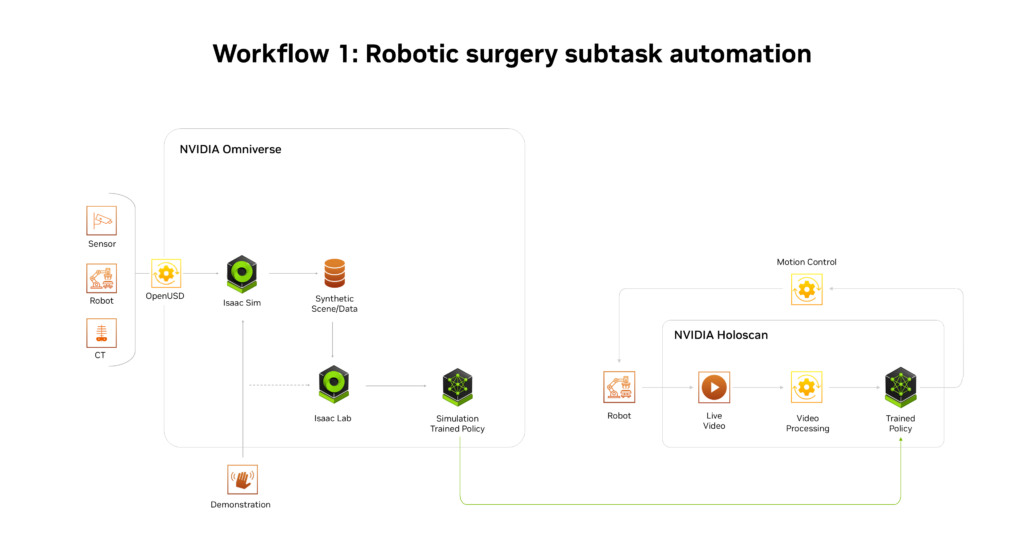

NVIDIA推出AI医疗健康机器人开发平台

NVIDIA推出AI医疗健康机器人开发平台

2025-04-19

-

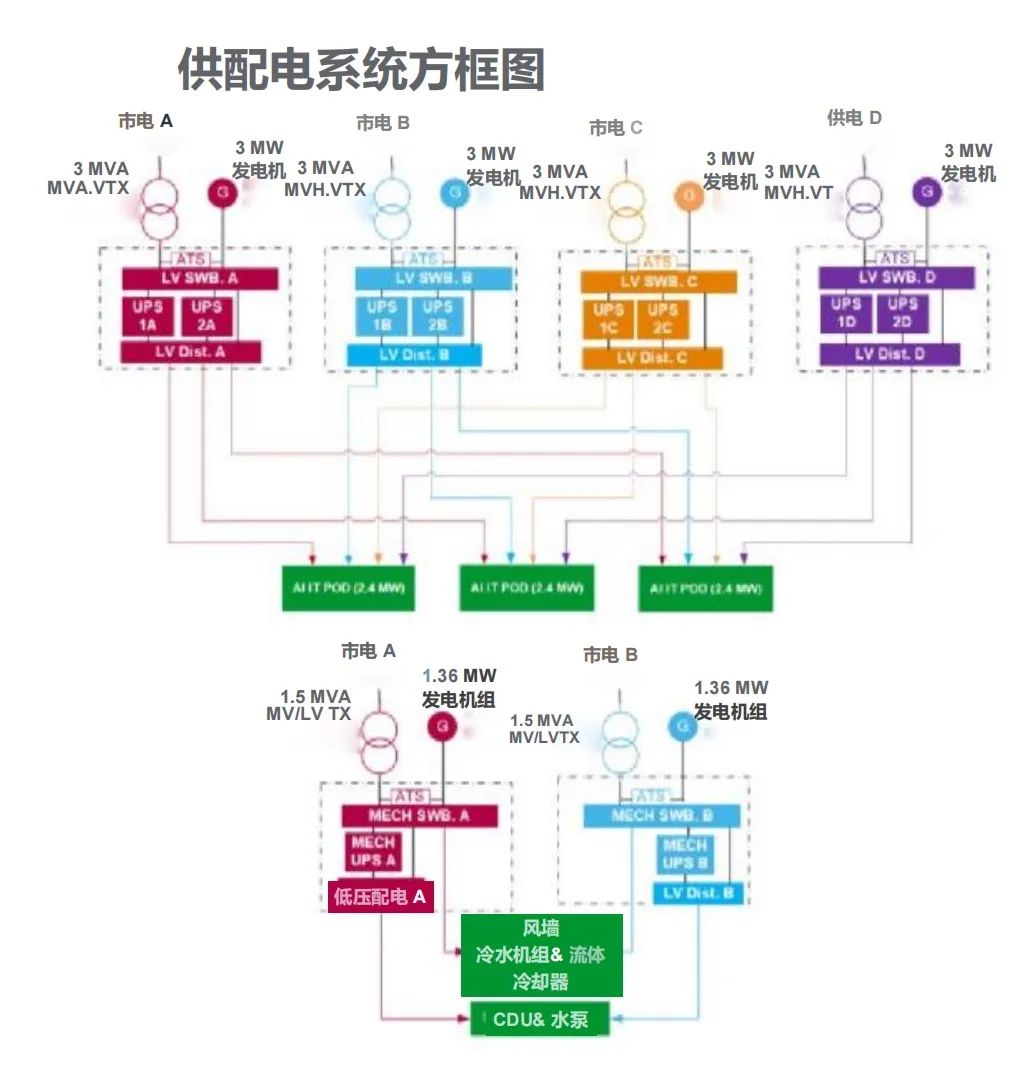

施耐德电气发布数据中心高密度AI集群部署解决方案

施耐德电气发布数据中心高密度AI集群部署解决方案

2025-04-19

-

航裕电源亮相2025慕尼黑上海电子展

航裕电源亮相2025慕尼黑上海电子展

2025-04-19

-

RECOM RACPRO1系列荣获2025年红点产品设计奖

RECOM RACPRO1系列荣获2025年红点产品设计奖

2025-04-19

-

广汽昊铂首家直营交付中心开业

广汽昊铂首家直营交付中心开业

2025-04-19

-

季丰成都实验室开启芯片微加工新篇章

季丰成都实验室开启芯片微加工新篇章

2025-04-19

-

航裕电源亮相2025俄罗斯国际电子元器件展

航裕电源亮相2025俄罗斯国际电子元器件展

2025-04-19

-

施耐德电气新型电力系统创新中心正式启用

施耐德电气新型电力系统创新中心正式启用

2025-04-19

-

格陆博科技2025上海车展亮点前瞻

格陆博科技2025上海车展亮点前瞻

2025-04-19