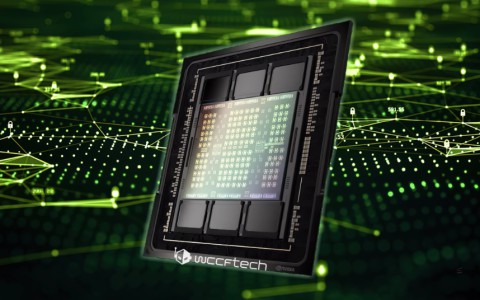

近日,英伟达推出了一款用于人工智能工作的顶级芯片HGX H200。新的GPU升级了需求巨大的H100,内存带宽增加了1.4倍,内存容量增加了1.8倍,提高了其处理密集生成人工智能工作的能力。

在备受瞩目的人工智能领域,英伟达提到,H200将带来进一步的性能飞跃。在Llama 2上的推理速度比H100快了一倍。未来的软件更新预计会给H200带来额外的性能领先优势和改进。

H200将在具有四路和八路配置的英伟达HGX H200服务器主板中提供,并与HGX H100系统的硬件和软件兼容。

大型计算机制造商和云服务提供商预计将于明年第二季度开始使用H200。亚马逊的AWS、Alphabet公司的谷歌云、微软Azure和甲骨文的云基础设施,都承诺从明年开始使用这款新芯片。

英伟达高性能计算产品副总裁Ian Buck在近日的视频演示中表示:“更快、更广泛的HBM内存集成有助于提高计算需求任务的性能,包括生成人工智能模型和[高性能计算]应用程序,同时优化GPU利用率和效率。”,H200还与已经支持H100的相同系统兼容。英伟达表示,云提供商在将H200添加到混合中时不需要做出任何更改。亚马逊、谷歌、微软和甲骨文的云计算部门将在明年率先提供新的GPU。

一旦推出,新芯片肯定会很贵。英伟达没有列出它们的价格,但据美国消费者新闻与商业频道报道,上一代H100的售价估计在25000至40000美元之间,其中数千台需要在最高水平上运行。并且,价格由英伟达的合作伙伴决定。

伴随着人工智能的火爆,英伟达的高端GPU需求量极大。这也令其他芯片制造商瞄准这一利润丰厚的市场,加快推出高品质的AI芯片,整个AI芯片市场竞争相当激烈。英伟达此举旨在巩固其在AI计算市场的主导地位。

推荐

-

VCSEL芯片和光学解决方案提供商瑞识科技完成近亿元B1轮融资

VCSEL芯片和光学解决方案提供商瑞识科技完成近亿元B1轮融资

2023-07-03

-

一文带你搞懂开关电源电路

一文带你搞懂开关电源电路

2024-11-02

-

基于脱硝系统改造的自动化优化分析

基于脱硝系统改造的自动化优化分析

2025-02-20

-

阿诗特能源L1000液冷新品震撼上市,卓越性能,引领未来!

阿诗特能源L1000液冷新品震撼上市,卓越性能,引领未来!

2024-06-15

-

博世与芯驰科技全面深化战略合作 围绕车用半导体核心技术

博世与芯驰科技全面深化战略合作 围绕车用半导体核心技术

2025-04-10

-

PLL锁相环:工作原理简述,高效同步控制的核心技术。

PLL锁相环:工作原理简述,高效同步控制的核心技术。

2024-04-07

-

中科曙光助力北京航天总医院打造24小时在线的AI医疗助手

中科曙光助力北京航天总医院打造24小时在线的AI医疗助手

2025-04-10

-

国产替代奋进高端,创新引领,开启替代新篇章。

国产替代奋进高端,创新引领,开启替代新篇章。

2024-04-07

-

模拟芯片与数字芯片各有独特优势,各具魅力,吸引你的目光。

模拟芯片与数字芯片各有独特优势,各具魅力,吸引你的目光。

2024-03-06

-

本征半导体,基础材料之选,了解它,掌握电子世界的关键!

本征半导体,基础材料之选,了解它,掌握电子世界的关键!

2024-04-07

最近更新

-

基于SiWG917Y的无电池Wi 6传感器

基于SiWG917Y的无电池Wi 6传感器

2025-04-19

-

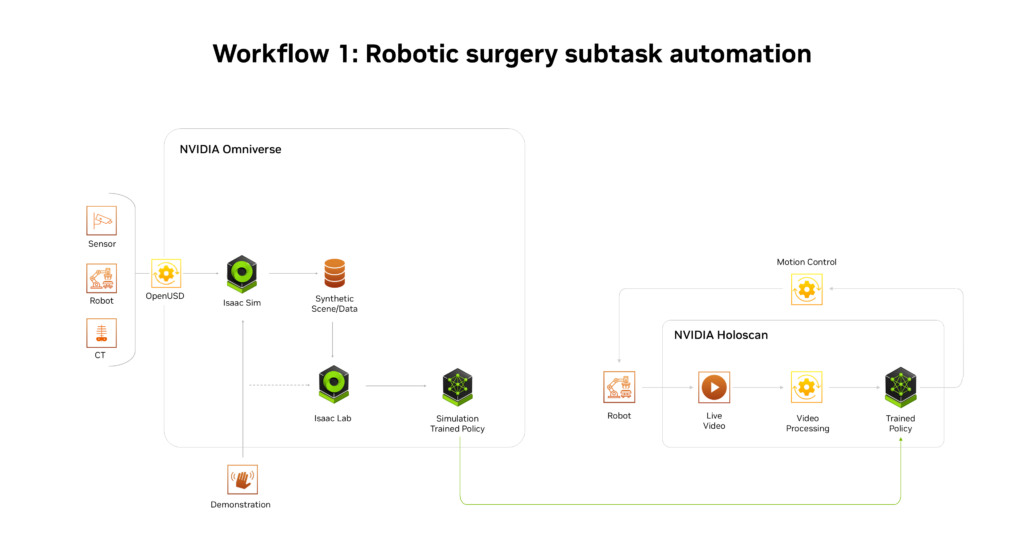

NVIDIA推出AI医疗健康机器人开发平台

NVIDIA推出AI医疗健康机器人开发平台

2025-04-19

-

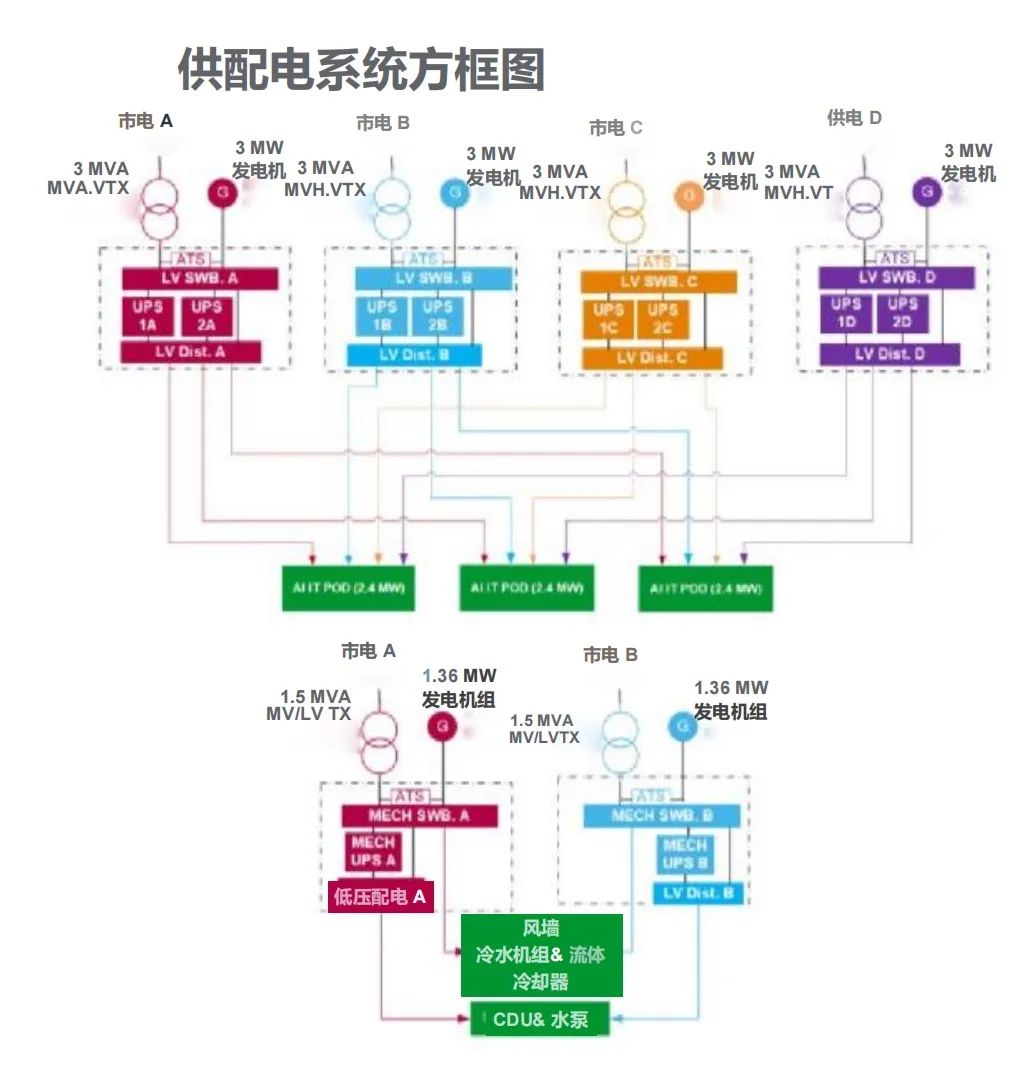

施耐德电气发布数据中心高密度AI集群部署解决方案

施耐德电气发布数据中心高密度AI集群部署解决方案

2025-04-19

-

航裕电源亮相2025慕尼黑上海电子展

航裕电源亮相2025慕尼黑上海电子展

2025-04-19

-

RECOM RACPRO1系列荣获2025年红点产品设计奖

RECOM RACPRO1系列荣获2025年红点产品设计奖

2025-04-19

-

广汽昊铂首家直营交付中心开业

广汽昊铂首家直营交付中心开业

2025-04-19

-

季丰成都实验室开启芯片微加工新篇章

季丰成都实验室开启芯片微加工新篇章

2025-04-19

-

航裕电源亮相2025俄罗斯国际电子元器件展

航裕电源亮相2025俄罗斯国际电子元器件展

2025-04-19

-

施耐德电气新型电力系统创新中心正式启用

施耐德电气新型电力系统创新中心正式启用

2025-04-19

-

格陆博科技2025上海车展亮点前瞻

格陆博科技2025上海车展亮点前瞻

2025-04-19