GPU巨头又出王炸了。

当地时间周一,英伟达发布了新一代人工智能芯片HGX H200,主打超高容量与更大的带宽,算力更为精进,主要用于培训和部署各种人工智能模型。新的H200芯片是当前用于训练大语言模型H100芯片的升级产品,集成了141GB的内存,更加擅长进行“推理”。在用于推理或生成问题答案时,性能较H100提高60%-90%。

基于英伟达的“Hopper”架构的H200也是该公司第一款使用HBM3e内存的芯片,这种内存速度更快,容量更大,因此更适合大语言模型。英伟达称:借助HBM3e,H200以每秒4.8TB的速度提供141GB的内存,与A100相比,容量几乎是其两倍,带宽增加了2.4倍。可部署在各种类型的数据中心中,包括本地、云端、混合云和边缘环境等。英伟达认为,相对先前的H100产品,在Llama 2这样拥有700亿参数大型语言模型上的推论速度将近翻倍提升。

英伟达表示,H200将与H100兼容,这意味着已经在使用H100进行训练的人工智能公司,不需要改变他们的服务器系统或软件来适应H200。H200预计将于2024年第二季度上市,将与AMD的MI300X GPU展开竞争。与H200类似,AMD的芯片比其前身拥有更多的内存,这有助于大语言模型来运算推理。

台积电助攻,H200采用台积电4nm制程,并进一步增加台积电CoWoS封装产能负荷。法人直指,台积电扩增脚步不停歇,预计本月台积电再将InFO设备自龙潭移至竹南,加速InFO改机、并调控空间。为实现庞大市场需求,台积电更加速扩充CoWoS产能,受限设备厂交期超过半年以上,台积电采取折衷方案,11月起开始将InFO机台从龙潭移至竹南改机,以应对CoWoS增加之工序。法人分析,光晶圆清洗步骤就是InFO的数倍,因此每1万片InFO产能,仅可转换为数千片CoWoS产能。法人推估,台积电将于年底开出优于市场原先预估之产能,约每月1.4万片;而英伟达也增加在非台积电之CoWoS供应链能量,如加入联电、日月光等支持。其中,由联电提供Interposer,台积电做TSV、日月光来处理后段封装,预计也会自本季开始投入。

H200助力新一代AI超算中心,云服务方面,除了英伟达自己投资的CoreWeave、Lambda和Vultr之外,亚马逊网络服务、Google Cloud、微软Azure和Oracle Cloud Infrastructure将成第一批部署基于H200执行个体的云服务供应商。此外,在新的H200加持之下,GH200超级芯片也将为全球各地的超级计算中心提供总计约200 Exaflops的AI算力,用以推动科学创新。

在SC23大会上,多家顶级超算中心纷纷宣布,即将使用GH200系统构建自己的超级计算机。德国尤里希超级计算中心将在超算JUPITER中使用GH200超级芯片。这台超级计算机将成为欧洲第一台超大规模超级计算机,是欧洲高性能计算联合项目的一部分。Jupiter超级计算机基于Eviden的BullSequana XH3000,采用全液冷架构。它总共拥有24000个英伟达GH200 Grace Hopper超级芯片,通过Quantum-2 Infiniband互联。每个Grace CPU包含288个Neoverse内核, Jupiter的CPU就有近700万个ARM核心。它能提供93 Exaflops的低精度AI算力和1 Exaflop的高精度算力。这台超级计算机预计将于2024年安装完毕。

由筑波大学和东京大学共同成立的日本先进高性能计算联合中心,将在下一代超级计算机中采用英伟达GH200 Grace Hopper超级芯片构建。作为世界最大超算中心之一的德克萨斯高级计算中心,也将采用英伟达的GH200构建超级计算机Vista。伊利诺伊大学香槟分校的美国国家超级计算应用中心,将利用英伟达GH200超级芯片来构建他们的超算DeltaAI,把AI计算能力提高两倍。此外,布里斯托大学将在英国政府的资助下,负责建造英国最强大的超级计算机Isambard-AI——将配备5000多颗英伟达GH200超级芯片,提供21 Exaflops的AI计算能力。

特供版H20、L20和L2性能曝光,据最新泄露的文件和四位熟悉内情的人士透露,为了遵守美国的出口管制,英伟达已经推出了三款全新的“中国定制版”芯片——HGX H20、L20 PCle 和 L2 PCle GPU。其中,HGX H20配有高达96GB的HBM3显存,以及4TB/s的带宽,并且基于全新的Hopper架构。与H100的50MB二级缓存相比,H20还拥有更大的60MB二级缓存。然而在性能方面,HGX H20只能提供FP64精度1 TFLOPS和FP16/BF16精度148 TFLOPS的算力。

由此,功耗也从700W降到了400W。有趣的是,基于安培架构并配备24GB HBM2的入门级A30 GPU,在FP64和FP16/BF16精度下,都要比HGX H20快不少。至于L20和L2 PCIe GPU,则是基于阉割后的AD102和AD104核心,对应的是与L40和L40S相同的市场。更直观地,RTX 4090采用的便是AD102的变体,而4070和4070Ti则是基于AD104的变体。除此之外,为了遵守新规,HGX H20、L20 PCle和L2 PCle GPU不仅性能是残血的,而且还只配备了残血版的NVLink连接。

推荐

-

VCSEL芯片和光学解决方案提供商瑞识科技完成近亿元B1轮融资

VCSEL芯片和光学解决方案提供商瑞识科技完成近亿元B1轮融资

2023-07-03

-

一文带你搞懂开关电源电路

一文带你搞懂开关电源电路

2024-11-02

-

基于脱硝系统改造的自动化优化分析

基于脱硝系统改造的自动化优化分析

2025-02-20

-

阿诗特能源L1000液冷新品震撼上市,卓越性能,引领未来!

阿诗特能源L1000液冷新品震撼上市,卓越性能,引领未来!

2024-06-15

-

博世与芯驰科技全面深化战略合作 围绕车用半导体核心技术

博世与芯驰科技全面深化战略合作 围绕车用半导体核心技术

2025-04-10

-

PLL锁相环:工作原理简述,高效同步控制的核心技术。

PLL锁相环:工作原理简述,高效同步控制的核心技术。

2024-04-07

-

中科曙光助力北京航天总医院打造24小时在线的AI医疗助手

中科曙光助力北京航天总医院打造24小时在线的AI医疗助手

2025-04-10

-

国产替代奋进高端,创新引领,开启替代新篇章。

国产替代奋进高端,创新引领,开启替代新篇章。

2024-04-07

-

模拟芯片与数字芯片各有独特优势,各具魅力,吸引你的目光。

模拟芯片与数字芯片各有独特优势,各具魅力,吸引你的目光。

2024-03-06

-

本征半导体,基础材料之选,了解它,掌握电子世界的关键!

本征半导体,基础材料之选,了解它,掌握电子世界的关键!

2024-04-07

最近更新

-

基于SiWG917Y的无电池Wi 6传感器

基于SiWG917Y的无电池Wi 6传感器

2025-04-19

-

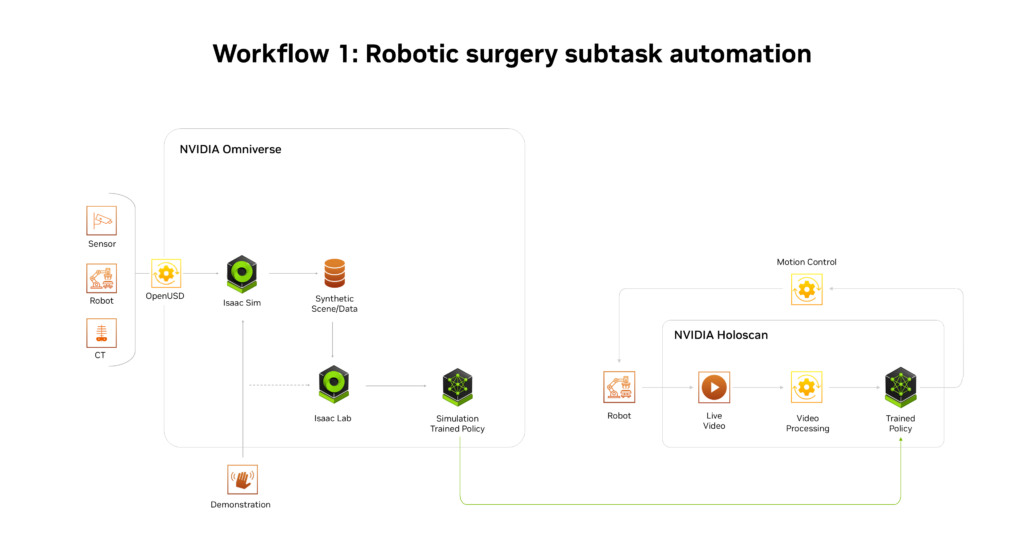

NVIDIA推出AI医疗健康机器人开发平台

NVIDIA推出AI医疗健康机器人开发平台

2025-04-19

-

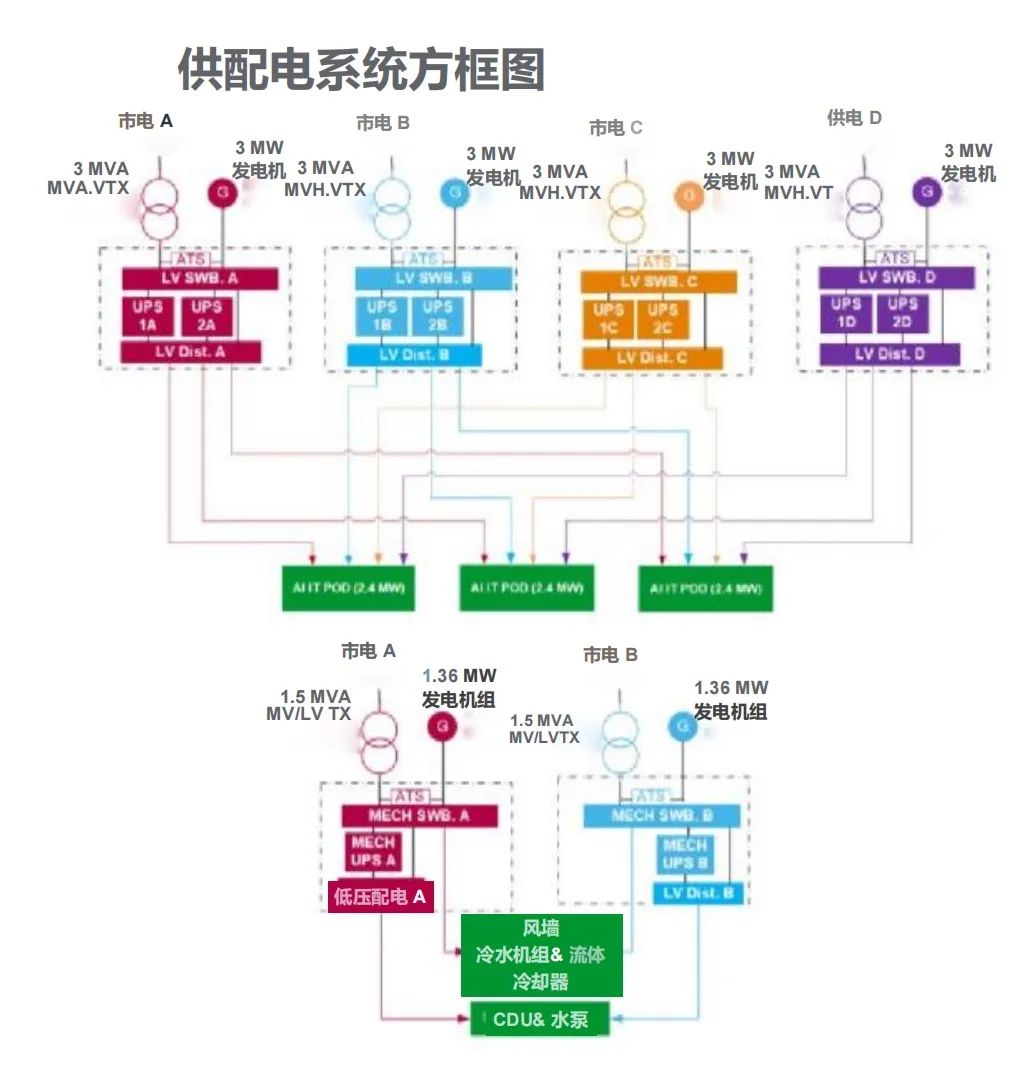

施耐德电气发布数据中心高密度AI集群部署解决方案

施耐德电气发布数据中心高密度AI集群部署解决方案

2025-04-19

-

航裕电源亮相2025慕尼黑上海电子展

航裕电源亮相2025慕尼黑上海电子展

2025-04-19

-

RECOM RACPRO1系列荣获2025年红点产品设计奖

RECOM RACPRO1系列荣获2025年红点产品设计奖

2025-04-19

-

广汽昊铂首家直营交付中心开业

广汽昊铂首家直营交付中心开业

2025-04-19

-

季丰成都实验室开启芯片微加工新篇章

季丰成都实验室开启芯片微加工新篇章

2025-04-19

-

航裕电源亮相2025俄罗斯国际电子元器件展

航裕电源亮相2025俄罗斯国际电子元器件展

2025-04-19

-

施耐德电气新型电力系统创新中心正式启用

施耐德电气新型电力系统创新中心正式启用

2025-04-19

-

格陆博科技2025上海车展亮点前瞻

格陆博科技2025上海车展亮点前瞻

2025-04-19