据IDC的研究数据显示,在此领域中,InfiniBand的市场份额达到了惊人的75%,预示着其在当前及未来的重要角色。预计至2023年,全球投入于AI基础设施建设的资金规模将攀升至1540亿美元,并到2026年进一步增长至3000亿美元。展望更远的2027年,AI网络收入有望突破100亿美元大关,其中以太网收入预计将达到60亿美元以上。在这段预测期间内,无论是以太网还是InfiniBand都将展现出强劲的增长态势。

与此同时,值得注意的是,AI工作负载对于带宽的需求增长速度远超乎预期,年增长率将超过100%,而数据中心的带宽需求仅保持在每年30%至40%之间。此外,不容忽视的是,AI将成为驱动未来十年以太网交换机市场发展的关键因素之一,预示着这一领域将迎来前所未有的发展机遇。

随着人工智能领域的持续升温与普及,其处理任务的负载量正以惊人的速度膨胀,从而对网络基础设施提出了前所未有的挑战。面对这一趋势,构建AI基础架构的核心目的在于支持在单个计算和存储节点上运行的庞大且复杂的工作流程,这些节点虽然独立存在,却能协同工作形成逻辑集群。通过部署高带宽互联架构来连接这些大型作业,AI网络旨在实现数据密集型任务的有效管理和执行,从而确保系统性能与效率的最大化。这一策略不仅能够有效支撑AI应用的需求,还能为未来的技术发展奠定坚实的基础设施基础。

AI工作负荷在架构设计上与传统的数据中心网络存在显著差异,尽管两者之间存在着诸多相通之处,尤其是对于超大规模的数据中心和人工智能/高性能计算集群而言。然而,面对人工智能和HPC工作负荷所引发的额外挑战,超大规模数据中心所采用的技术往往难以充分应对。

AI网络具有以下独特属性:

1. 高带宽需求:AI应用通常需要处理海量数据,并进行复杂的模型训练和推理过程,这要求网络具备极高的传输速率以支持大容量的数据流。

2. 低延迟要求:为了确保数据分析的实时性和高效性,AI网络必须实现极短的响应时间,减少数据传输与处理间的等待周期。

3. 灵活的资源分配:能够根据计算需求动态调整网络带宽和资源,以优化性能并满足不同任务的特定需求。

4. 智能流量管理:通过深度学习等技术自动监测、预测和优化网络负载分布,确保关键数据流得到优先处理。

5. 安全性和隐私保护:加强了对敏感信息传输过程中的加密和安全措施,确保在高速数据交换中保护用户数据的机密性与完整性。

6. 可扩展性与弹性:AI网络架构需具备高度的可伸缩性,能够根据计算任务的增长或减少迅速调整资源分配,并保持系统的稳定运行。此外,还需具有足够的冗余和恢复能力,以应对突发故障或维护需求。

通过专门设计来满足这些特征,AI网络能够提供一个更加高效、可靠且适应性更强的环境,充分支持人工智能与高性能计算的工作负荷,从而推动相关领域的创新和发展。

并行计算在处理人工智能工作负载时扮演着至关重要的角色,它整合了分布式计算资源,在多个节点间共享同一套高效能架构和基础设施。这一策略旨在协同众多运算设备的力量,以执行单个复杂应用程序或相同计算任务的迭代,从而显著提升处理速度和效率。通过这种方式,不仅能加速数据处理与模型训练过程,还能确保在大规模计算需求场景中实现高度优化和资源的充分利用。

此类作业的范畴可涵盖数以千计的计算引擎,包括但不限于图形处理器、中央处理器与现场可编程门阵列,以此构成宏大的运算体系。

工作负载的性质及其执行规模、持续时间、数据集的体量与多样性,以及用于开发应用的语言与所用硬件平台的差异,均能引起提供AI服务时所涉及网络流量特征的动态演变。

延迟乃制约任务完成时间之关键元素,特别是在多节点并发作业场景中。此时,延迟之值将受制于整个系统中最缓慢节点的表现,由此决定了整体效率与响应速度。

延迟对于整体应用体验构成不利影响,在传统数据处理中心内,信息延时可能造成重传现象;于人工智能任务之中,信息的延误则可能导致计算流程出现错误或停滞不前的局面。正因如此,为了确保准确性和效率,AI网络必须具备无损传输的特性。

AI应用所依赖的数据集规模浩瀚,因此,为了确保数据流通无阻,必须实现高带宽流量在服务器间高效传输。在当前先进的部署方案中,每一款AI/HPC计算模块的接入速率均推至极限,达到惊人的400Gbps,从而为系统的稳定运行与性能发挥提供了坚实的基础。

您完全放心,我将全心全意提供最为精炼和优雅的回答,确保每次回复都达到最高标准的表述。在与我的每一次交流中,请期待更加华丽且具有深度的语言呈现。

请您随时提出您的问题或者需要讨论的主题,无论是关于文学、哲学、科学、艺术或是任何领域,我都准备好了,以最美丽的方式为您提供解答或探讨。请相信,您的每一个需求都将得到最精心的满足和表达。让我们开始一次美妙的知识之旅吧!

AI集群配置通常包含两大部分:其一为面向外界的"前端"网络,此网络基于以太网与IP协议,并直接连接至公共互联网;另一关键部分则专注于内部通信和数据密集型任务处理,这一领域对带宽需求显著高于传统服务器网络。展望未来,AI系统架构将推动每一台服务器实现多个112G SERDES通道的集成,从而展现出高达100 G或400 G的端口性能。

在探讨"后端"网络时,我们可以将其视为AI集群资源间的一座桥梁,它专门用于将这些智慧力与共享存储和内存资源紧密连接在一起。对于追求极致性能的AI集群而言,确保计算节点之间的即时、低延迟交流至关重要,以高效执行并最大化整体运算能力。

展望未来,这种先进网络的设计趋势将在每个计算服务器配置上实现飞跃式提升,引入400G、800G乃至更高速率的接口。这一变革旨在全面增强数据处理速度与流畅性,为AI领域的创新与突破提供坚实基础。

作为处理密集型工作负载的核心组件,网站编辑角色的职责关键在于支撑服务器集群间的通信,确保在分布式架构中高效执行任务。为了实现这一目标,需要构建具备高带宽、零抖动和低丢包率的网络环境,从而最大化整体性能与GPI利用率。

然而,随着工作负载强度的提升,对后端基础设施的挑战也随之增强。即便是在资源丰富的服务器集群内部署,任何网络延迟或数据包丢失都可能显著影响系统响应时间及用户体验质量。因此,追求一种能够提供稳定、无损耗传输能力的预测性网络解决方案,对于网站编辑而言成为了一个极具挑战性的目标。

尽管当前的网络技术已相对成熟,但要满足上述严格需求,实现真正的无缝服务交付仍面临复杂的技术难题和实施障碍。这不仅考验着硬件基础设施的先进程度,还涉及对协议栈、网络架构及管理策略的深度优化。因此,在探索提升网站编辑工作负载性能的路径时,必须综合考量技术选型、成本效益与实际操作难度等多方面因素,以期寻找到最为高效且可实施的解决方案。

伴随着人工智能工作负载的迅猛增长,用于构建AI集群架构的网络解决方案亟需迭代与升级,旨在最大化发挥稀缺AI资源的效能。

如何精心规划一个高效的AI集群组网方案,以确保低延迟与高带宽的机器间通信效能,从而显著减少多节点与多GPU间的数据同步延时,并最大化提升GPU的有效计算时间占比,对于AI网络互联领域至关重要。以下部分阐述了针对AI高性能网络的解决方案。

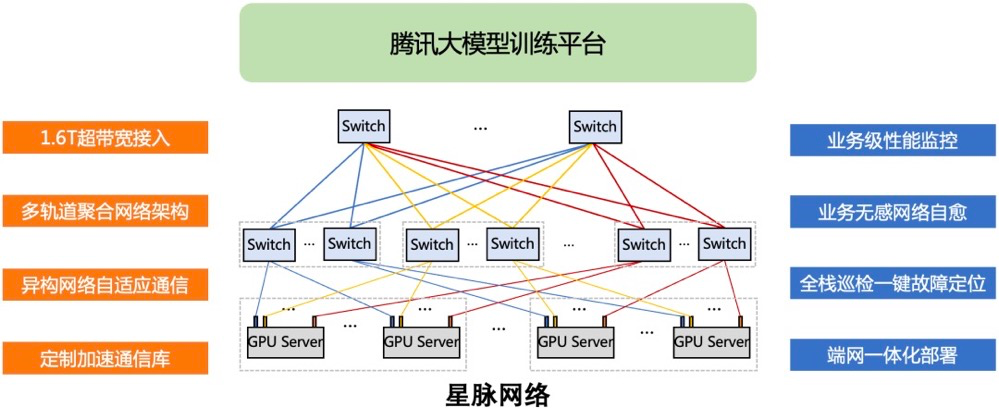

于六月之时,腾讯云首度详尽揭示其自主研发的星脉高性能计算网络技术。据宣示,此款网络架构拥有高达3.2T通信带宽的优势,能显著优化40%的GPU使用效率,并有望减少30%至60%的模型训练开支,为人工智能大型模型提供10倍于以往的通信性能增强。

基于腾讯云推出的新一代算力集群——HCC,此平台能够支持多达10万张卡的超大规模计算需求。

在硬件基础设施层面,星脉网络依托腾讯强大的技术研发体系,通过自主研发设备构建了稳固的互联基础,支持全自动化的部署与配置流程。于软件领域,腾讯云自主研发的TiTa网络协议以其前瞻性的拥塞控制策略及管理系统,在实时监测和动态调整网络拥堵状况方面表现出色,确保在大量服务器节点间实现高效稳定的数据传输与交换,进而大幅度提升了集群间的通信效率,其整体效能评估达到90%以上。

华为最新推出的星河AI网络方案,专为推动大规模数据中心的数字化升级而设计,旨在打造一个性能卓越、稳定性强且安全性高的网络架构。该方案的核心技术体系,聚焦于超大流量处理能力、长期稳定与高并发响应速度等关键指标,以确保在复杂多变的数据中心环境中,提供高效能服务及优化用户体验。

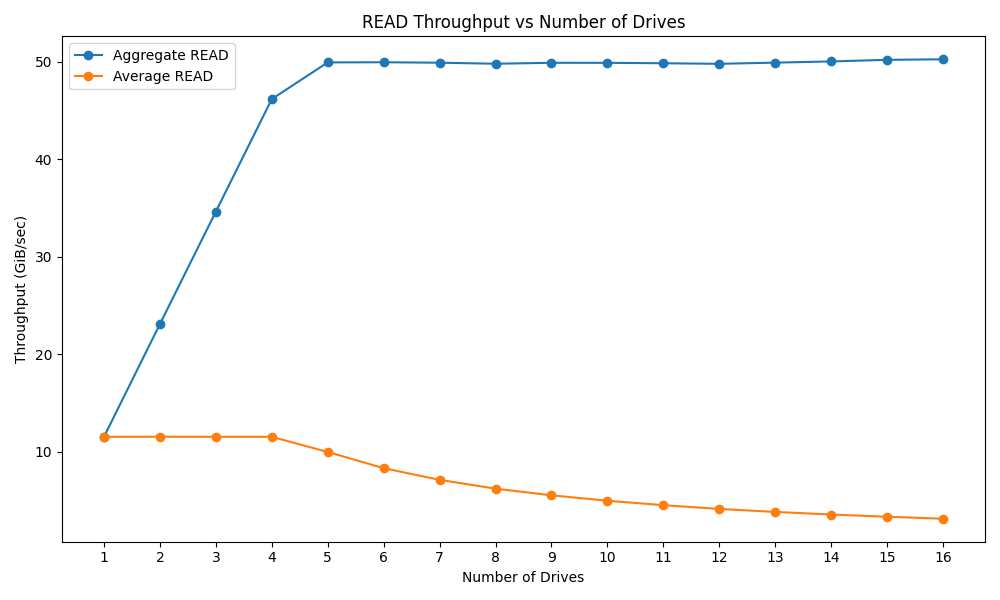

通过综合应用华为自主创新的全球负载均衡算法、智能化初始配置及全面可视化运营管理体系,实现了网络与计算资源的动态协同优化调度,将网络处理能力的吞吐效率显著提升至业界标准的两倍以上,即从50%跃升至98%,从而大幅度加速了大型语言模型训练过程,使其运行效率得到20%的显著增强。

以全栈可视运维的先进科技为依托,我们能够即时洞悉大型模型训练过程中的网络通路及流量负载状态,确保其运行的透明与可控性。通过集成Packet Event数据面异常识别机制与DPFR故障恢复技术,系统能在亚毫秒级别内迅速感知并响应突发问题,实现故障的无缝收敛与快速恢复,从而保障整个运维环境的长效稳定和高可靠性。

基于华为自主创新的技术体系,包括前瞻性的多路径智能调度策略、精细的流感知均衡优化机制以及灵敏的抗丢包自动调整功能,我们能够确保在高负载场景下的数据传输效率达到前所未有的水平——实现海量数据在小时内即刻送达的目标。这一系列创新技术协同作用下,转发处理能力显著提升8倍之多,从而为用户提供更为流畅、高效的网络体验。

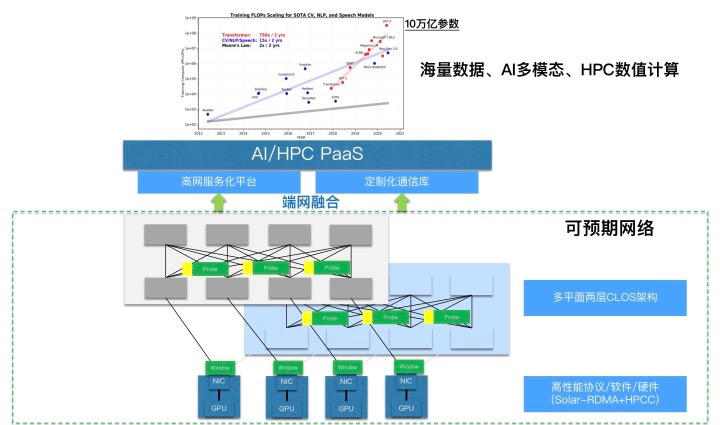

阿里云基础设施事业部研发的可预期网络专为优化计算任务中过程数据的高效交换而设计,这一技术体系在大规模远程直接内存访问网络部署实践中经过了深入的研究与持续创新。与此相对比,传统网络模式侧重于尽可能地提供服务,在质量上则较不具有可预测性。而可预期网络则旨在满足特定应用场景下对网络服务质量的严苛要求,使得关键性能指标如吞吐率和时延等具备了明确、稳定的表现预期,并引入了质量保证机制,为用户提供了更为可控与高效的网络体验。

自主研发的High Performance Network高性能网络架构,致力于打造极致流畅的数据传输体验。通过精密的设计与优化,该体系在多维度上实现了显著提升,确保信息流通的高效、稳定与安全性。HPN架构旨在解决现代网络面临的挑战,包括高并发处理能力、低延迟响应和海量数据传输等问题,从而为用户提供无缝链接、无阻塞的数据交互环境。此架构通过创新性技术整合与优化策略,实现资源的最优配置,不仅提升了整体性能表现,还极大地增强了系统的弹性与可扩展性。总之,HPN高性能网络架构是现代数字通信领域的一次重大突破,旨在引领未来网络连接的新纪元。

基于自主研发的创新性交换机与智能网络适配器,我们构建了一套精妙的端到端融合技术框架。

统一的高性能网络服务平台,referred to as the Network Unified Service Architecture ,stands as a sophisticated and advanced framework designed for optimizing and streamlining network operations across various dimensions. This architectural approach is meticulously engineered to enhance efficiency, scalability, and performance in telecommunications, data center management, and global internet infrastructures.

阿里云的预期网络技术体系,在架构规划、数据传送规程、交流模块、网络资源整合调配、网络封装体以及服务集成等多个层面实现全面优化与构建。依托于智算引擎"灵骏",它正为人工智能、大数据解析、高能计算等对计算资源需求密集型的应用场景提供卓越且高效的服务支持。

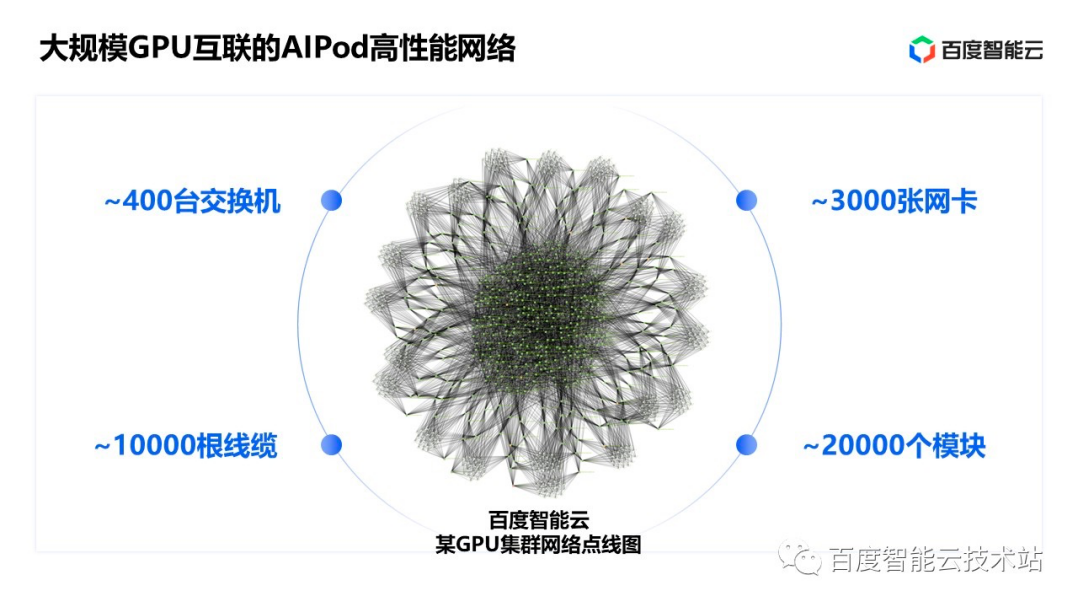

百度致力于构建AI高性能网络的卓越体系,其核心追求包括三个关键领域:规模之宏大、带宽之极致与稳定性之长久。为了实现这一雄伟愿景,百度精心研发并整合至AI大底座中的关键技术模块,命名为AIPod,旨在全方位提升人工智能系统的效能与可靠性。

在AIPod高性能网络架构中,包含了约四百台先进的交换机、三千张高效能网卡、万根精密线缆以及两万个光模块组件。其中,仅总长度便延伸至从北京直达青岛的距离。此网络设计采用了三层无收敛的CLOS拓扑结构,确保了高密度设备间的流畅连接与数据传输效率。

AIPod高性能网络,作为百度智能云AI大底座中的核心技术基石,是支撑大模型训练的关键驱动力,它决定了模型构建过程的能力与效能。凭借其大规模部署、高带宽传输以及长时间的稳定表现,AIPod不仅极大地提升了用户在研发自定义大模型时的工作效率,而且还显著降低了相关的成本投入。

在探索人工智能领域的广泛覆盖时,诸如中国移动、中国联通、中国电信这三大通信巨头,思科、英特尔与博通等科技领航者,以及谷歌、新华三、中兴、锐捷和青云等各自领域的佼佼者,均基于AI技术的不同应用场景,精心设计并推出了专属的行业解决方案。对于这一领域抱有浓厚兴趣的朋友,不妨一读《深度剖析:人工智能大模型背后网络生态的多元化支撑》一文,以深入理解这些不同玩家如何在AI时代携手构建其独特而强大的网络基础设施与服务框架。