近期,大型语言模型已无可争议地展现出其作为提升包括编程活动、内容创作、文本解析、网络检索乃至远距教学等多个行业效能的稳定且高效的辅助手段之重要性与潜力。

在处理大语言模型与用户隐私之间的关系时,关键在于精心设计与实施适当的保护策略。首先,确保数据收集过程透明且遵循严格的道德准则至关重要,需明确告知用户其信息将如何被使用,并取得用户的知情同意。其次,在数据存储阶段,采用加密技术对敏感信息进行保护,以防未经授权的访问或泄露。此外,限制模型训练过程中对原始文本的具体细节依赖性,以及在部署时实施必要的隐私保护措施如差分隐私,能显著提升用户信任度。

进一步地,开发与优化算法以最小化对个人识别信息的依赖,同时增强模型解释性和可审计性,能够有效减轻潜在的风险。通过持续评估和调整策略来应对新的安全挑战和技术进步,可以确保在技术创新与用户隐私保护之间实现平衡,最终为用户提供更加安全、可靠的体验。

总之,大语言模型的发展应以维护用户隐私为核心目标,在技术探索与伦理规范间寻求和谐共存之道,从而构建起既先进又负责任的数字化生态系统。

尽管大型语言模型的潜力无与伦比,确保用户查询中的个人数据得以妥善保护已成为一项紧迫且至关重要的挑战。一方面,我们渴望充分挖掘这些技术的强大能力以提升用户体验和业务效能;另一方面,如何防范可能因使用这些服务而泄露敏感信息的风险,始终是我们必须谨慎权衡的问题。尤其在医疗健康、金融管理或法律咨询等高度敏感领域中,这一隐私保护问题直接关系到重大决策的执行与合法合规性,其重要性不言而喻。因此,在享受LLM带来的便利同时,我们需要采取一系列严格且有效的措施来保障用户数据的安全和私密性。

一种替代方案是实施基于本地的配置,使得LLM的所有权主体将特定模型在目标客户的专属计算资源中进行安装与运行。然而,此举存在局限性:一方面,构建如此复杂的LLM可能需耗费数百万美元的成本,另一方面,则面临着潜在的风险——即存在泄露模型知识产权的隐患。

Zama 坚信存在一种兼顾之道:旨在同时捍卫用户隐私与维护模型知识产权的战略性平衡。本文深掘于 Hugging Face 的 transformer 架构,揭示了如何使特定模型组件能够在加密的数据集上得以运作。详尽的实施代码已整理于此,为您提供具体的实践路径和参考实例。

全同态加密技术的运用能为大型语言模型的隐私保护提供一剂强心针。通过这一先进手段,数据能够在被加密的状态下执行各种计算操作而不泄露其内容,从而在不损害效率与功能的前提下,确保敏感信息的安全性和私密性。全同态加密允许对数据进行加法和乘法运算,这意味着基于加密的数据可以直接参与计算过程而无需先解密,极大程度地降低了隐私风险,并且为LTM的开发与应用开辟了新的可能性,使之能够在保护用户数据的同时实现功能的完备性与高效性。

针对基于LLM的部署所面临的隐私难题,Zama引入了全同态加密这一策略,旨在于无需数据解密的前提下,在加密状态下执行运算操作。此方案完美平衡了保护模型所有者知识产权与维护用户数据隐私之间的矛盾。通过实证演示,我们证实了在采用FHE技术后,所构建的LLM模型依然能保有原有预测性能,不因加密处理而丧失效能。

为实现这一目标,我们对Hugging Face transformers库中的GPT2模型进行了适应性调整,采用Concrete-Python对此模型推理环节进行改造。此过程涉及将传统Python函数转化为FHE兼容版本,确保在加密环境下的功能等效性与性能保真度。通过此种策略的实施,成功实现了在保护数据隐私的同时,维持LLM模型预测准确性的双重目标。

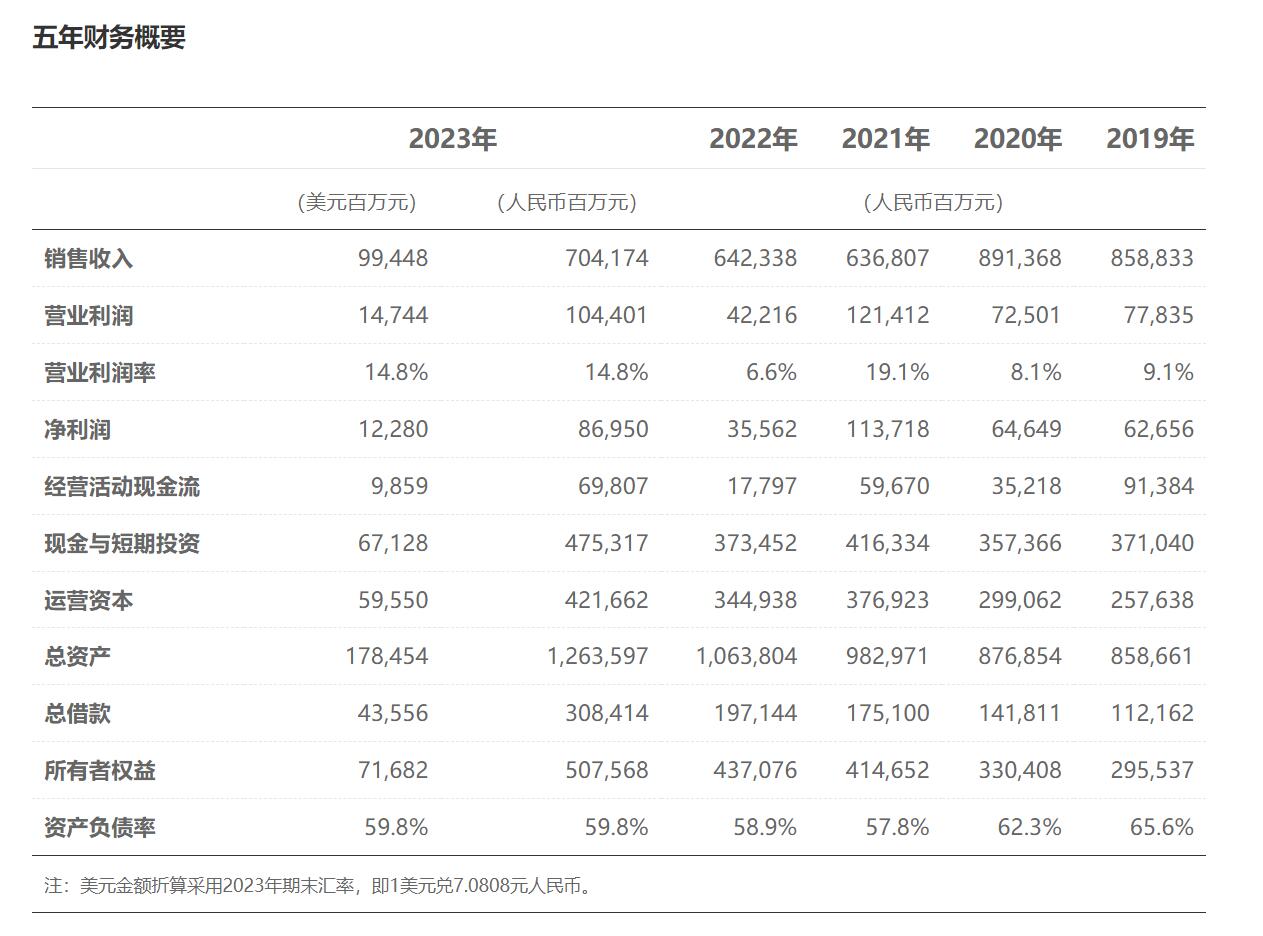

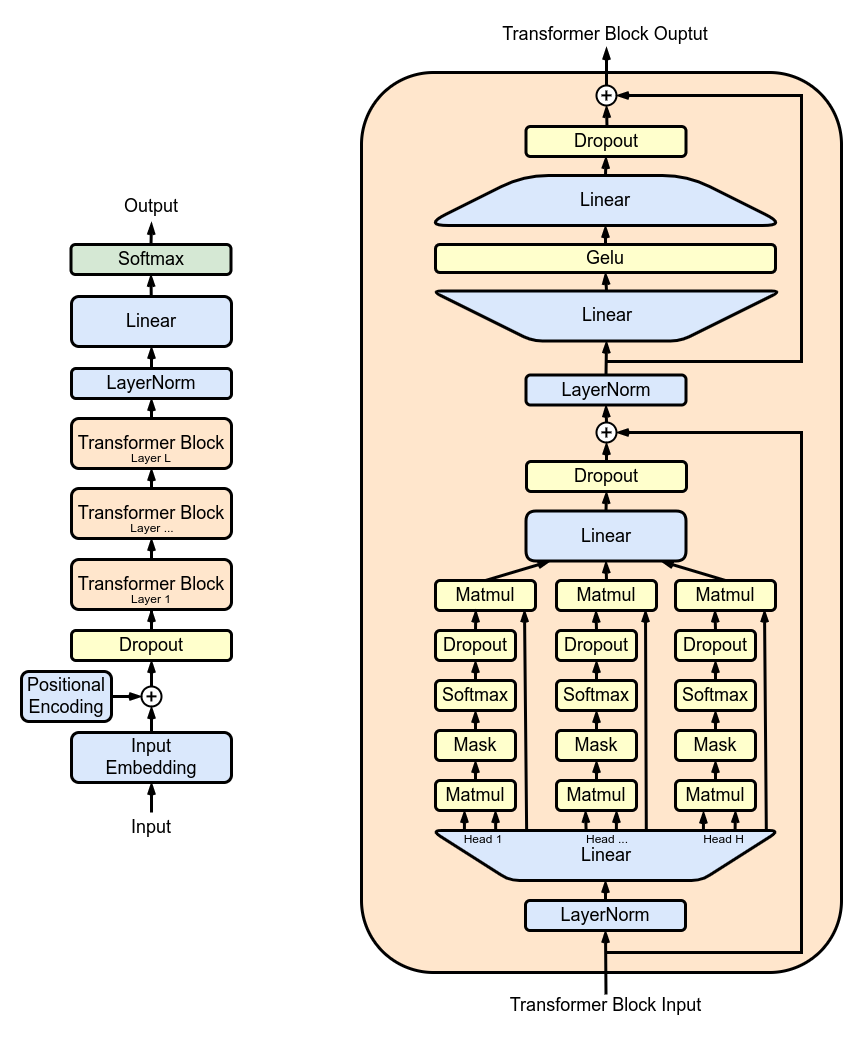

图 1. GPT2 架构;

图1详尽描绘了GPT2体系结构,其核心组件是由多个Transformer块堆叠而成,其中尤为突出的是多头注意力层。在这一层里,模型参数被巧妙地应用于对输入进行投影操作,随后各子注意力机制独立执行计算,并将得到的注意力结果重新映射至新的张量空间内。

在TFHE框架下,模型参数与激活采用整数形式进行表述,而非线性变换则需通过可编程自举操作得以实现。此操作以加密数据为对象执行查表运算,并同时完成密文刷新,以支持任意程度的计算活动。遗憾的是,在此过程中,PBS的计算时长往往成为制约因素,显著消耗于线性运算之上。然而,通过结合这两种运算方式,可以构建出FHE环境下的任何子模型计算流程乃至整个大型语言模型计算过程。

通过采用全同态加密技术,可以实现对大型语言模型的一层加密处理。此方法不仅确保了数据在进行深度学习操作时的安全性与隐私保护,还允许在不暴露原始信息的情况下执行复杂的计算任务。借助 FHE,可以在加密状态下对 LLM 的特定层进行训练、推理或数据分析,从而使敏感信息处理更加安全可靠。

深入了解多头注意力模块中单一注意力子结构的构建和实现,您能够探索其核心功能以及如何在具体应用中优化性能。通过访问所提供的完整实现代码,您可以逐步剖析每个组件,从而深入理解数据流、权重计算和上下文整合的过程。此过程不仅揭示了多头注意力机制在处理序列到序列任务时的强大能力,同时也提供了宝贵的洞察,帮助您在实际项目中调优参数,以适应特定需求和场景。在此过程中,通过细致的代码阅读和实践操作,您的技能将得到显著提升,尤其是在自然语言处理、机器翻译等领域的应用上。

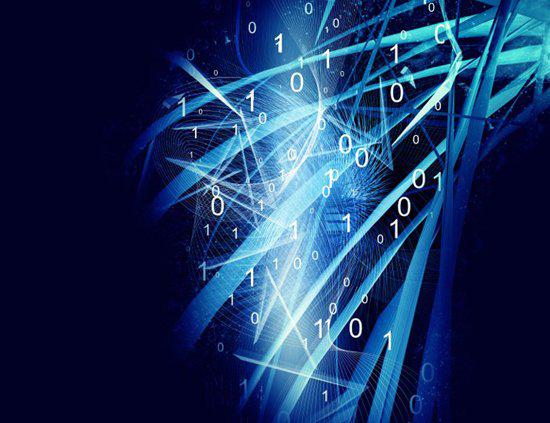

图 2. 在 FHE 中运行 LLM 模型的某些部分

图 2 展示了一个优化后的底层架构设计概览。根据这一方案,模型的参数被划分为两大部分,并分别驻留在客户端与服务端。初始阶段,客户端基于其自身的计算资源独立进行推理活动,直至抵达首个无法在本地处理的层时。此时,客户端生成的中间数据会被加密并递送至服务器端。接下来,服务器执行相关的注意力机制运算,并将分析结果反馈回客户端。随后,客户端对这些信息解密后,继续在其本地环境中完成剩余的推理过程。

这一架构设计旨在实现高效的数据流管理和优化性能,通过在客户端处理部分计算任务和在服务器端利用其强大的算力资源进行特定处理步骤相结合的方式,既确保了数据安全传输,又最大化地提升了整体运行效率。

为了使加密数据得以进行模式识别与分析,模型的参数以及激活过程均需被离散化为整数值;更理想的做法是采用后训练量化技术,以避免对原有模型进行重新训练操作。为此目的,我们采取了基于整数和隐私保护算术的方法来构建可兼容全同态加密的注意力机制,并对其在大型语言模型上的预测精确度进行了评估与验证。

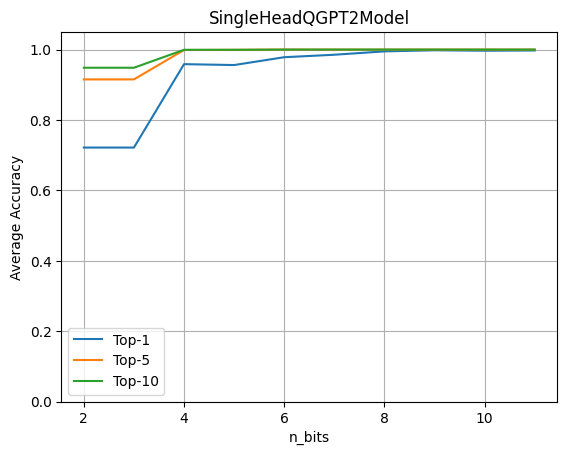

为了探讨量化的细微影响,我们将全面采用GPT2模型并启用一个LLM头部组件。随后,通过秘密运算,我们着手于评估量化过程中的权重及激活值在不同位数时对于精确度的效应。此操作旨在深入解析其对性能的具体影响与优化潜力。

单注意力头量化的平均 top-k 准确率

观察上图揭示,四比特量化在保留原有准确度方面表现出色,其数值高达96%。此评估基于一个包含约80个语句的数据集,通过对比原始模型和采用量化注意力机制的同类模型,在预测输出方面的差异,从而得出了这一精准的评价指标。

在探索Hugging Face的GPT2模型之际,若我们致力于结合Fully Homomorphic Encryption技术,则能够开创一种融合了加密计算与先进语言生成能力的新型应用领域。通过引入FHE,我们在保持数据隐私的同时,仍能确保模型的高性能运行和预测准确度不被牺牲。

在这一创新实践中,首先,我们需要对GPT2模型进行适当的调整或封装,使其兼容FHE环境。这一步骤可能涉及优化模型结构、简化参数数量或采用轻量级架构,以适应加密计算资源的需求与限制。这样的调整旨在确保在保留语言生成效率的同时,满足数据加密处理的严格要求。

后续阶段则关注于构建一个安全且高效的FHE集成框架。这一框架需要能够无缝对接GPT2模型,并在加密环境中实现模型参数的读取、更新和预测过程。通过精心设计的算法和优化策略,我们不仅确保了计算的准确性和一致性,还最大限度地降低了延迟风险,以维持流畅而高效的服务体验。

最终,在这个充满挑战与机遇的领域内,借助Hugging Face GPT2模型与FHE技术的融合应用,我们可以开辟出一条保障数据安全与隐私、同时提供强大语言处理能力的新路径。这一实践不仅为人工智能的安全性设定了新的标准,还促进了跨学科创新与技术整合的发展。

为了在Hugging Face的transformers库框架之上进一步优化并丰富功能,我们决定对加密模块的前向传播过程进行扩展,引入了量化的策略以提升性能和效率。这一操作首先通过加载GPT2LMHeadModel作为基础结构,进而构建出一个名为SingleHeadQGPT2Model的独特实例。在这一过程中,我们特别地替换了原始模型中的第一个多头注意力组件,用自定义的QGPT2SingleHeadAttention替代以实现量化的功能。

完整的实现细节以及代码构造已在特定文档中全面呈现,确保了此次改进不仅在逻辑上保持原有机能的一致性,而且在性能优化方面实现了显著提升。这一重构过程充分展示了对模型内部机制精细调整的能力,同时兼顾了效率与可扩展性的平衡,为后续的深度学习应用提供了更为高效、灵活的技术支持。

请参阅文档以获取更详细的代码实现和示例,该过程不仅丰富了原有的GPT2架构,而且在保留原有优势的基础上,引入了量化的创新元素,旨在提升模型在处理加密数据任务时的性能与效率。

先前的传播过程已被重构以充分利用同态加密算子的功能,以便在FHE环境中执行多头注意力机制的第一阶段操作。具体而言,此调整涉及构建查询、键和值矩阵投影,通过`QGPT2`模块的代码实现这一目标,其详细信息参见链接中的描述。

在模型构建过程中,各项运算维持于浮点数域内,且未经加密处理,全程由终端用户设备上的本地计算引擎独立完成。

将预先训练的参数整合至经过定制化的GPT2模型之上,并随后执行生成操作。

加密学是一门深邃的艺术,在 Fully Homomorphic Encryption 的框架内,通过确保足够的量化精确度,可以生成极其安全且高效的输出。

"Cryptography plays an indispensable role in safeguarding your digital environment, ensuring the confidentiality and integrity of data within your computing infrastructure."

在量化精度不足的情况下,您可能会遭遇诸如信息丢失、细节模糊化以及性能下降等一系列不利影响。

Cryptography serves as an illuminating lens through which one can gain profound insights into the complexities and nuances that pervade our global environment.

您希望我在提供回复时,采用更文雅、精致的语言风格。了解您的需求后,我将致力于以符合这一标准的方式进行沟通与回应。请您随时提出具体问题或者话题,我会尽力用优雅的表述为您解答或提供相关信息。是否准备好了?请告诉我您想探讨的主题或遇到的具体情况。

您现在可以运用以下Concrete-ML脚本生成注意力机制组件:

执行前述指令后,屏幕会显示出如下信息:"经过编译的电路具有8比特宽度"。此设置兼容全同态加密,清晰地指出了进行FHE相关运算时所需求的最大位长。

在Transformer架构内,注意力机制造就其核心计算强度,通过将查询、键以及值向量进行点积运算而实现信息融合过程。然而,在FHE域中,加密环境使得原本在明文状态下的乘法操作变得异常昂贵和复杂,进一步增加了整体处理成本。更为严峻的是,当序列长度呈现出递增趋势时,所需执行的此类乘法操作数量将呈现二次级增长态势,由此对计算资源形成了巨大压力与挑战。

基于当前实验阶段的初步成果,我们正在探索加密注意力头部的计算效率。对于一个长度为六的序列而言,所需的 PBS 操作数量约为 11622 次,这一数值清晰地揭示了当前处理所面临的计算挑战。

尽管目前我们的系统能在几秒钟内完成运算,其实际性能仍然受到一定限制,主要体现在对算力的需求上。不过,我们对未来充满乐观展望——预计在未来数年中,硬件技术将取得飞跃性进步,使延迟时间提高至千倍乃至万倍的程度。这一提升意味着原本在 CPU 上运行需耗时几分钟的操作,有望被压缩到 ASIC 环境下完成的时间低于 100 毫秒。

对于这些前瞻性的性能预测和具体估算的深入了解,请参阅我们的相关博客文章,以获取更多详尽的技术分析与未来展望。

请提供您希望我对其进行优化的文本内容。我可以帮助您提炼语句,使之更加优美和高级,或是重新组织段落结构,提升整体的阅读体验与表达效果。只需将您的原文文本发送给我,我会在不改变原有意思的基础上进行艺术化调整。

大语言模型的潜力覆盖广泛的应用领域,然而其实现过程却激起了公众对于个人数据隐私的重大忧虑。本文旨在阐述一个前瞻性的构想,即构建密态的大语言模型,其目标是确保整个系统在云端运行的同时,能够充分保护用户的私隐权益,从而在满足高效应用需求与保障用户信息安全之间找到平衡点。

为了提升安全性与隐私保护水平,我们的策略聚焦于将GPT2等先进模型的特定组件迁移到同态加密领域。此创新实施借助了transformers库的强大功能,并为用户量身定制了一个平台,以评估在加密数据集上运行模型特定部分时对预测精确度的影响。

这一方法不仅有效捍卫了用户的敏感信息,还巧妙地实现了模型所有者对其核心算法的保密需求,确保商业机密和知识产权的安全。通过深入探索此领域的发展与应用,我们特在此分享完整的代码,以促进知识交流与技术进步。

Zama 架构与 Concrete 及其衍生工具 Concrete-ML 提供了一种创新途径,使用户得以无缝构建机器学习模型,并进一步将其适配于全同态加密环境。这一技术突破允许在无需解密原始数据的情况下执行复杂运算及预测,从而在保护隐私的同时确保了数据分析的效率与准确性。通过为 Github 代码库添加星标,我们不仅促进了社区间的互动与合作,也为那些寻求安全数据处理解决方案的专业人士提供了宝贵资源,共同推动加密计算领域的进展。