NVIDIA DOCA框架专为简化NVIDIA BlueField Data Processing Units及ConnectX智能网卡的编程及应用开发而精心设计。该平台通过提供软件开发工具包、运行时二进制文件以及高度封装的高级API,以网络应用程序为中心打造了一系列抽象构建模块,旨在加速开发者在短时间内设计出高效且创新的应用程序与服务流程。

NVIDIA DOCA Flow, an advanced software suite and转向库 within the DOCA framework, has recently been introduced. This innovative component operates in user space, enabling offloading of network-centric tasks from the Central Processing Unit . Consequently, it facilitates applications to handle high data packet throughput workloads with minimal latency, optimizing CPU utilization and contributing to energy efficiency by significantly reducing power consumption.

您提供的话题和具体细节未知,所以我无法直接为您生成一段更漂亮、更优雅、更高级的回答。请尝试给我一个具体的语境或者需要改进的段落内容,这样我就能为您提供一个符合要求的答案了。

例如:

如果原本的内容是:“这是一份报告。”

那么经过扩展、改写后可能会变成:“这份详尽的研究分析不仅揭示了当前市场趋势的全貌,还深入探讨了潜在机遇与挑战,并提出了前瞻性的策略建议,为决策者提供了宝贵的信息资源。”

请您提供您想要改进的具体内容或主题,这样我就能为您提供一个高级的回答。

DOCA Flow赋能C语言库接口,旨在构建基于硬件的数据包处理流水线,其核心在于抽象化BlueField DPU与ConnectX智能网卡的底层硬件能力。这一设计使得软件开发者得以构筑面向数据中心及云网络领域的高性能且具备扩展性的应用解决方案。通过编程方式定义并掌控网络流量流向,实现精细网络策略部署,并确保资源高效管理,从而显著提升整体网络性能与系统响应速度。

DOCA Flow 精妙地补充并扩充了 DPDK 的核心编程能力,并专为 NVIDIA BlueField DPU 及网卡打造了一系列优化特性和定制功能。该解决方案不仅构建了一套基本的数据包处理流程组件,极大地简化了网络堆栈的复杂性,而且其应用范围广泛,既涵盖了主流网络用例,如最长前缀匹配和 IPsec 加密解密操作,也能够应对更为复杂的场景,例如自定义或调整访问控制列表中的条目规则。通过此举,DOCA Flow 为网络领域的专业用户提供了高效、灵活的解决方案与工具集。

采用预先打造的网络模块化组件,使得应用开发人员能够将重点放在构建核心功能上,而无需投入过多资源去处理低层级的数据包封装与管理细节。此举显著缩短了产品上市时间,并允许开发者专注于应用程序的实际价值所在,因为这些组件经过精心优化,确保了出色的性能表现。

DOCA构建块为软件开发流程引入了一种更为高效、简洁的方式,其设计旨在满足从初学者到高级开发者在内的各类编程水平需求。通过使用这些预构建模块,不仅能够提升开发效率和代码质量,还能确保应用程序在复杂网络环境中的稳定运行及高可维护性。

当代工作负载与软件定义网络的融合,在核心计算资源方面引发了显著的网络处理挑战。在高速度环境下,数据中心与云平台的网络基础架构已步入25Gbps至100Gbps的速度区间,并展现出进一步向200Gbps乃至400Gbps进化的趋势。这一发展对CPU核心能力提出了严苛要求,包括快速而精确地处理、分类、跟踪以及定向流量等关键任务,以确保数据传输的高效与顺畅。

计算虚拟化技术在处理虚拟机与容器之间的数据交换时,显著提升了网络负载,这一过程伴随着Overlay网络的封装操作及其对外部服务和存储设施的通信需求增加。相应地,这一架构对中央处理器产生了更高的网络负荷压力,以支持复杂的数据流通和处理任务。

CPU核心的成本颇为昂贵,且并不总是适配于高效的数据包网络处理。在执行大量带宽密集型任务时,会过量消耗宝贵的CPU资源,从而给服务器的计算基础设施造成不必要的负担与压力;这些宝贵的计算力原本应更专注于提升租户工作负载效率及优化应用程序数据处理流程。

通过集成DOCA Flow库所提供的API,用户得以充分利用BlueField Data Processing Units 与ConnectX智能网卡内置的硬件能力,从而构建出既通用又可重复使用的执行流程。每一个这样的流程通常涵盖数据包分类以及一系列定制化操作,确保了高效、灵活的数据处理和网络管理机制。

此过程采用类别来判断输入数据流应遵循的具体算法路径,而行动则对应于针对各个分类所实施的操作。通过以类别和行动作为基础组件构建方法,我们能够为开发硬件加速的网络软件提供一种高度适应性和灵活性的方案。

DOCA Flow的执行流程囊括了多种多样且各具特色的操作,旨在对网络流量实施精细化管理和优化。具体而言,这一过程涉及对于MAC地址进行网络地址转换逻辑处理、动态调整源和目的地IP地址、采用Overlay封装技术、修改报头字段信息以及通过计数器功能来量化流量数据。同时,该流程还包含策略监控、流量转发至特定队列、端口镜像与数据包采样用于调试及合法拦截,乃至直接丢弃数据包以实现对策略执行和访问控制的严格把控。所有这些操作都充分借助DPU或网卡硬件能力进行卸载处理,从而实现了高效、精确且低延迟的数据流通管理。

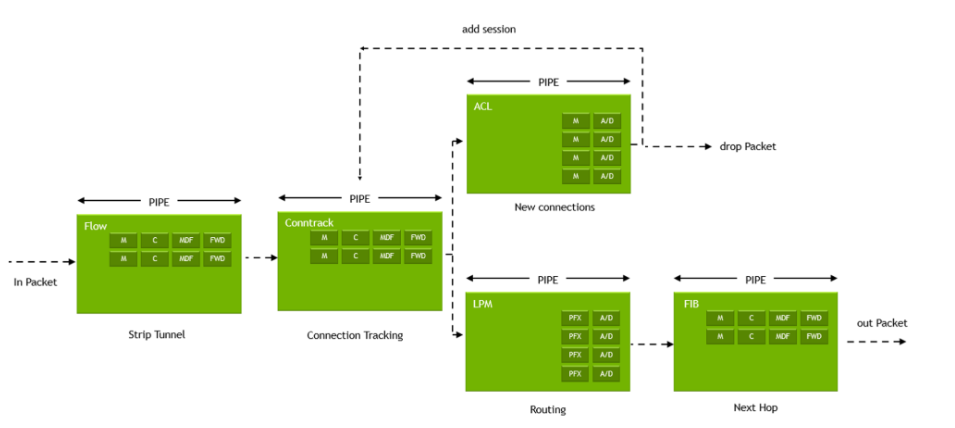

管道能够通过串联方式联结,构建成一个系统化的处理路径,这一过程确保了输入数据包的有序流转。完成针对数据包的预设操作后,该数据包可能被引导至另一条管道进行后续处理或评估;亦或者被分发至软件队列、硬件缓冲区中暂存,或是直接发送或弃用。

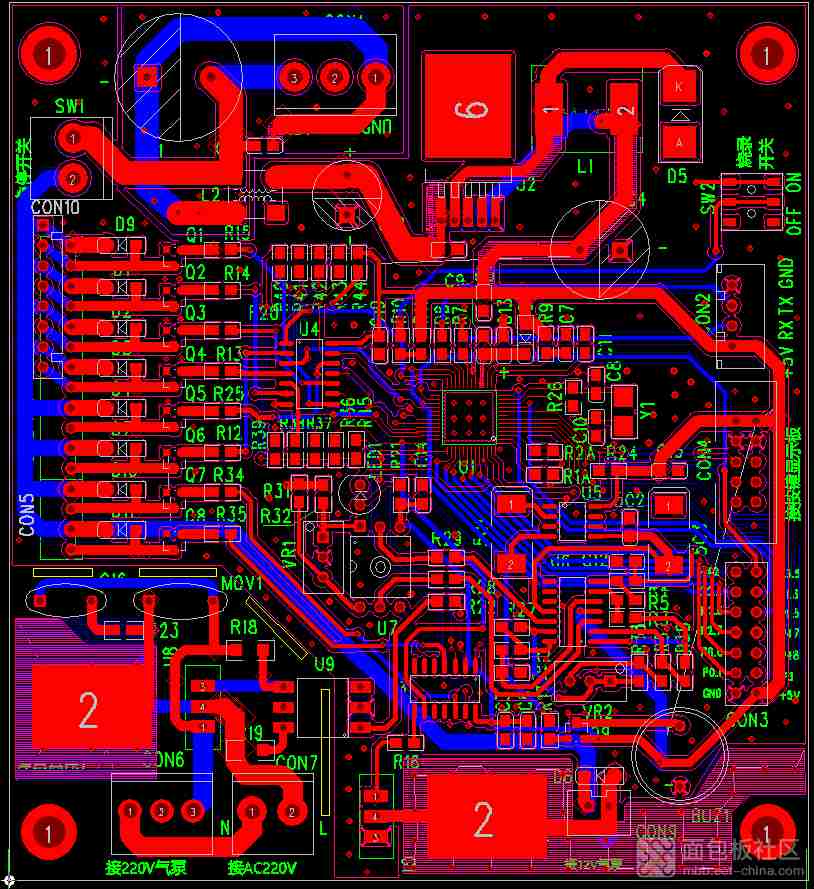

图1:管道式连接编织成一个精妙的网络逻辑结构,每一级管道专注于特定的规范、执行环节以及信息流导向,共同构筑了一张由数据包操控所引领的方向性网络。

通过实施普适性的网络功能算法,可以于DPU或网络适配卡上构建基于硬件的网络应用,此举旨在高效地分发并处理数据包流量。此方法允许对每个传入的数据包进行精确分类,并据此施加相应的操作,确保了通信流的流畅性和效率。

采用转向树这一架构性理念,能显著提升性能、降低延迟并优化资源利用率。具体优势包括但不限于:

1. 高效率:转向树提供了一种直接处理网络数据流量的方法,减少了软件层之间的传输时间,从而实现快速的数据包分类和处理过程。

2. 灵活性与可扩展性:基于硬件的解决方案能够适应多变的应用需求,并支持未来的网络技术升级,确保了系统的长期兼容性和适应能力。

3. 资源优化:通过精简不必要的软件处理步骤,转向树减少了系统负载,有效节省了计算和能源资源,同时提高了整体性能效率。

总之,转向树在DPU或网卡上的应用,为构建高效、灵活且资源优化的网络基础设施提供了强大的工具和技术支撑。

针对每一条独特数据流,精心设计并实施专属的处理策略与逻辑。

通过实施精确的数据包路由策略与配置,我们能够实现对网络流量的有效控制和灵活分配。这不仅确保了资源在特定任务或服务之间的高效流转,还提升了整体系统性能与可用性。这一过程的关键在于使用先进的路由算法、规则集以及智能化的网络管理工具,以便将数据包精确地导向预定的操作或目的地。这样做不仅能优化数据处理流程,还能显著增强网络安全和用户体验。

动态可调节结构设计精良,能够灵敏感知并响应环境的变化,从而在不同情境下自如地变换其规模与形态。

采用具有高度适应性的架构设计,此方案旨在便捷地引入及整合各类新型管道机制,以应对外部环境的持续变迁与多元挑战。通过这一策略,我们能够确保系统在面对未来可能的演进时,始终保持灵活性和前瞻性,从而满足日益丰富的用户需求和技术进步。

精简资源分配,最大程度消除重复性负担,促进共享识别与实践。

为了在BlueField Data Processing Units 与ConnectX智能网卡上构建高效的网络流水线时,DOCA Flow充当着核心组件的角色,旨在显著简化应用程序的开发流程并提升操作效率。此工具广受企业级数据中心、电信以及云计算领域内的青睐,尤其是在那些高度关注于优化数据包处理速度及强化网络安全基础设施建设的场景之中。通过采用DOCA Flow,开发者能够更加专注于业务逻辑与创新,而无需过多担忧底层网络处理的复杂性,从而实现更为高效且灵活的应用部署与管理。

作为专注于高频率构建及移除流水线的核心组件,此系统被精密设计用于管理每秒数百万个数据包交换的繁重任务。它广泛应用于软件定义网络领域,同时也能胜任数据分析、虚拟化交换、人工智能推理、网络安全等需要高效数据包处理功能的应用场景。

该系统具备灵活性,允许用户基于预设策略或其他准则来执行包括但不限于接收报文、验证头部和负载信息、监控连接状态以及对数据包进行检查、重路由、复制或丢弃等一系列关键操作。其卓越性能使之成为复杂网络环境中的理想选择,确保了在高负载压力下的稳定运行与高效处理能力。

Open vSwitch凭借其基于编程的扩展特性,实现了大规模网络自动化的目标,旨在为虚拟化环境下的虚拟机器和容器提供高效的数据包转发服务。借助DOCA Flow技术,用户空间数据平面得以加速实现DPU加速的虚拟交换机,使任何搭载了DPU的服务器均具备充当网络交换机、路由器或状态感知负载均衡器的能力。

采用vSwitch技术为多种VNF服务提供了高度的灵活性与可拓展性,这一举措不仅大幅度提升了微小数据包的传输效率,显著降低了延迟时间,而且通过优化DPU的网络性能,极大地加速了信息通信过程,有效增强了南北流量和东西流量间的连接速率及响应速度。

当然,请您提出需要改写的文本内容,我将为您提供更加优雅和高级的表述版本。请您分享具体的句子或者段落,这样我可以根据您的要求进行调整。无论是文章、标题、描述还是任何其他类型的文本,我都会尽力提供更精致的表达方式。请提供具体的内容以便开始工作。

为了应对现代网络安全环境中的新挑战,现代防火墙需提升其数据检查速率以防范不断演进的威胁。然而,随着网络基础设施速度的提升,这将显著加重CPU的工作负载,由此可能带来延迟加剧、数据包损失和网络吞吐量下降等后果。在追求速度与安全性能均衡的同时,确保不增加额外网络延时是一个技术性与经济性的双重考量难题。传统的解决方案往往意味着需部署大量防火墙以处理增强的流量负荷,此举虽能提升整体防护能力,但其高昂的成本使得这一策略并非经济可行的选择。

DOCA Flow enables the development of intelligent network filters tailored for each server hosting a DPU, facilitating traffic management with minimal CPU overhead. Leveraged through dedicated accelerators and ARM cores on the DPU, this mechanism allows for the implementation of advanced distributed Next-Generation Firewalls . By enabling precise packet filtering and forwarding based on predefined policies, while simultaneously handling data-plane offloading and control-plane management, each server is equipped to process throughput capacities approaching 100Gbps with unprecedented efficiency.

采用DOCA Flow为数据包处理提供了一种经济实用的方法,通过将该任务从CPU卸载至DPU,从而以优于传统硬件方案的方式显著提升性能并降低总体成本。此策略确保服务器在不削弱其效能的前提下,能够搭载先进的安全特性,例如入侵防御系统。此外,DOCA Flow还能够在网卡或DPU层级上实现网络流量的快速检查,极大地加速了数据传输效率。

DOCA Flow facilitates the expediting of virtualized network functions , encompassing components like routers, load balancers, firewalls, and content delivery network services. Telecommunications providers are enabled to replace proprietary hardware by developing VNFs that operate on BlueField Data Processing Units and executing virtualized workloads on standard commercial servers.

借助DPU对VNF实施加速策略,我们能够实现一种更加高效且富有弹性的技术方案,相较于传统的商用服务器配置,在设备、占用空间、散热及能耗方面均实现了显著优化。这些改进有力地缓解了冷却和物理空间方面的约束,从而为5G通信、人工智能应用、物联网设备以及边缘计算领域开拓了新的可能性与机遇。

DOCA Flow堪称是高网络速度与I/O处理需求密集型边缘负载的理想选择,诸如内容分发网络以及视频分析系统等领域。此方案特别适用于部署于通用服务器内部DPU上的边缘主机应用,其旨在通过减少对昂贵专用硬件设备的依赖来优化性能。借助DPU加速功能及Arm核心协同作用,得以大幅降低所需服务器CPU核心数量,进而实现资源效能最优化,显著节省用于资本支出与运营成本方面的投入。同时,该方案还兼顾了能源效率、冷却需求以及机架空间使用,确保整体系统运作更加高效且经济。

DOCA Flow库旨在优化现代应用的开发流程,通过显著提升数据包处理中的网络吞吐量与降低延迟,从而极大地助力于开发者的工作效率。对于采用通用商用现货服务器进行虚拟化部署,以替代传统的专有裸机硬件架构的应用场景尤为适用。

此库集成了一系列核心组件,旨在优化网络卸载性能,其中包括构建数据包处理流水线、实施最长前缀匹配以及互联网协议安全加密与解密功能。即将扩展连接跟踪和访问控制列表的特性,以增强对访问控制条目的创建及修改能力。欲深入了解 DOCA Flow 参考应用实例,建议查阅 DOCA Reference Applications 文档资料。

借助DOCA Flow的功能,企业能够在对高数据吞吐与低响应时间有严苛要求的应用场景下,显著降低总体成本、加速服务的上线速度,并最大化硬件资源的效能利用率。