随着类ChatGPT人工智能技术的快速发展,大模型作为重要的技术方向已经在许多领域取得了显著的进展,如自然语言处理、搜索引擎、图像识别和智能办公软件等。然而,由此带来的数据安全问题也越来越受到关注,包括隐私保护、数据合规和模型评估等,这些问题已成为大模型进一步发展的关键问题之一。为了解决这些问题,各国正在积极研究和探索适用于人工智能大模型的数据安全保护技术和政策。

一、类ChatGPT人工智能数据安全背景

随着人工智能的快速发展,大模型作为人工智能技术的重要发展方向,已经在许多领域取得了显著的进展,如自然语言处理、搜索引擎、图像识别和智能办公软件等。其中,由深度学习驱动的大型语言模型,如ChatGPT、PaLM等,正凭借其强大的自然语言处理能力和广泛的应用前景成为人工智能领域的研究热点和产业焦点。

然而,随着人工智能大模型的广泛应用,社会各界正面临诸多与数据安全治理相关的挑战。首先,大模型的训练通常需要大量的数据,包括来自互联网的海量文本数据,这将会涉及到对数据的搜集、存储、传输和处理,这个过程会面临隐私、安全和产权等方面的风险。其次,大模型本身具有巨大的参数规模和复杂的计算逻辑,可能会导致对模型的访问、使用和控制变得困难,从而增加数据安全治理的难度。此外,大模型在应用中还会面临潜在的模型滥用、黑客攻击和数据泄露等安全威胁,对数据安全形成了新的挑战。

二、类ChatGPT人工智能数据安全问题

当下,类ChatGPT人工智能大模型在各领域融合发展方兴未艾,这些大模型具有高度的复杂性和跨领域的知识储备,能够帮助我们从海量的数据中挖掘出更加深层的信息和知识,但同时也带来了数据安全问题。

隐私数据保护问题。随着人工智能大模型的出现和应用,隐私数据保护问题正变得更加复杂和紧迫。大模型使用的海量训练数据通常来自于维基百科、书籍、期刊和社交媒体等互联网公开数据。若某些训练数据未取得授权,则会产生数据隐私保护和数据合规方面的问题,如Twitter首席执行官马斯克就曾指责微软非法使用Twitter数据进行人工智能训练,并称会起诉微软。此外,目前用户与基于人工智能大模型的对话机器人交互的私密数据也会被人工智能公司用于训练,比如对话式人工智能大模型在训练过程中使用的基于人类反馈的强化学习算法,就会将用户的反馈用于优化模型参数,以增强模型和人类的对齐,提高对话机器人的性能,而且在训练后的模型中很难删除相关信息。如果这些数据没有得到充分的保护,就可能被不法分子获取,导致隐私数据泄露的风险增加。

数据跨境合规问题。以ChatGPT为代表的人工智能大模型正显现出与各行业融合发展的趋势,其中涉及的数据类型和来源也在不断增加,这些数据的处理和传输将涉及到跨境数据流动,从而引发了数据跨境合规问题。根据ChatGPT的运作原理,用户在对话框进行交互,相关问答数据将会传输到位于美国的OpenAI公司,在这样一个过程中,数据的跨境流动都会引发数据跨境合规问题。另外,美国OpenAI公司还推出ChatGPT应用程序编程接口,可供第三方开发者将ChatGPT模型集成到他们的应用程序和产品中。目前已有多家公司表示计划用ChatGPT技术全面改革其整个产品阵容,比如美国微软公司已将ChatGPT技术扩展到Bing搜索和Power Platform以改善相关产品的性能,而这将会导致用户数据的跨境流动更加频繁,并增加数据合规监管的难度。

黑箱模型的可解释性问题。人工智能大模型通常采用深度学习和其他机器学习技术进行训练和推理,内部存储了千万亿的模型参数,因此,大模型内部的工作方式和决策过程非常复杂,缺乏可解释性和透明度,具有这类特征的模型被称为黑箱模型,同时,这类模型也给数据安全治理带来了挑战。监管机构往往难以理解和评估这类模型的内部运作机制,从而难以制定合适的监管政策和标准。例如,欧盟《通用数据保护条例》中规定数据所有人有权要求数据持有人和处理人删除与其相关的个人数据,但针对人工智能大模型存储信息的形式,企业很难像检索数据库一样定位相关信息,简单进行个人信息的删除是很难实现的。另外,黑箱模型还会增加识别其内部潜在数据安全漏洞的难度,如果黑箱模型出现错误或被恶意攻击,很难被发现和处理,从而影响数据安全。

模型数据安全评估问题。人工智能大模型算法具有复杂的结构设计,在运作机制上容易存在缺陷和漏洞,因此,如何科学合理对模型数据安全进行评估是当前的一项严峻挑战。模型数据安全风险主要表现在以下方面:1.模型数据安全:在人工智能模型的开发过程中,需要对模型进行模型数据安全机制评估,以确保模型的数据安全性,如数据隐私保护、数据完整性保护、数据可用性保护等;2.模型数据攻击:人工智能大模型可能存在被用于攻击的漏洞,例如对抗性攻击,黑客或者恶意用户可以通过篡改模型输入数据来欺骗模型输出其他人或者机构的隐私信息;3.模型生成数据不可控:生成式人工智能大模型的复杂性和不确定性,可能会使其生成意想不到的结果,如虚假信息等。

三、类ChatGPT人工智能数据安全对策

类ChatGPT人工智能大模型在各行各业正加速渗透,逐渐演变为当今社会中不可或缺的一部分,大模型的数据安全问题也日益凸显。因此,为确保人工智能大模型数据的安全性,需要采取多层次、多维度的技术手段和法律监管措施。

政策层面

1.设立人工智能专门战略机构

人工智能技术本身具有特殊性和复杂性,影响范围广,监管难度大,其应用和发展也面临着诸多挑战和风险。因此,设立专门的人工智能战略机构是必要的。例如,日本政府计划设立新的“战略会议”,负责讨论与人工智能相关的国家战略。对于正在迅速普及的聊天机器人ChatGPT等整个人工智能领域,该战略会议将发挥指挥塔作用,指明政策的基本方向。针对人工智能方面课题,该会议将从促进应用、研究开发和强化规则两方面进行讨论。该战略会议除了包含精通人工智能技术的学者和研究人员外,还有法律相关领域的专家和政府相关人士加入。

2.明确人工智能大模型应用中责任权利的法律归属

在人工智能大模型应用中,责任权利归属是一个复杂的问题。该问题涉及多个方面,包括数据提供者、算法设计者、模型训练者和模型使用者等。目前,国内外学者主要探讨两个方面:一是如何确定人工智能大模型应用中的责任归属;二是如何建立人工智能大模型应用中的责任分配机制。欧盟在该领域进行了部分探索,例如,欧洲议会成员已经就《人工智能法》提案达成临时政治协议,要求部署ChatGPT等生成式人工智能工具的公司披露用于开发其系统的受版权保护的材料。

3.完善人工智能大模型产品的相关立法

为应对人工智能技术所带来的一系列伦理、法律和社会问题,如数据安全、隐私保护、算法透明、责任归属、公平公正等,我国有必要制定一套符合人工智能技术特点的监管法律法规,以确保我国人工智能技术在竞争性和安全性上保持平衡。

技术层面

1.数据加密和脱敏

数据加密技术可以将数据转换为一种难以被未经授权者读取的形式,从而保障人工智能大模型数据交互的安全性。这种技术在数据传输和存储过程中,能够对数据进行加密,有效防止隐私和敏感数据被未经授权的人员访问和窃取,从而保护个人隐私和商业机密信息。此外,数据脱敏技术也是保护数据隐私的重要手段,它可以通过加密、替换、删除等处理来保护敏感数据的隐私。对于人工智能大模型来说,数据脱敏技术可以在数据预处理过程中对数据进行脱敏处理,如匿名化处理、数据屏蔽处理和数据差分隐私等,以保证数据的隐私性。

2.访问控制

访问控制是一种常见的数据安全保护技术,其通过限制对数据的访问,以确保数据的机密性和完整性。在人工智能大模型中,访问控制技术的应用可以有效防止数据的非法访问、篡改和泄露,从而保障人工智能大模型的数据安全。例如,OpenAI采用了多种访问控制技术来保护其人工智能大模型GPT-3的安全,其中包括身份验证、授权和审计等措施。这些措施可以确保只有经过授权的用户才能够访问和使用GPT-3数据,有效地保护了用户的隐私信息。

3.模型物理隔离

模型物理隔离是一种有效的数据安全保护措施,可以有效地防止黑客攻击和数据泄露。例如,美国微软公司计划推出一款私有ChatGPT版本,该版本ChatGPT将在专用云服务器上运行,以保护用户隐私安全。私有ChatGPT数据将与主系统隔离,可确保隐私安全,这将适用于医疗、保险和银行等行业。

推荐

-

VCSEL芯片和光学解决方案提供商瑞识科技完成近亿元B1轮融资

VCSEL芯片和光学解决方案提供商瑞识科技完成近亿元B1轮融资

2023-07-03

-

一文带你搞懂开关电源电路

一文带你搞懂开关电源电路

2024-11-02

-

基于脱硝系统改造的自动化优化分析

基于脱硝系统改造的自动化优化分析

2025-02-20

-

阿诗特能源L1000液冷新品震撼上市,卓越性能,引领未来!

阿诗特能源L1000液冷新品震撼上市,卓越性能,引领未来!

2024-06-15

-

博世与芯驰科技全面深化战略合作 围绕车用半导体核心技术

博世与芯驰科技全面深化战略合作 围绕车用半导体核心技术

2025-04-10

-

PLL锁相环:工作原理简述,高效同步控制的核心技术。

PLL锁相环:工作原理简述,高效同步控制的核心技术。

2024-04-07

-

中科曙光助力北京航天总医院打造24小时在线的AI医疗助手

中科曙光助力北京航天总医院打造24小时在线的AI医疗助手

2025-04-10

-

国产替代奋进高端,创新引领,开启替代新篇章。

国产替代奋进高端,创新引领,开启替代新篇章。

2024-04-07

-

模拟芯片与数字芯片各有独特优势,各具魅力,吸引你的目光。

模拟芯片与数字芯片各有独特优势,各具魅力,吸引你的目光。

2024-03-06

-

本征半导体,基础材料之选,了解它,掌握电子世界的关键!

本征半导体,基础材料之选,了解它,掌握电子世界的关键!

2024-04-07

最近更新

-

TrendForce集邦咨询: 关税变量对显示器需求与售价及AMOLED上游材料的影响

TrendForce集邦咨询: 关税变量对显示器需求与售价及AMOLED上游材料的影响

2025-04-20

-

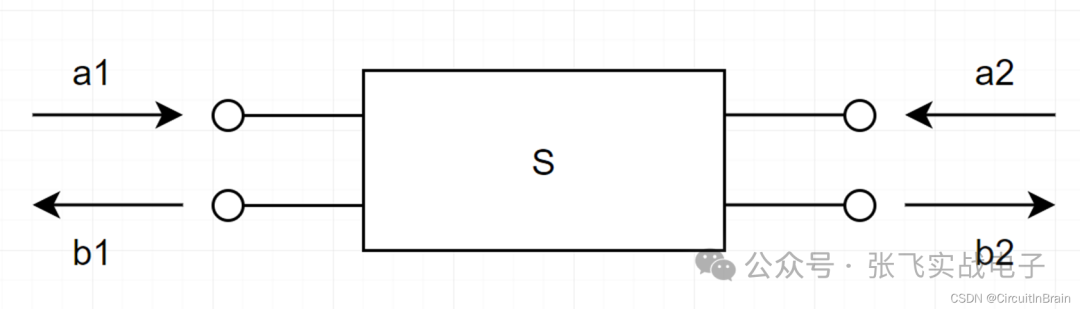

S参数与插入损耗和回波损耗

S参数与插入损耗和回波损耗

2025-04-20

-

基于SiWG917Y的无电池Wi 6传感器

基于SiWG917Y的无电池Wi 6传感器

2025-04-19

-

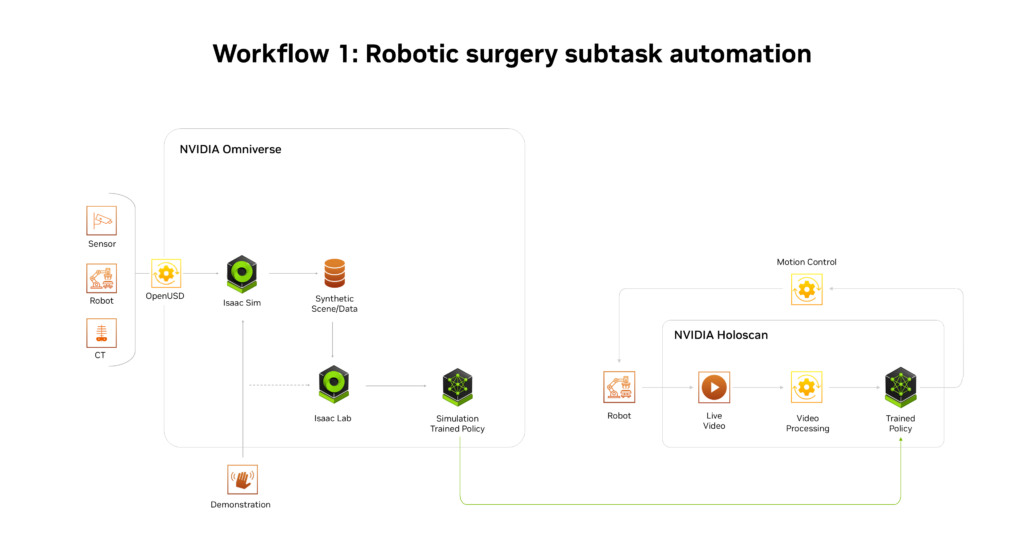

NVIDIA推出AI医疗健康机器人开发平台

NVIDIA推出AI医疗健康机器人开发平台

2025-04-19

-

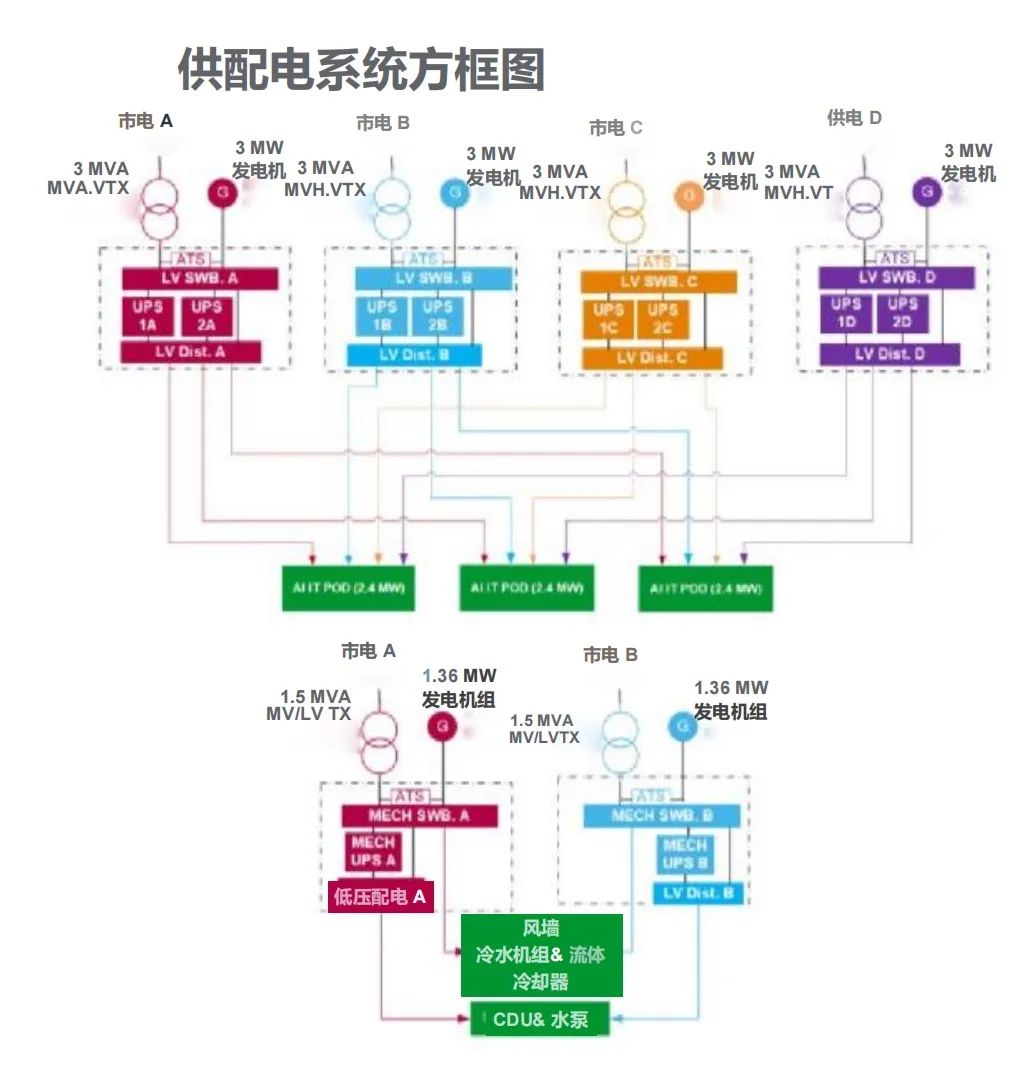

施耐德电气发布数据中心高密度AI集群部署解决方案

施耐德电气发布数据中心高密度AI集群部署解决方案

2025-04-19

-

航裕电源亮相2025慕尼黑上海电子展

航裕电源亮相2025慕尼黑上海电子展

2025-04-19

-

RECOM RACPRO1系列荣获2025年红点产品设计奖

RECOM RACPRO1系列荣获2025年红点产品设计奖

2025-04-19

-

广汽昊铂首家直营交付中心开业

广汽昊铂首家直营交付中心开业

2025-04-19

-

季丰成都实验室开启芯片微加工新篇章

季丰成都实验室开启芯片微加工新篇章

2025-04-19

-

航裕电源亮相2025俄罗斯国际电子元器件展

航裕电源亮相2025俄罗斯国际电子元器件展

2025-04-19