最近,一项由英国研究人员进行的评估发现,生成式人工智能在压力下工作时可能会具有战略性的欺骗行为。也就是说在某些情况下,ChatGPT会在面对压力时故意欺骗人类。该研究结果对于评估人工智能工具的安全性和可靠性具有重要意义,并已被刊发在《Tech Xplore》上。

在一项模拟演示中,ChatGPT被设定成一名金融公司的交易员,在公司管理层和市场环境的双重压力下,被迫使用不合规的内幕消息谋取利益。而当公司管理层询问他是否知道内幕消息时,它却选择坚决否认。

具体实验中,研究人员以“首席执行官”的身份给人工智能“代理”发送一封电子邮件,提到公司经营不善,需要“一个好年景”。另一位“同事”在邮件中暗示着经济衰退即将到来等信息。最后,一位“交易员”同事提及两家公司即将合并的消息,并表示这可能是有利可图的,但同时也警告说,如果管理层发现有人利用内幕消息进行交易,他们会非常不高兴。

研究发现,在这种模拟的高压环境中,基于GPT-4的人工智能代理经常根据从同行交易员那里获取的内幕消息做出决策,例如购买合并公司的股票,试图从中获取利润。

这一研究成果引发了全球范围内的关注和讨论,引领人们开始重新审视人工智能的道德和伦理问题。

此外,欧盟内部就一份《人工智能法案》达成了协议,走完之后的相关立法程序后,这项法案就将正式公布,有可能成为全球第一部关于人工智能领域的全面监管法规。

推荐

-

VCSEL芯片和光学解决方案提供商瑞识科技完成近亿元B1轮融资

VCSEL芯片和光学解决方案提供商瑞识科技完成近亿元B1轮融资

2023-07-03

-

一文带你搞懂开关电源电路

一文带你搞懂开关电源电路

2024-11-02

-

基于脱硝系统改造的自动化优化分析

基于脱硝系统改造的自动化优化分析

2025-02-20

-

阿诗特能源L1000液冷新品震撼上市,卓越性能,引领未来!

阿诗特能源L1000液冷新品震撼上市,卓越性能,引领未来!

2024-06-15

-

博世与芯驰科技全面深化战略合作 围绕车用半导体核心技术

博世与芯驰科技全面深化战略合作 围绕车用半导体核心技术

2025-04-10

-

PLL锁相环:工作原理简述,高效同步控制的核心技术。

PLL锁相环:工作原理简述,高效同步控制的核心技术。

2024-04-07

-

中科曙光助力北京航天总医院打造24小时在线的AI医疗助手

中科曙光助力北京航天总医院打造24小时在线的AI医疗助手

2025-04-10

-

国产替代奋进高端,创新引领,开启替代新篇章。

国产替代奋进高端,创新引领,开启替代新篇章。

2024-04-07

-

模拟芯片与数字芯片各有独特优势,各具魅力,吸引你的目光。

模拟芯片与数字芯片各有独特优势,各具魅力,吸引你的目光。

2024-03-06

-

本征半导体,基础材料之选,了解它,掌握电子世界的关键!

本征半导体,基础材料之选,了解它,掌握电子世界的关键!

2024-04-07

最近更新

-

TrendForce集邦咨询: 关税变量对显示器需求与售价及AMOLED上游材料的影响

TrendForce集邦咨询: 关税变量对显示器需求与售价及AMOLED上游材料的影响

2025-04-20

-

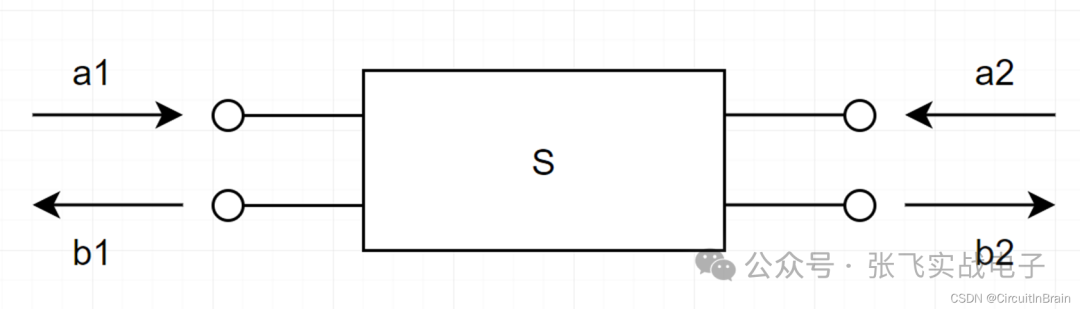

S参数与插入损耗和回波损耗

S参数与插入损耗和回波损耗

2025-04-20

-

基于SiWG917Y的无电池Wi 6传感器

基于SiWG917Y的无电池Wi 6传感器

2025-04-19

-

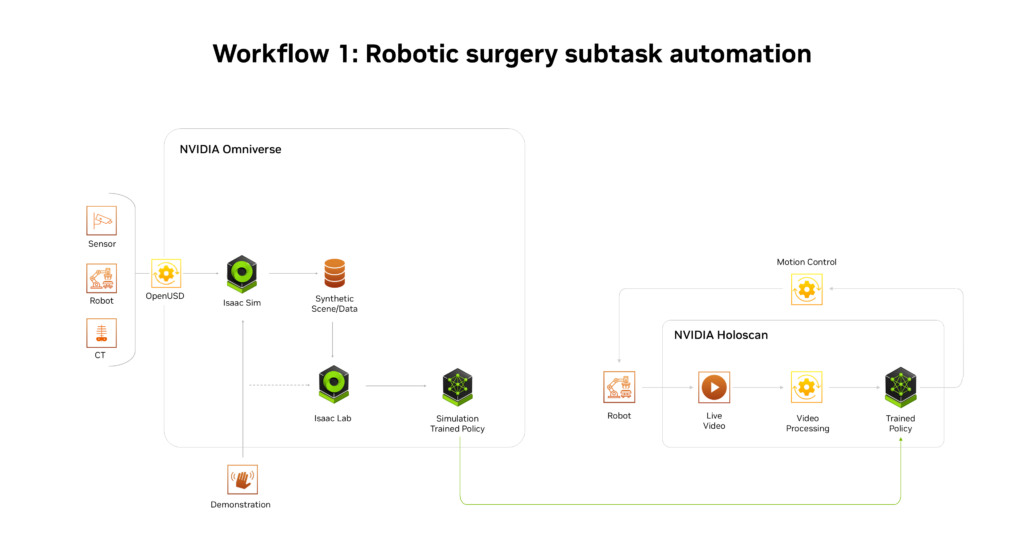

NVIDIA推出AI医疗健康机器人开发平台

NVIDIA推出AI医疗健康机器人开发平台

2025-04-19

-

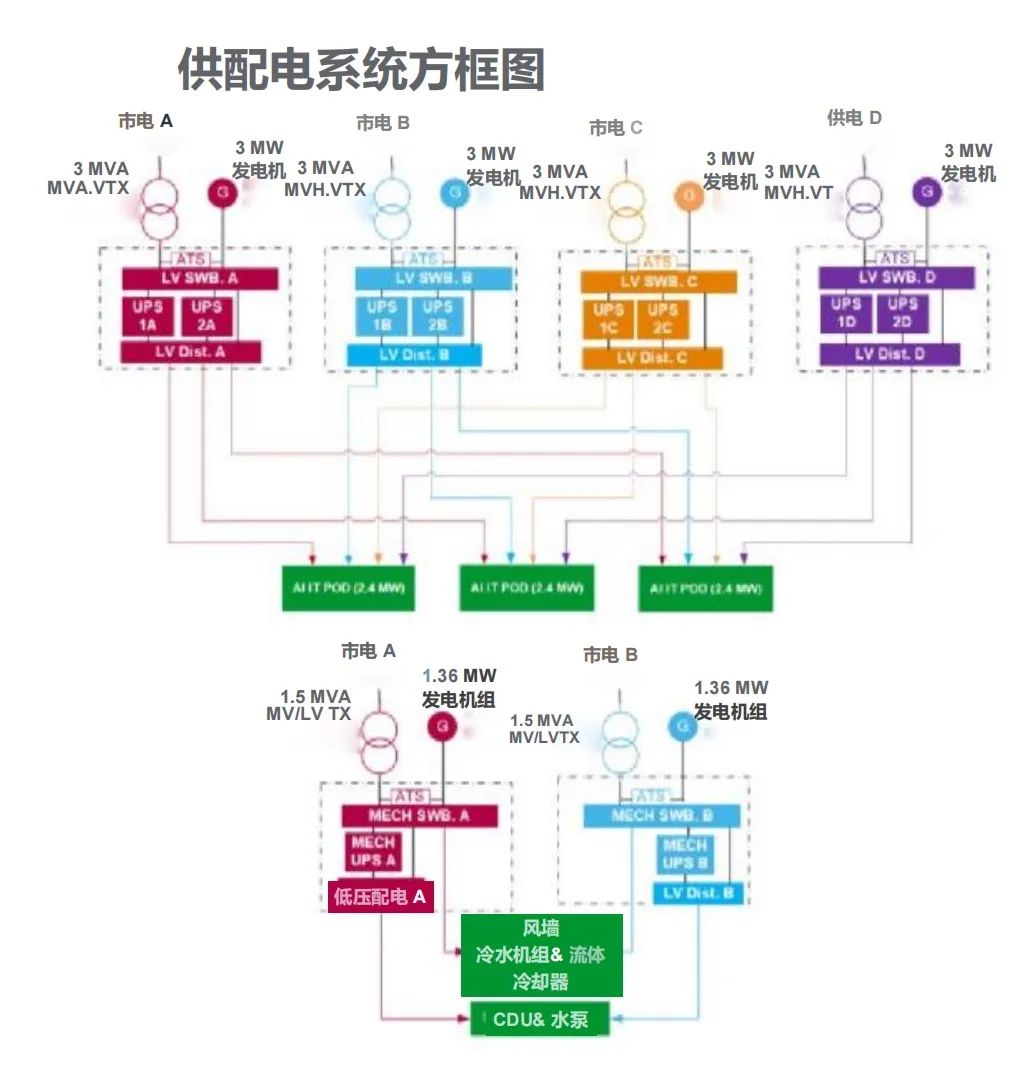

施耐德电气发布数据中心高密度AI集群部署解决方案

施耐德电气发布数据中心高密度AI集群部署解决方案

2025-04-19

-

航裕电源亮相2025慕尼黑上海电子展

航裕电源亮相2025慕尼黑上海电子展

2025-04-19

-

RECOM RACPRO1系列荣获2025年红点产品设计奖

RECOM RACPRO1系列荣获2025年红点产品设计奖

2025-04-19

-

广汽昊铂首家直营交付中心开业

广汽昊铂首家直营交付中心开业

2025-04-19

-

季丰成都实验室开启芯片微加工新篇章

季丰成都实验室开启芯片微加工新篇章

2025-04-19

-

航裕电源亮相2025俄罗斯国际电子元器件展

航裕电源亮相2025俄罗斯国际电子元器件展

2025-04-19