Google has long cherished the transformative power of virtual reality, yet to achieve the most immersive experiences possible within VR environments, the visual content showcased therein must aspire ever closer to matching real-world perceptions.

光场技术代表了一种前瞻性捕捉、整合及呈现图像的方法,其通过生成丰富的运动视差以及极其逼真的纹理与光照效果,为用户带来了无与伦比的沉浸体验,实现了顶尖级别的画面真实感。为了进一步探索并展示这一创新领域的潜力和魅力,谷歌曾提供一款名为“Welcome to Light Fields”的免费应用,该应用兼容Steam平台,并支持HTC Vive、Oculus Rift以及Windows MR头显等先进的虚拟现实设备。

在光场环境中,邻近的物体仿佛与您亲密无间,其呈现的视觉效果随您的头部转动而显著变化;相比之下,远处的物象则相对稳定,各元素之间光线的差异性赋予了空间以三维的深度感,令沉浸体验愈发逼真。借助支持位置追踪技术的虚拟现实头戴设备浏览时,捕捉自实际场景的光场片段得以实现一场令人叹为观止的全息视觉盛宴,将您彻底融入一个栩栩如生、仿佛触手可及的虚拟世界之中。

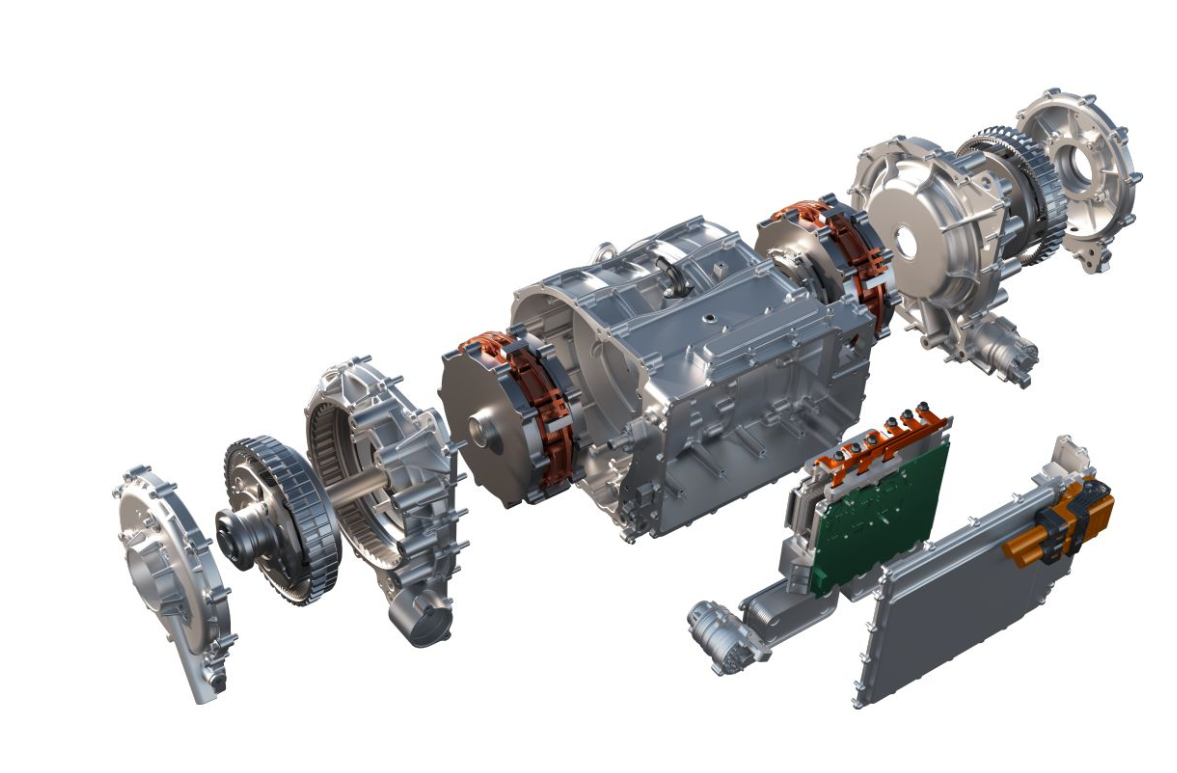

由于光场能够捕获及保存贯穿整个空间的每一束光线信息,从而实现三维场景的完整复原与交互体验,谷歌对一台GoPro Odyssey Jump相机系统进行了精心改造。他们将这套设备弯曲成一个包含16个镜头的垂直弧形,并整合至一旋转平台之上。此举旨在通过这种独特配置,全面捕捉并记录环境中的光线,以期在虚拟现实中还原真实的光影效果与空间感。

相机系统以每分钟一百个视角旋转并捕获70厘米直径的球体图像,创建一个覆盖两英尺宽光线轨迹的详尽视图库。该光线分布定义了顶部空间的容量,即用户可通过头部转动探索场景的空间范围。

为了生成与头部运动相匹配的视图,谷歌采取一种创新方法:在球面表层上采样光线,由此构建出新视角下的内部景象,并确保这些视角与用户头部移动的方式相协调。通过一种定制的数据集文件对这些视角进行整理和压缩,这一过程得以优化以适应VR环境。

谷歌使用一种专为Unity游戏引擎设计的特殊渲染软件,通过读取此数据集来实现视图的实时渲染。这种独特的方法允许在沉浸式虚拟现实中提供流畅、身临其境的体验,并确保了对复杂场景的高效处理和响应能力。

Google精心挑选了几处独特的地点,以测试其先进的光场相机平台。他们对加博住宅那镀金的柚木和红木装饰品产生了浓厚的兴趣,威尼斯马赛克小屋闪烁着光泽的陶瓷瓷砖令人心醉神迷,而格拉纳达山圣斯蒂芬教堂内色彩斑斓的玻璃窗在阳光下熠熠生辉。尤其重要的是,史密森学会的航空航天博物馆及3D数字化部门提供了难得的机会,得以深入探索NASA发现号航天飞机的秘密世界,在这个鲜为人知的飞行甲板上,我们得以从宇航员的角度进行沉浸式体验。通过这些精心挑选的空间,Google不仅录制了丰富的光场素材,还创新性地探索了眼神接触如何为6自由度的互动体验带来革命性的变化。

虚拟现实视频乃开拓认知疆域之明灯,即使尚在研发阶段,光场技术已昭示出其潜能,预示着沉浸式体验即将达到的细腻层次,令人憧憬不已。

通过一幅图像的对比展示,我们可以清晰地揭示出360度全景视频与虚拟现实视频之间的独特差异:前者宛如一幅广阔的画布,捕捉了周围环境的所有维度视角;而后者则仿佛将观众置于一个完全沉浸的空间之中,提供了一种身临其境、全方位交互的体验。

全景视频的独特之处在于其超越了传统的线性观影体验,赋予观众以全然沉浸式的视觉探索方式,使其能够在任何维度上自由漫游并全方位地感知影像内容。而VR视频技术则更进一步,不仅提供了全景视域的便利,还实现了在虚拟场景中的任意位置移动和360度无死角的视角转换,让用户体验仿佛置身于故事之中,与之互动,开创了一种全新的沉浸式娱乐和信息接收模式。

全景视频可能具备三维效果,亦可仅呈现二维视域,观者既可在常规屏幕上体验其全息景象,亦或借助特定设备如眼镜以沉浸式视角享受其内容。与此形成鲜明对比的是,虚拟现实视频专为佩戴头戴式显示器的用户设计,确保提供完全身临其境、三维的观看体验。

拓展与改写的目标在于提升表述的美感、优雅和高级感,并通过调整语句结构来强化表达的艺术性,同时保持原始信息的完整性。此过程中,着重于词汇的选择、句子的流畅度以及整体风格的一致性,力求使文字更加生动、精致且富有深度,以更好地传递作者或演讲者的意图与情感。

在重写上述内容时,首先保留了核心概念和事实,即全景视频与VR视频在观看方式和3D需求上的区别。接着,通过使用更丰富的词汇来提升描述的感官性和情感色彩。此外,调整了句型结构以创造一种流畅而有节奏感的语言风格,使整段文字听起来更为和谐且优雅。

这样的改写方法不仅增强了文本的艺术性,而且在无形中提升了读者的阅读体验,使其更加沉浸在内容之中,同时也体现了对语言表达的一种尊重和追求卓越的态度。

全景视频采用线性播放方式,遵循时间顺序进行展示;相比之下,虚拟现实视频赋予观众沉浸体验,允许他们在同一刻同时探索多个视点,犹如科幻电影中描绘的场景——时间静止,观察者可以在固定的时间与空间框架内自由移动,全方位审视周围的人物与环境。

一切皆可呈现出三维的效果,包括全景观视影像,其同样提供二维视角版本。

可以全方位无死角地进行三维旋转查看。

拥有视觉沉浸感的特性,使得用户在浏览过程中能完全沉浸在内容之中,仿佛置身于故事或信息的中心,获得深度且丰富的体验。这不仅增强了互动性和参与度,还激发了情感共鸣和记忆留存,为在线平台增添了独特的吸引力与价值。通过精心设计的布局、色彩搭配以及流畅的动画效果,网站能够营造出一种身临其境的感觉,让访问者在探索过程中享受到更加细腻、全面而愉悦的感官体验。

相比之下,虚拟现实视频赋予了观众前所未有的沉浸式体验,他们仿佛置身于故事的核心,能够自由探索场景的每一个角落;而全景视频虽然提供了广阔的视觉覆盖范围,但观众的活动被固定在拍摄者的位置上,仅能以原地旋转的方式领略景象的全貌。由此观之,VR视频的独特之处在于其互动性与沉浸感,允许用户随心所欲地移动和探索虚拟环境。

若将VR电影视作一种全新的叙事载体,其呈现方式自然迥异于传统影视作品。在这一媒介中,“镜头运动、场景切换、Zoom In or Zoom Out”等元素被颠覆性地重塑为观众的直接交互体验。观众能够成为故事探索的核心参与者,自由选择并定义他们所见的角度与深度。

想象一部VR电影犹如沉浸式空间的艺术结晶,融合了“三维全景影像”的感官冲击和“自由移动”的互动性。这种全新的观影方式,不仅打破了屏幕的界限,更彻底颠覆了线性的叙事流程,将观众置于故事舞台的中心,以第一人称视角探索虚拟世界,体验前所未有的情感共鸣与沉浸感。

当前广泛认知与展示的所谓"伪VR视频"以及各大平台标注的VR内容,实际上大体上指的是360度全景视频。同样地,那些以"VR相机"为名宣传推广的产品,多数实际上都是360度全景摄影设备。然而,我们不禁质疑并追问:真正的虚拟现实视频应当具备怎样的特质与呈现形式呢?

尽管目前的技术框架与设备能力尚不足以实现真正的VR视频拍摄,直至今日,我们仍未见证过任何一部由实际拍摄制成的VR影片问世。这是因为,一台摄像机仅能够捕获单一视角的光线信息;而为了实现场景中的自由探索体验,则需全面捕捉每个位置的光线细节——显然,于实景中布设如此之多的独立摄像装置实为奢望,此乃根本性的悖论所在。

至于谷歌光场技术是否能破解这一难题?答案并未明确。该技术致力于在二维图像中模拟三维空间感,旨在提供接近真实世界的视觉体验。然而,要真正实现全面、沉浸式的VR视频拍摄,不仅需要在物理层面上解决多点光线捕捉的挑战,还需在数据处理与算法优化上实现重大突破,以确保各视角间无缝衔接、流畅过渡,且能完美还原虚拟空间中的细节与动态。

综上所述,尽管谷歌光场技术等创新为增强现实体验提供了可能,但要将之应用于真正的VR视频拍摄并达到成熟阶段,仍面临多重技术和实施层面的复杂难题。因此,在这一领域取得实质性进展之前,我们还需耐心等待更多技术创新与实践的推进。

无疑,未来的可能性极为广阔且充满想象的空间。

光场摄像机乃现代影像技术之瑰宝,其奥秘在于凭借密集排列的微小感光元件阵列,精确捕获并记录环境中的光线信息。通过这一独特机制,设备能够收集不同方位入射的光线信号,进而运用先进算法在后端合成出任意视角的图像场景。此等科技实乃视觉捕捉与处理领域之黑科技,展现了人类对光学与计算融合的深刻理解与创新应用。

Immerge 构建在其内部集成的成百上千个镜头与图像捕捉器之上,这些组件被精细地划分为五个层次——您可将其设想为每个层次汇集了二十台 GoPro 高清相机的集合。此外,系统还配备了专门定制的服务器以及专业编辑工具,旨在提供全方位的支持与优化工作流程。

相比之下,光场摄像机在捕捉影像时所具备的独特之处,在于它不仅能够记录像素点的色彩与亮度数据,更进一步地,还能捕获光线投射的方向性信息,这正是我们通常所说的"光场"技术的核心所在。

借助于自各个方向投射进来的光线所携带的方向性信息,并通过采用先进的算法进行解析与重构后,我们能够对周围环境实施深入的分析和构建,进而生成一个精确的三维空间映像。这项技术与计算机图形学中的模型创建有异曲同工之妙,但其核心差异在于:CG侧重于基于主观想象和创意的“创造”过程;而光场摄像系统则致力于通过客观的数据收集与解析,实现对环境的“还原”。

借助于三维模型,计算机能够即时生成任何点位上的视觉画面,无论是常规三维视图还是全方位三百六十度全景皆可实现。确切而言,光场摄像机捕捉的场景代表了现实中的视觉体验,而后续变换视角所见则是由计算机动态合成的真实再现。

Lytro Company currently acknowledges that they are capable of facilitating a limited mobility for the viewer's perspective, enabling movement primarily to the sides and in front or behind. However, achieving an observation of objects from their backside remains beyond reach; computations and modeling for reflected light would be required for such feats.

For realizing genuine Virtual Reality video content, it might prove simpler to opt for a methodology that involves computer-generated models and real-time rendering outputs.

当今时代,每一款VR游戏实质上皆可归类为VR视频,不仅实现了三维立体呈现与全方位视角体验,更令人惊艳的是,用户还能在其间自由穿梭和操控时间线。尽管如此,即便已借助计算机建模技术实现这一壮丽的视觉奇观,人们依然对VR视频的拍摄过程充满好奇与期待。

探讨这个话题无疑能够深入揭示VR内容创作的核心奥秘,包括但不限于场景设计、角色动画、交互逻辑以及实时渲染等关键技术细节。通过了解这些幕后故事,我们不仅能够更全面地领略VR世界的魅力,更能激发更多创新灵感,推动这一领域的持续进化与突破。

因此,是否继续深入探讨VR视频的拍摄过程,以期共同探索其背后的制作艺术和技术创新呢?

尽管全景视频被部分人士视作"非纯正"的虚拟现实视频,但它无疑代表了虚拟现实技术的入门级形态。通过结合3D效果,全景视频能够创造出引人入胜的空间体验,较之传统视频而言实现了显著的进步,并且其应用范畴极为广泛。因此,探索和实践这一领域不失为一项极具价值的选择。

未来,虚拟现实的呈现技术将呈现出多维度的发展态势,头显设备领域有望突破现有局限,从单一平面屏幕向着更为精确、直观的光场化方向迈进。国内外的研究机构,如Magic Leap等先锋力量,正在致力于开发具有光场特性的真实感头戴显示系统,这类装置能够使用户在虚拟物体的不同深度上获得聚焦体验,超越了传统显示屏的束缚。

此外,在应用模式层面,谷歌所展示的《欢迎来到光场》提供了一个极具启发性的案例。这一领域仍然存在广阔的探索空间,尤其是如何实现虚拟光场与现实世界的无缝融合,以及自然、流畅的人机交互方式,成为了学界及产业界的共同关注焦点。未来的研究将围绕这些方向深入探讨,旨在创造出更加沉浸、逼真且互动性更强的VR体验。